英语原文共 10 页,剩余内容已隐藏,支付完成后下载完整资料

COCAS:一个用于再识别的大规模换衣人员数据集

摘要

近年来,人们在重新识别身份(re-id)方面取得了很大的进展。Market1501、CUHK03和DukeMTMC等多个学术基准对推动研究具有重要意义。据我们所知,所有现有的基准都假设每个儿子都穿同样的衣服。在现实世界中,一个人经常要换衣服。为了解决换衣人身份识别问题,我们构建了一个新的大规模的换衣人身份识别基准COCAS,它为不同的衣服提供相同身份的多个图像。CO-CAS共包含62382张人体图像,每个儿子5266张。在COCAS算法的基础上,提出了一种新的换衣服问题的个人识别码设置方法,该方法的查询包括一个衣服模板和一个换另一件衣服的个人图像。此外,我们还提出了一个双分支的生物识别服装网络(BC-Net),在我们的设置下,该网络可以有效地集成生物识别和服装特征。实验结果表明,利用服装模板进行服装换号是可行的。

1、介绍

“2015年12月29日,星期二,一名白人女顾客走进科梅里卡银行,说她被一枚炸弹武装并索要钱财。女嫌犯拿着一笔数额不详的现金逃走了。录像显示嫌犯在自助洗衣店后面跑,换衣服,向北逃向I-94服务车道。

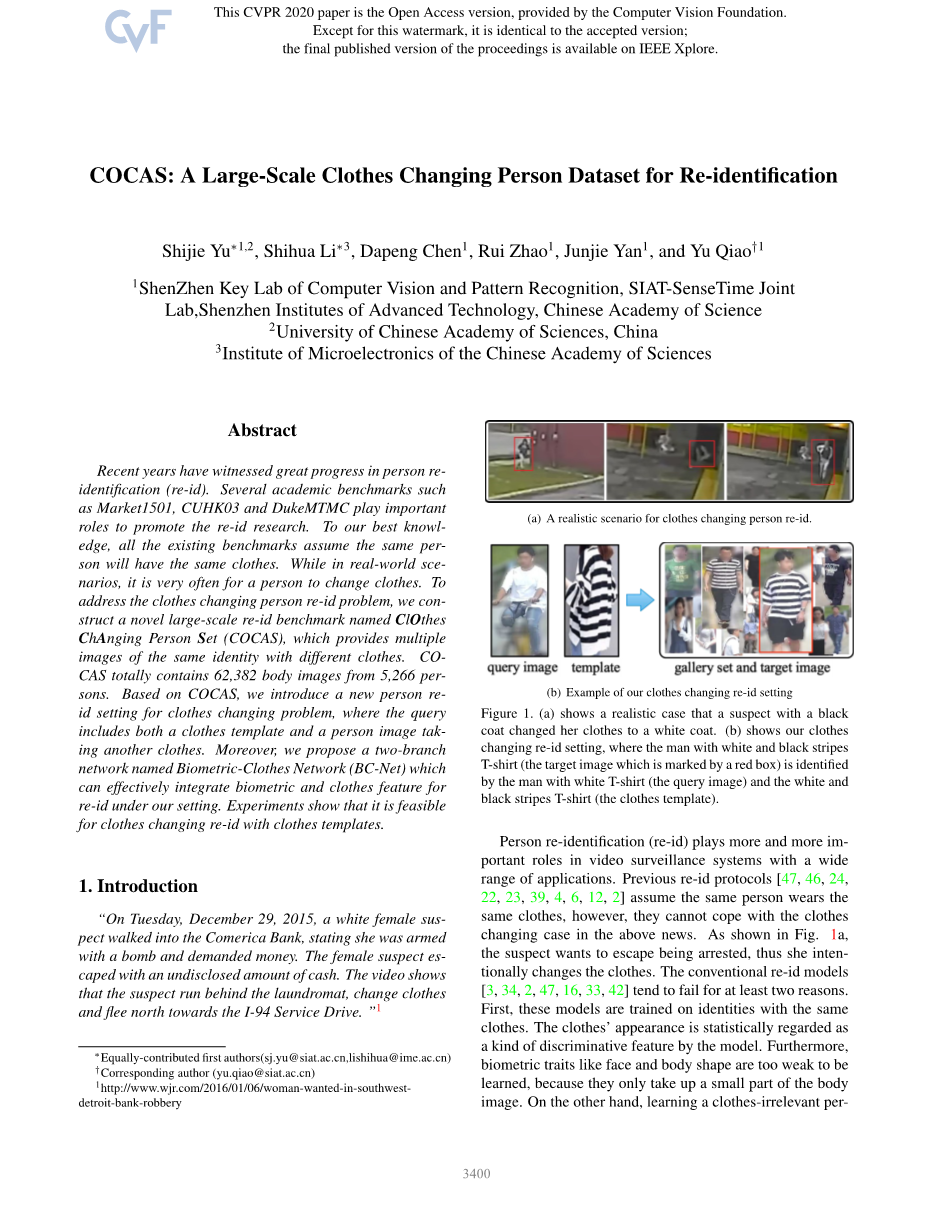

“图1。(a) 展示了一个现实的案例,一个穿着黑外套的嫌疑人把她的衣服换成了白外套。(b) 显示了我们的衣柜和身份证设置,其中白、黑条纹T恤(目标图像用红框标记)由白T恤(查询图像)识别,而白、黑条纹T恤(服装模板)人员再识别(re-id)在视频监控系统中扮演着越来越重要的角色,具有广泛的应用前景应用。以前的re-id协议[47,46,24,22,23,39,4,6,12,2]假设同一个人穿同一件衣服,但是他们无法处理上述新闻中的衣服交换案例。如图1a所示,犯罪嫌疑人为了逃避被捕,故意换衣服。传统的re-id模型[3,34,2,47,16,33,42]往往至少在两个月内失效原因。首先,这些模型都是训练在同一身份上的sameclothes。该模型将服装外观作为一种识别特征进行统计处理。此外,像脸和体型这样的生物特征太弱了,无法识别,因为它们只占身体图像的一小部分。另一方面,学习一个与衣服无关的模型也很困难。如果只利用不清晰的人脸和体形,该模型很难应用于大规模的人体图像集信息。我们相反,考虑一个更简单但实用的衣服更换re-id问题,如图1b所示:通过衣服模板图像和穿着另一个衣服的同一个人的图像来搜索一个人的图像(目标图像)衣服(查询图像)。与现有的re-id设置相比,这种设置利用了服装模板,仍然有着广泛的实际应用。举两个例子,为了找到丢失的孩子/老人,这个家庭只需要提供一张丢失的孩子/老人的近照和一张孩子/老人穿的衣服的图片。对于服装异样的跟踪,警方可以通过一幅拍摄的图像和一个机智的描述或留下的服装模板找到更多相关的图像嫌犯。去为了解决这个问题,我们建立了一个大规模的基准点,命名为ClothesChanging Personse(COCAS),基准点包含62832张人体图像,每个儿子5266张,每个人有5sim;25张图片和2sim;3张图片衣服。为了每个人,我们把一种衣服的图像移到图库中,这些图像就是目标图像。我们还从网上找到了一个衣服模板,它和每个儿子的目标图片中的衣服相似。所有剩余的图像都放入查询中套入事实上,收集如此大规模的与人有关的数据是不平凡的。在第三节中,我们将详细描述数据收集、人与衣服关联、隐私保护策略和协议定义。提出了一种具有两个分支的生物特征服装网络(BC-Net),一个分支提取人脸、体形、发型等人体特征。另一个分支提取衣服特征,查询图像和目标图像的输入是不同的。一幅服装图像是利用服装模板作为分支来更好地匹配目标图像,而一幅目标图像是利用服装检测模块从中获取一幅服装图像本身。在总结,本文的主要贡献有三个方面:(1)定义了一类由人体图像和服装模板组成的换衣识别问题。(2) 建立了一个新的大规模服装识别数据集COCAS。(3)提出了一种BC网络,通过提供目标图像的服装模板,将与服装相关和与服装无关的信息进行分离,使服装识别问题成为可能。进行了包括服装外观如何影响识别率在内的交互烧蚀研究。BC网络的性能表明,采用服装模板可以促进服装识别率的变化。

2、相关工作

重新识别数据集。大多数近年来,人们对人的再识别的研究主要是基于数据驱动的方法[47,16,49,33,42],出现了大量的人的再识别数据集在这些数据集中,VIPeR[14]是最早也是最常见的数据集,包含632个身份和1264个图像,由2个摄像头捕获。ETHZ[32]和RAiD[10]分别包含148个身份的8580个图像和43个身份的6920个图像。这些数据集的一个不足是数据规模太小,不能完全支持深层神经网络的训练。随着深度神经网络的发展,包括CUHK03[24]、Market1501[47]和DukeMTMC[51]等在内的多个大规模数据集变得流行起来。随着性能增益在上述数据集上逐渐饱和,新提出的数据集变得越来越大,包括Airport[18]、MSMT17[39]和RPIfield[48]方法。

图4。将同一个人的图像关联起来的管道。(1) 具有无序身体图像的数据集。(2) 人脸检测和锚定图像选择。(4) 基于人脸特征的K近邻搜索。(5) 手工标注k近邻,选择真正匹配的人。红色框是显示注释结果的示例。(6) 最后的数据集,每个人有不同类型的衣服

早研究人员集中在特征提取[38,28,9,11]或度量学习[19,26,5,29]上。最近的方法主要得益于CNN架构的先进性,它以端到端的方式学习这两个方面[7,25,20,37,42,40]。我们的工作可以定位为一种深度神经网络。通常情况下,通过将每个人看作一个特定的类[41],可以简单地用识别损失来训练识别问题。通过深度相似性学习,识别问题是训练一个具有对比损失的相似网络[35,36],其任务是缩小同一个人的图像之间的距离,并扩大图像之间的距离不同人物的形象。有几种方法利用三重态丢失来加强图像三重态之间相对距离的正确顺序,即正图像对比负图像对更相似,即相同的锚图像[8,1]。我们的方法不同于以往的身份识别方法,它的查询既包括人像,也包括衣服模板,采用双分支网络提取生物特征和衣服特征,由鉴定丢失和三重胎共同监督损失。

衣服Re变化-ID.衣服Read是一个可以避免的话题,但由于缺乏大规模的现实研究,对它的研究还很少数据集。那里有几项有关换衣的工作-身份证:雪耶特el.[43]基于相册中的人物(PIPA)数据集,重点关注照片中的人物识别[45]。[21]中的工作基于RAP[21]构建的子数据集,其中235个身份已经换了衣服。此外,生成性对抗网络(GAN)也应用于服装变革。杰切维特·艾尔(Jetchevet el)[17]引入了条件类比,甘托把这个人的衣服换成了目标衣服。Zhengetel[50]提出将人物形象分解为外观和结构,然后将其重新组合,生成不同服装的新人物形象。

3、COCAS基准

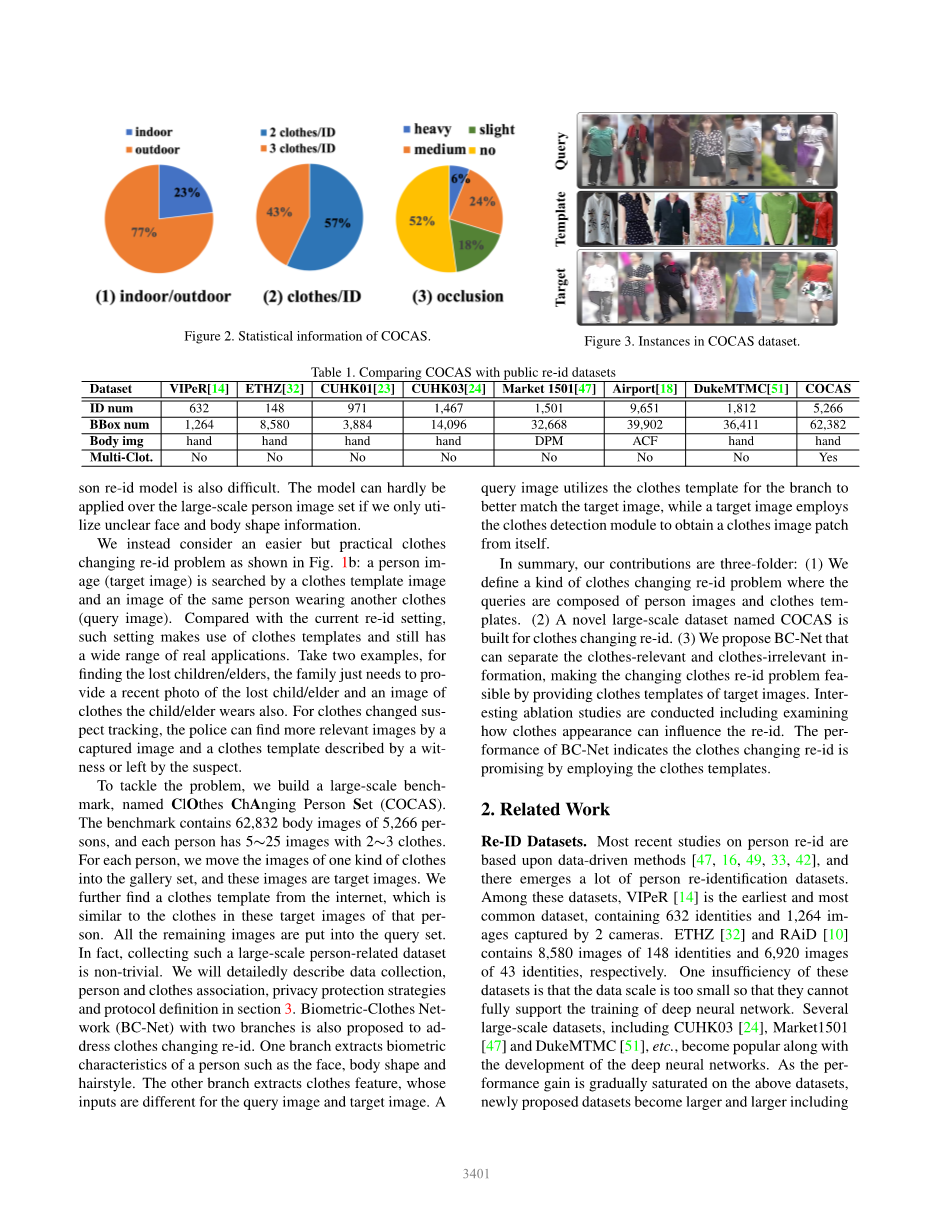

COCAS是一个大规模的个人识别基准,它为同一个人提供不同的衣服。它包含5266个身份,每个身份平均有12个图像。图像在不同的真实场景(30个摄像头)中捕获图像,包括不同的照明条件(室内和室外)和不同的遮挡条件。与现有re-id基准的比较如表1所示,从COCAS数据集获取的几个实例如图3所示。

数据收藏.COCAS收集于多个商品交易市场,我们获准在室内外放置30台摄像机。我们招募了那些不介意出现在数据集中的人(我们承诺为了个人隐私而清除面部区域)。由于人流量大,可以观察到足够多的身份。由于有些人每天都到市场来,而且数据是在4天内收集的,所以很有可能用不同的方法捕捉到他们的图像衣服。衣服在采集到的人像的基础上获取模板图像。我们首先用人类解析模型LIP[13]从人体图像中裁剪出衣服补丁,然后用图像搜索引擎从互联网上搜索相应的衣服模板。

个人协会。现在我们已经收集了我们需要的数据,但是如何将同一个人的图像与不同的衣服联系起来是非常重要的。在如此庞大的图像数据库中,一幅幅幅地标注图像是一件很尴尬的事情。如图4所示,关联有4个主体步骤:人员聚类:我们根据re-id功能对相似的人物图像进行聚类,并手动删除系统中不同人物的外部图像cluster.face检测[44]:我们从每个簇中选择一个图像作为锚定图像,并从anchor中检测人脸图像图像。脸检索:我们通过FaceNet[31]提取面部特征,并搜索每个锚点的前k个相邻锚点图像图像。手动注释:我们将与锚定图像相对应的身体图像可视化,并手动选择真正匹配的相邻图像。基于关联结果,我们的数据集范围如下。对于每个人,我们选择2或3件不同的衣服,每种衣服有2sim;5件图像。图像其中一种衣服被移动到库集合作为目标图像,而另一种衣服被移动到查询集合作为查询图像。水平分区的分区如图5所示。

隐私保护。我们对选定的人体图像的特定区域进行模糊处理,以保护个人信息,包括人脸、时间和位置。更详细地说,MTCNN[44]被用来获得面边界框,LIP[13]也被用来分离背景和身体区域。然后我们应用高斯滤波器来模糊面部和背景区域,我们称之为脱敏COCAS。实验(第5.2节)表明,如果使用脱敏COCAS,性能会有所下降,但我们相信脱敏COCAS仍然是有价值的。这是因为面部不可能总是清晰的,背景也不应该成为现实身份问题的歧视性因素。在本文中,大多数实验是基于脱敏coca。

变化。我们解释COCA的变化。图2绘制了这些特征。(1) 室内/室外。根据拍摄的位置,将所有的人物图像分成两组,包括“室内”(23%)和“户外”(77%)。室内外指示不同的白细胞介电照明条件。(2) 衣服/人。2264个身份(43%)有3种不同的衣服,3002个身份(57%)有2种不同的衣服。(3) 遮挡。遮挡的人图像意味着图像被汽车、树木或其他人等障碍物遮挡。我们还重新得到了一个情况,即人的区域是在图像之外的一种遮挡。图像分为四组,包括“重遮挡”(6%)、中等遮挡(24%)、轻度遮挡(18%)和“无遮挡”(52%)。

协议。实验协议定义为跟随。图像其中2800人用于培训,2466人用于测试,如图5所示。在测试过程中,我们从2466人中选取15985张图片作为查询图像,并将其他12378张图片作为测试集图库中的目标图像。我们使用查询图像和衣服模板搜索目标图像。由于查询图像在库集中有多个目标图像,CMC曲线能较好地反映大多数相似目标图像的检索精度。此外,我们还采用了mAP(mean Average Precision)来反映所有目标图像的总体排名性能。

图5。COCAS数据集的分区。垂直分区是指根据人员ID设置的培训集和测试集。Hori zontal分区根据衣服将COCAS划分为查询集和库集ac。查询集由查询图像和CloseTemplates组成,而库集由目标图像组成。

4、研究方法

根据我们的协议,我们需要从一个相似的衣服模板设置的图库中搜索tar-get图像和另一个穿着不同衣服的人的图像。因此,查询图像中的生物特征和服装模板的外观有助于目标图像的搜索。因此,我们提出了两个分支的生物测量服装网络(BC-Net):一个分支提取人体生物特征,另一个分支提取服装特征。生物特征分支以子图像为输入,利用掩码模块对衣服无关信息进行挖掘。clothesfeature分支将衣服图像(衣服模板或检测到的衣服补丁)作为输入,生成衣服特征。最终的人物表示结合了生物特征和衣服特征。

4.1. 网络结构

BC-Net有两个分支,分别用于提取生物特征和服装特征。BC网的整体架构如图6所示。

图6。(1) BC-Net的体系结构。它包括两个主要分支:生物特征分支和服装特征分支。在这两个流的末端,生物特征和衣服特征被连接起来,然后通过一个完全连接的层来获得最终的256维特征。注意,基于快速RCNN的衣服检测器用于从目标图像中获取衣服补丁。(2) 掩码模块的详细信息。在卷积层之后,通过对每个信道进行softmax操作对特征映射进行归一化,然后采用基于信道的max池来获得掩模。最后,通过在掩模和输入特征映射之间的逐元素映射选择生物特征。(3) 服装检测仪的培训过程。采用人体解析模型LIP代替人工标注,获得人体图像的服装边界框。

生物特征(BF)分支。BF模块以子图像IPA作为输入,以ResNet50[15]为主干,得到特征映射SAPisin;RHtimes;Wtimes;D,其中H表示特征映射的大小,D表示特征维数。为了更好地利用与衣服无关的特征,我们进一步设计了ask模块,如图6所示。中的模块倾向于强调生物特征,而不强调衣服和背景的特征。为了得到maskMpisin;RHtimes;Wtimes;1,Apis首先通过三个1times;1的卷积层将其分解为n通道特征映射,然后用softmax函数对每个特征映射进行归一化,该函数以所有htimes;W值作为输入向量。采用沿通道最大池的方法,将n通道特征映射缩减为1通道特征映射,得到掩模。基于masMp,生物特征FBisin;RDI是通过过滤特征的平均池获得的地图:fBk=1Htimes;WHsum;i=1Wsum;j=1[Apk·Mp]i,j,(1)式中,°表示元素乘积,Apk·mpi

剩余内容已隐藏,支付完成后下载完整资料

资料编号:[262621],资料为PDF文档或Word文档,PDF文档可免费转换为Word

以上是毕业论文外文翻译,课题毕业论文、任务书、文献综述、开题报告、程序设计、图纸设计等资料可联系客服协助查找。