英语原文共 9 页,剩余内容已隐藏,支付完成后下载完整资料

基于立体R-CNN的自动驾驶三维目标检测

Peiliang Li1, Xiaozhi Chen2, and Shaojie Shen

The Hong Kong University of Science and Technology, DJI

pliap@connect.ust.hk, cxz.thu@gmail.com, eeshaojie@ust.hk

摘要

提出了一种充分利用立体图像中稀疏密集、语义和几何信息的自主驾驶三维目标检测方法。我们的方法,称为立体声R-CNN,扩展了更快的R-CNN的立体声输入,同时检测和关联对象的左右图像。我们在立体区域建议网络(RPN)之后添加额外的分支来预测稀疏的关键点、视点和对象维数,并将其与二维左右框相结合来计算一个粗略的三维对象边界框。然后,通过使用左右roi的基于区域的光度校准来恢复准确的3D边界框。我们的方法不需要深度输入和三维位置监督,然而,胜过所有现有的完全监督的基于图像的方法。在具有挑战性的KITTI数据集上的实验表明,我们的方法在3D检测和3D定位任务上都比最先进的基于stereo的方法高出约30%的AP。代码将公开提供。

1.介绍

三维目标检测是自主驾驶的视觉感知、运动预测和规划的重要基础。目前,大多数三维目标检测方法[5,23,31,13,18]在自主驾驶场景中严重依赖激光雷达数据提供准确的深度信息。然而,激光雷达的缺点是成本高、感知范围相对较短(sim;100 m)和信息稀疏(与gt;720p图像相比有32、64行)。另一方面,单目相机为3D目标检测提供了替代的低成本解决方案[3,21,27]。深度信息可以通过场景中的语义属性和对象大小等来预测。但是,所推断的深度并不能保证准确性,尤其是对于不可见的场景。为此,我们提出了一种基于立体视觉的三维目标检测方法。与单目摄像机相比,立体摄像机能提供更精确的深度信息

1 我们使用粗糙的3D框来表示一个具有精确2D投影的框

但不一定是精确的3D位置。

通过左右光度校准。与激光雷达相比,立体相机的成本较低,但可以获得与激光雷达相当的深度精度。立体相机的感知范围取决于焦距和基线。因此,立体视觉通过将不同的焦距和基线的立体模块组合在一起,具有提供更大范围感知的潜力。

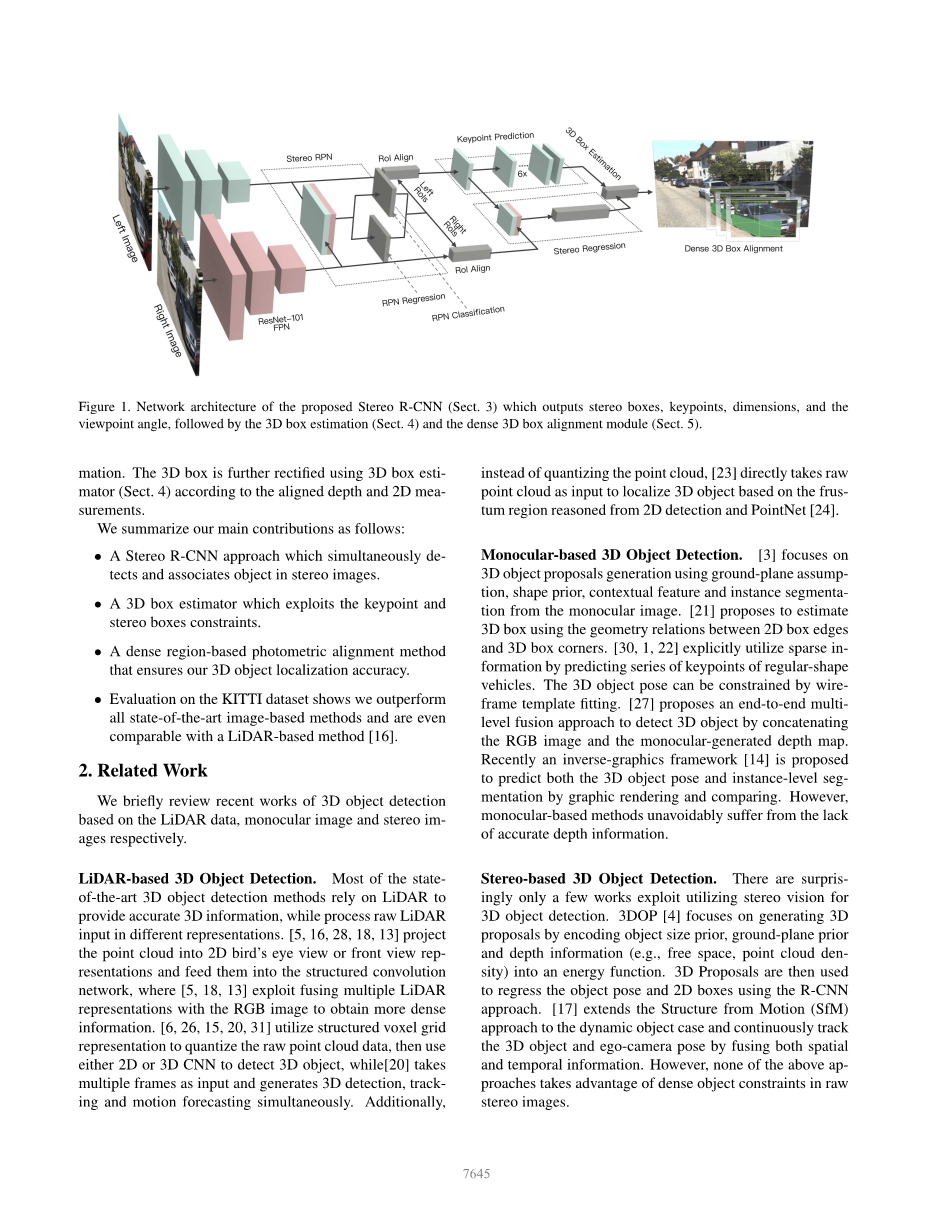

在本工作中,我们充分利用立体图像中的语义和几何信息,研究了三维对象的稀疏和稠密约束,提出了一种基于立体R-CNN的精确立体三维对象检测方法。我们的方法同时检测和关联对象的左右图像使用立体声R-CNN。网络体系结构如图1所示,主要分为三个部分。第一个是立体声RPN模块(3.1节),输出相应的左右RoI方案。在左右特征图上分别应用RoIAlign[8]后,我们将左右RoI特征连接起来,对对象类别进行分类,并在立体回归(3.2节)分支中回归准确的2D立体盒、视点和维度。使用一个关键点(3.2节)分支,仅使用左RoI特征来预测目标关键点。这些输出构成了3D box estimate(第4节)的稀疏约束(2D boxes, keypoints),其中我们用2D left-right boxes和keypoint来表示3D box corner之间的投影关系。

确保我们的3D定位性能的关键组件是密集的3D方框对齐(第5节)。我们认为3D对象定位是一个学习辅助几何问题,而不是端到端的回归问题。我们没有直接使用没有显式利用对象属性的深度输入[4,27],而是将对象RoI视为一个整体,而不是独立的像素。对于规则形状的物体,利用粗糙的三维边界框可以推断出每个像素与三维中心的深度关系。我们根据图像与三维物体中心的深度关系,将左侧感兴趣区域的密集像素弯曲到右侧图像,以找到最大限度减小整个光度误差的最佳中心深度。整个对象的RoI从而形成了三维对象深度esti-的稠密约束

图1所示。提出的体视R-CNN网络结构(第3节),输出体视方框、关键点、尺寸和视点角度,然后是三维方框估计(第4节)和密集三维方框对齐模块(第5节)。

美信。根据对齐深度和2D测量值,使用3D box estimator (section . 4)对3D box进行进一步校正。

我们的主要贡献总结如下:

一种立体声R-CNN方法,可以同时检测和关联立体图像中的物体。

bull;利用关键点和立体声盒约束的3D盒估计器。

bull;一个密集的基于区域的光度校准方法,确保我们的3D对象定位精度。

bull;对KITTI数据集的评估表明,我们的性能优于所有先进的基于图像的方法,甚至可以与基于lidar的[16]方法相媲美。

2.相关工作

简要介绍了近年来基于激光雷达数据、单目图像和立体图像的三维目标检测的研究进展。

基于lidar的三维物体检测。目前最先进的三维目标检测方法大多依赖于激光雷达提供准确的三维信息,而对原始激光雷达的输入进行不同的处理。[5, 16, 28, 18, 13]将点云投影到二维鸟瞰图或前视图表示中,并将其输入到结构化卷积网络中,[5,18,13]利用多个激光雷达表示与RGB图像融合,获得更密集的信息。[6, 26, 15, 20, 31]利用结构化体素网格表示对原始点云数据进行量化,然后使用2D或3D CNN来检测3D对象,而[20]以多帧为输入,同时生成3D检测、跟踪和运动预测。此外,

[23]没有对点云进行量化,而是直接将原始点云作为输入,根据2D检测和PointNet[24]推断出的frustum区域对3D对象进行定位。

基于单目视觉的三维目标检测。[3]侧重于使用地面平面假设、形状先验、上下文特征和单目图像的实例分割来生成三维对象建议。[21]提出利用二维盒边和三维盒角的几何关系来估计三维盒。[30, 1, 22]通过预测规则形状车辆的关键字序列,明确利用稀疏信息。通过线框模板拟合,可以实现对三维物体姿态的约束。[27]提出了一种端到端多层融合的方法,通过将RGB图像与单目生成的深度图连接起来来检测三维目标。最近提出了一种通过图形绘制和比较来预测三维目标位姿和实例级分割的逆图框架[14]。然而,基于单目视觉的方法不可避免地存在深度信息不准确的问题。

基于体视的三维物体检测。令人惊讶的是,利用立体视觉进行三维物体检测的工作很少。3DOP[4]侧重于通过将对象大小先验、地平面先验和深度信息(如自由空间、点云密度)编码成能量函数来生成3D提案。然后,使用R-CNN方法,使用3D提议来还原对象姿态和2D框。[17]将结构从运动(SfM)方法扩展到动态对象的情况,并通过融合空间和时间信息连续跟踪三维对象和自拍照姿态。然而,上述方法都没有利用原始立体图像中的密集对象约束。

amp;ODVVLILFDWLRQ吗?5 hjuhvv 7 dujhw / HIW ? ?7 dujhw 5 ljkw 5 hjuhvv ? 7 dujhw

图2。为RPN分类和回归分配不同的目标。

3.立体R-CNN网络

在本节中,我们将介绍Stereo R-CNN网络结构。与更快的R-CNN[25]等单帧检测器相比,立体声R-CNN可以同时检测和关联二维边界框的左右图像,只需稍加修改。我们使用weight-share ResNet-101[9]和FPN[19]作为骨干网提取左右图像的一致性特征。从我们的训练目标设计中获益图2,数据关联没有额外的计算。

3.1立体的RPN

区域建议网络(RPN)[25]是一种基于滑动窗口的前景检测器。特征提取后,使用一个3times;3的卷积层进行信道约简,然后使用两个同胞全连通层对每个输入位置的对象性进行分类,并对每个输入位置的回归盒偏移量进行锚定。与FPN[19]相似,我们通过在多尺度特征图上评估锚点来修正金字塔特征的原始RPN。不同之处在于,我们在每个尺度上连接左、右特征映射,然后将连接后的特征输入到立体声RPN网络中。

实现同时检测和关联的关键设计是对象分类器和立体盒回归器的不同地面真值(GT)盒分配。如图2所示,我们将左右GT box的并集(简称为并集GT box)作为对象分类的目标。如果锚点与其中一个联合GT盒的交超联合(IoU)比值大于0.7,则赋予其正标签;如果锚点与任何一个联合盒的IoU比值小于0.3,则赋予其负标签。得益于这种设计,正锚往往同时包含左右两个对象区域。我们计算目标联合GT盒中包含的左右GT盒的正锚的偏移量,然后分别将偏移量分配给左右回归。有六个回归条款立体声回归量:[∆u,∆w,∆u′,∆w′,∆v,∆h],我们用u, v来表示2 d的水平和垂直坐标框中心在图像空间中,w h框的宽度和高度,和对应的上标(·)术语正确的图像。′ 注意我们用的是相同的v和h

amp;

!'

%

amp;

#'

!'

%

#'

#$

!'

amp; = 0

!$

%

#'

图3。面向对象关系theta;,方位角theta; beta;beta;和观点。只有相同的观点才能导致相同的预测。

因为我们使用了经过校正的立体图像,所以对于左右的盒子,替换∆v,∆h。因此,我们有6个立体RPN回归器的输出通道,而不是原来的RPN实现中的4个。由于左右建议是由相同的锚点生成的,并且共享对象得分,所以它们可以自然地逐个关联起来。为了减少冗余,我们分别对左右roi使用非最大抑制(Non-Maximum Suppression, NMS),然后从左右NMS中保存的条目中选择前2000名候选人进行培训。考试时,我们只挑选前300名的考生。

3.2立体R-CNN

立体声回归。在立体声RPN之后,我们有相应的左右建议对。在适当的金字塔水平上,我们应用RoI将[8]分别对准左右特征图。将左右感兴趣区域的特征连接到两个连续的全连接层(每个层后面是ReLU层)中,提取语义信息。我们使用四个子分支分别预测对象类、立体边框、维度和视点角度。box回归项与3.1节定义相同。注意,视点角度不等于物体的方向,这是不可观测的裁剪图像感兴趣区域。一个例子是图3所示,我们使用theta;来表示车辆定位尊重摄像机坐标系、和beta;表示对象方位尊重与摄像机之间的中心。三种车辆有不同的方向,但是它们在裁剪RoI图像上的投影是完全相同的。因此我们回归观点角度alpha;定义为:alpha;=theta; beta;。为了避免不连续,培训目标(sinalpha;,cosalpha;)而不是原始的角度值。通过立体盒和物体尺寸,可以直观地恢复深度信息,通过解耦视点角度与三维位置的关系,也可以解决车辆的方位问题。

在对RoI进行抽样时,如果RoI之间的最大IoU在左侧,则我们考虑一个左右RoI对作为前景

]

3 huvshfwlyh . h SRLQWV

% RXQGDU . h SRLQWV

(

* * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * * *

图4。三维语义关键点、二维透视关键点和边界关键点的说明。

左侧GT box的RoI高于0.5,右侧GT box对应的RoI之间的IoU也高于0.5。如果左RoI或右RoI的最大IoU在[0.1,0.5]区间内,则以左右RoI对作为背景。对于前景RoI对,我们通过计算左侧GT盒与左侧RoI之间的偏移量和右侧GT盒与右侧RoI之间的偏移量来分配回归目标。我们仍然使用相同的∆v,∆h作为左右roi。对于维度预测,我们简单地使用预先设置的维度来返回地面真值维度之间的偏移。

关键点的预测。除了立体盒和视点角度外,我们注意到投影在盒中间的3D盒角可以对3D盒估计提供更严格的约束。如图4所示,我们定义了四个三维语义关键点,表示三维边界框底部的四个角。只有一个三维语义关键点可以明显地投射到框的中间(而不是左右边缘)。我们将这个语义关键点的投影定义为透视图关键点。在第4节和表5中,我们展示了透视图关键点是如何影响3D框的估计的。我们还预测了两个边界关键点,它们可以作为规则形状对象实例掩码的简单替代。只有两个边界关键点之间的区域属于当前对象,将用于进一步密集对齐(参见第5节)。

我们预测了掩模R-CNN[8]中提出的关键点。只有左特征图用于关键点预测。如图1所示,我们将14times;14 RoI对齐后的特征映射映射到6个顺序的256-d 3times;3卷积层,每个层后面都有一个ReLU层。使用2times;2反褶积层将输出刻度提升至28times;28。我们注意到除了2D框外,只有u坐标的关键点提供了额外的信息。为了放松任务,我们将6times;28times;28输出的高度通道相加,得到6times;28的预测结果。因此,RoI特性中的每一列都将被聚合并有助于关键点预测。前四个频道重复播放

发送四个语义关键字中的每一个被投影到相应u位置的概率。另外两个通道分别表示每个u位于左右边界的概率。请注意,四个3D关键点中只有一个可以明显地投射到2D框的中间,因此softmax应用于4times;28的输出,以鼓励将

剩余内容已隐藏,支付完成后下载完整资料

资料编号:[235593],资料为PDF文档或Word文档,PDF文档可免费转换为Word

以上是毕业论文外文翻译,课题毕业论文、任务书、文献综述、开题报告、程序设计、图纸设计等资料可联系客服协助查找。