英语原文共 10 页,剩余内容已隐藏,支付完成后下载完整资料

用于神经会话生成的示例编解码器

Gaurav Pandey,丹麦承包商,Vineet Kumar和Sachindra,乔希

IBM研究人工智能

新德里,印度

{gpandey1, dcontrac, vineeku6, jsachind}@in.ibm.com

摘要

在本文中,我们提出了范例编解码器网络(EED),这是一种新的会话模型,它学习利用训练数据中的类似例子来生成响应。使用传统的基于TF-IDF的检索模型从训练数据中检索相似的会话示例(上下文-响应对)。检索到的响应用于创建示例向量,解码器使用这些向量生成响应。每个检索到的响应的贡献由相应上下文与输入上下文的相似性来衡量。我们在两个大数据集上进行了详细的实验,发现我们的方法在最近提出的几个评估指标上都优于现有的序列生成模型。我们还观察到,与现有的最先进的方法相比,所提出的速度模型所产生的响应具有更大的信息量和多样性。

- 介绍

随着大数据集的可用性和神经方法的最新进展,序列到序列学习的变体(seq2seq) (Sutskever et al., 2014)体系结构已成功应用于构建会话系统(Serban et al., 2016, 2017b)。然而,尽管这些方法是最先进的对话生成框架,但它们也存在一些问题,如响应缺乏多样性和生成简短、重复和无趣的响应(Liu et al., 2016;Serban等,2016,2017b)。近年来,大量的文献关注于克服这些挑战(Li et al., 2016a;Lowe等人,2017)。

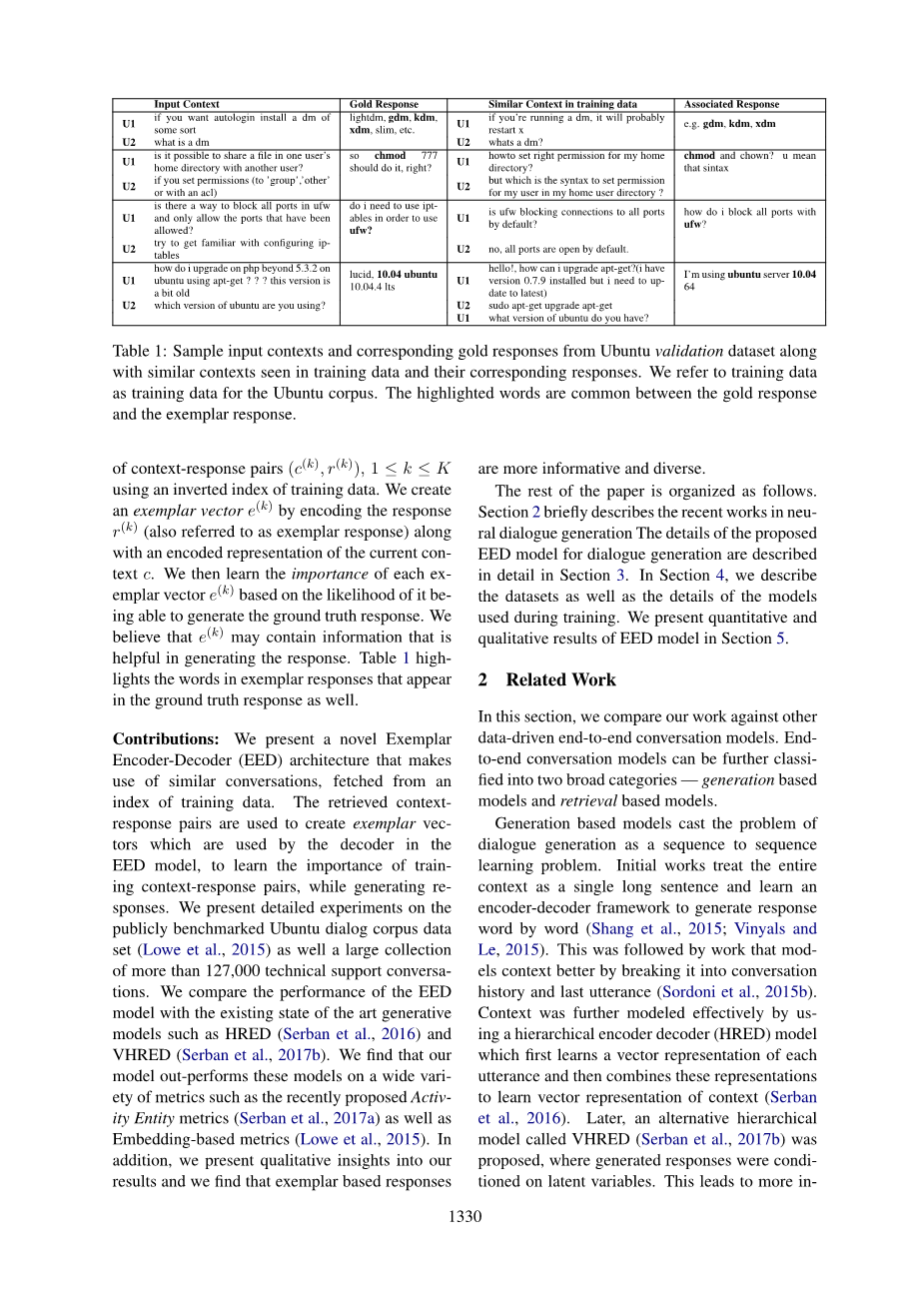

在某种程度上,由于生成响应所需的所有信息都需要作为从培训数据中学习的模型参数的一部分来捕获,因此出现了这样的问题。仅这些模型参数可能不足以生成自然对话。因此,尽管提供了大量的数据,神经生成系统已经被发现在现实世界应用中是无效的(Liu et al., 2016)。在本文中,我们将注意力集中在封闭域会话上。这种对话的一个特征是,在一段时间内,一些对话内容很可能以前就发生过(Lu et al., 2017b) 例如,表1显示了Ubuntu对话库中的一些上下文。每行显示一个输入对话框上下文,其对应的gold响应后面跟着一个类似的上下文和训练数据中的响应—可以看到,“安装dms”、“共享文件”、“阻塞ufw端口”的上下文都出现在训练数据中。我们假设,能够参照之前看到的类似情景的训练反应,可能是一个有用的信号,可以在生成反应时使用。为了利用闭域对话的这一方面,我们构建了我们的神经编码器解码器体系结构,称为示例编码器解码器(EED),它通过利用训练对话中的类似上下文来学习为给定上下文生成响应。因此,我们不让seq2seq模型只从对齐的并行语料库学习语言模式,而是通过从训练数据中提供紧密相关的(类似的)样本来帮助该模型,这些样本可以在生成文本时引用。

|

输入上下文 |

黄金响应 |

培训数据中的类似上下文 |

相关的反应 |

||

|

U1 |

如果你想要自动安装某种dm |

Lightdm,gdm, kdm,xdm,slimhellip; |

U1 |

如果您正在运行一个dm,它可能会重新启动x |

例如gdm, kdm, xdm |

|

U2 |

什么是dm |

U2 |

什么是dm |

||

|

U1 |

是否可以将一个用户主目录中的文件与另一个用户共享? |

所以chmod 777应该这样做,对吗? |

U1 |

怎样为我的home设立正确的权限。 |

|

|

U2 |

如果您设置权限(为“group”、“other”或acl) |

U2 |

在主用户目录中设置用户权限的语法是什么? |

||

|

U1 |

是否有一种方法可以阻止ufv中的所有端口,只允许被允许的端口。 |

我是否需要使用ipt来使用ufw? |

U1 |

Ufw是否在默认情况下阻塞到所有端口的链接? |

不,默认情况下所有的端口都是打开的。 |

|

U2 |

试着熟悉易混淆的IP表 |

U2 |

如何使用ufw阻塞所有端口? |

||

|

U1 |

如何使用apt-get在5.3.20Ubuntu之后升级pha?这个版本有点旧了 |

Ubuntu10.04 |

U1 |

你好!我该如何改进apt-get0.79版本的安装? |

我是Ubuntu server 10.04.64 |

|

U2 |

你用的是哪个版本的Ubuntu? |

U2 |

你有什么版本的Ubuntu |

||

表1:来自Ubuntu验证数据集的示例输入上下文和相应的金色响应,以及在培训数据中看到的类似上下文和相应的响应。我们将训练数据作为Ubuntu语料库的训练数据。突出显示的单词在gold响应和范例响应之间是常见的。

具体来说,给定上下文c,我们使用训练数据的反向索引检索一组上下文响应对(c(k),r(k)), 1le;kle;k。我们创建一个范例矢量e (k)通过编码响应r (k)(也称为范例响应)以及一个当前上下文的编码表示c。然后我们学习的重要性,每一个范例矢量e (k)的可能性的基础上,它能够生成地面真理的回应。我们认为e(k)可能包含有助于生成响应的信息。表1突出显示了出现在基本事实响应中的范例响应中的单词。

贡献:我们提出了一个新的示例编解码器(EED)体系结构,它利用了从训练数据索引中获取的类似对话。检索到的上下文响应对用于创建示例向量,这些向量由EED模型中的解码器使用,以了解在生成响应时训练上下文响应对的重要性。我们对公开基准测试的Ubuntu对话语料库数据集(Lowe et al., 2015)以及127,000多个技术支持对话的大集合进行了详细的实验。我们将EED模型的性能与现有的艺术生成模型如HRED (Serban et al., 2016)和VHRED (Serban et al., 2017b)的性能进行了比较。我们发现,我们的模型在很多度量指标上都优于这些模型,比如最近提出的活动实体度量(Serban et al., 2017a)以及基于嵌入的度量(Lowe et al., 2015)。此外,我们对我们的结果提出定性的见解,并且我们发现基于范例的响应更有信息性和多样性。

本文的其余部分组织如下。第二部分简要介绍了神经对话生成的最新研究成果,第三部分详细介绍了所提出的神经对话生成的速度模型。在第4节中,我们描述了数据集以及培训期间使用的模型的细节。第五部分给出了速度模型的定量和定性结果。

- 相关工作

在本节中,我们将把我们的工作与其他数据驱动的端到端对话模型进行比较。端到端会话模型可以进一步分为两大类:基于生成的模型和基于检索的模型。基于生成的模型将对话生成问题转化为一个序列对序列的学习问题。最初的作品将整个语境作为一个长句,学习一个编解码器框架,逐词生成响应(尚等,2015;Vinyals and Le, 2015)。接下来的工作是将语境分解成会话历史和最后的话语,从而更好地建模语境(Sordoni et al., 2015b)。使用分层编码器解码器(HRED)模型进一步有效地建模上下文,该模型首先学习每个话语的向量表示,然后结合这些表示学习上下文的向量表示(Serban et al., 2016)。随后,提出了一种替代的分层模型VHRED (Serban et al., 2017b),其中生成的响应以潜在变量为条件。这将导致更多的形成性反应,并增加反应生成的多样性。文献中也研究了在响应生成中明确包含多样性的模型(Li et al., 2016b;Vijayakumar等,2016;曹和克拉克,2017;赵等,2017)。

我们的工作不同于上述方法,因为上述方法都没有显式地利用训练数据中观察到的类似对话上下文。

另一方面,基于模型的检索将会话上下文视为查询,并使用信息检索(IR)技术从会话日志中获取一组响应(Ji et al., 2014)。还有进一步的工作,使用基于深度学习的模型对回答进行进一步排序(Yan et al., 2016a,b;邱等,2017)。另一方面,基于端到端深度学习的排序器也被用于生成响应(Wu et al., 2017;Hendersonetal。, 2017)。最近还提出了一个框架,该框架使用一个有区别的对话网络,对从响应生成器网络接收到的候选响应进行排序,并以端到端方式对两个网络进行培训(Lu等,2017a)。

与上述模型相反,我们使用输入上下文和检索到的响应来生成最终响应。与我们的工作同时,还提出了一个使用检索翻译对的机器翻译生成模型(Guetal.,2017)。我们注意到,虽然这两篇文章的基本前提是相同的,但不同之处在于合并检索到的数据的机制。

-

范例编码器译码器

- 概述

会话由一系列的话语组成。在对话的某一特定时刻,在此之前所表达的话语被统称为上下文。紧跟着上下文的话语被称为回应。正如第一节所讨论的,给定一个会话上下文,我们希望通过使用来自训练数据的类似上下文-响应对来生成响应。我们从使用离线方式的培训数据创建的反向索引中检索一组K个范例上下文响应对。然后将输入和检索到的上下文响应对提供给示例编码器解码器(EED)网络。图1给出了EED网络的示意图。EED编码器结合输入上下文和检索到的响应来创建一组范例向量。然后,EED解码器根据输入上下文和检索上下文之间的相似性使用范例向量来生成响应。现在,我们提供每个模块的详细信息。

-

- 检索相似的上下文-响应对

给定大量的对话作为(上下文、响应)对,我们在tf - idf向量空间中索引每个响应及其对应的上下文。我们进一步提取会话的最后一轮,并将其作为上下文-响应文档对的附加属性索引,以便允许基于它的定向查询。

给定一个输入上下文c,我们构造一个查询重最后话语中剩下的两倍上下文和用它来检索top-k类似上下文响应对该指数基于BM25(罗伯逊et al ., 2009)检索模型。这些检索到的对形成了我们的范例上下文-响应对(c(k),r(k)), 1le;kle;k。

-

- 范例编码器网络

给定范例对(c(k),r(k)), 1le;kle;k,输入上下文响应对(c,r),输入上下文c和示例上下文c(1),hellip;hellip;,c(K) 通过编码器生成的嵌入式如下图所示:

图1:EED网络示意图。输入上下文响应对为(c,r),而范例上下文响应对为(c(k),r(k)), 1le;kle;k。

C e=Encode c(c)

C (k)e=Encode c(c(k)), 1le;kle;k

注意,我们不限制编码器的选择,任何参数化可微体系结构都可以用作编码器来生成上述嵌入。类似地,我们提供范例响应r(1)r、hellip;(K)

剩余内容已隐藏,支付完成后下载完整资料

资料编号:[441791],资料为PDF文档或Word文档,PDF文档可免费转换为Word

以上是毕业论文外文翻译,课题毕业论文、任务书、文献综述、开题报告、程序设计、图纸设计等资料可联系客服协助查找。