英语原文共 13 页,剩余内容已隐藏,支付完成后下载完整资料

用于中文命名实体识别的字-字符图卷积网络

唐卓/万博/彦李扬

摘要—最近的研究试图通过修改标准BiLSTM-CRF模型的结构,将单词信息集成到基于字符的中文NER中。他们遵循显式建模正向和反向序列的范例,采用了LSTM变体,该变体将字符和单词都作为每个方向的输入。尽管丰富了表示形式,但是这些模型无法充分利用未来和过去环境之间的交互作用。在本文中,我们提出了一种新颖的字-字符图卷积网络(WC-GCN),该网络使用交叉GCN块同时处理两个方向的字-字符有向无环图(DAG)。为了改善对长距离依赖性的捕获,引入了全局注意GCN块以学习以全局上下文为条件的节点表示。在这两个模块中,与以前的作品不同,在每个作品中,每个单词都附加到其关联字符或被视为LSTM单元之间的快捷方式,单词和字符被等同地视为图中的节点,并具有其实例特定的表示形式。在四个广泛使用的数据集上进行的实验表明,我们提出的模型可以单独使用,也可以与标准BiLSTM一起使用。两种形式都可以胜过以前的基于LSTM的模型,而无需进行额外的语料库训练,而仅需要外部词典及其相应的预训练字符和单词嵌入。

索引词-命名实体识别,图卷积网络,注意力机制,单词字符DAG。

- 引言

命名实体识别(NER)是自然语言处理的基本问题,因为它始终被视为一系列下游任务的第一步,例如关系提取[1],知识库构建[2]和意图检测[3] ]等。NER的主要目标是查明可以指定特定标签(例如人员,组织和位置)的文本范围。在过去的几年中,基于深度手稿的NER模型于2019年10月21日收到;于2020年2月5日和2020年4月11日修订;接受日期:2020年5月9日。发布日期:2020年5月14日;当前日期为2020年6月1日。这项工作部分得到了中国国家重点研究发展计划的资助,资助项目为2018YFB0203804、2017YFB0202201、2018YFB1701401,部分得到了中国国家自然科学基金会的资助,资助金额为61873090,L1824034和L1924056,部分由教育部-中国移动研究基金项目MCM20170506,部分由中国工程技术知识中心项目CKCEST-2018-1-13,CKCEST-2019-2-13。 Imed Zitouni博士是负责协调本文评论并批准发表的副主编。(通讯作者:卓棠。)

卓棠和万博彦分别在湖南大学计算机科学与电子工程学院,长沙410082,以及在长沙的国家超级计算中心,长沙410082(电子邮件:ztang@hnu.edu.cn; wanboyan@hnu.edu.cn)。

李扬就读于长沙科技大学计算机与通信工程学院,长沙410076(电子邮件:yanglixt@126.com)

数字对象标识符10.1109 / TASLP.2020.2994436的学习一直处于领先地位,并取得了显著成果。 BiLSTM-CRF [4] – [6]是英语NER广泛使用的体系结构,它采用词级表示并将词作为预测标签的基本单位。与英语不同,中文句子中没有清晰的定界符(例如空格),因此自然而然地首先使用分词工具,然后像英语一样实现基于单词的序列标记模型。尽管如此,由于存在以下潜在问题,以这种流水线方式执行中文NER可能会导致性能不佳:(1)单词边界不一定命名为实体边界。以“北京故宫博物院(The Beijing Palace Museum)”为例,它整体上是一个名为实体的位置类型,但可以通过以下方式将其分为“北京(Beijing)”,“故宫(Imperial Palace)”和“博物馆(Museum)”三个词。现有的细分工具。 (2)尽管由于引入了神经网络[7] – [9]在中文分词(CWS)方面取得了长足的进步,但现有的模型还远远不够完善。作为替代,基于字符的模型被中国NER [10],[11]广泛采用。

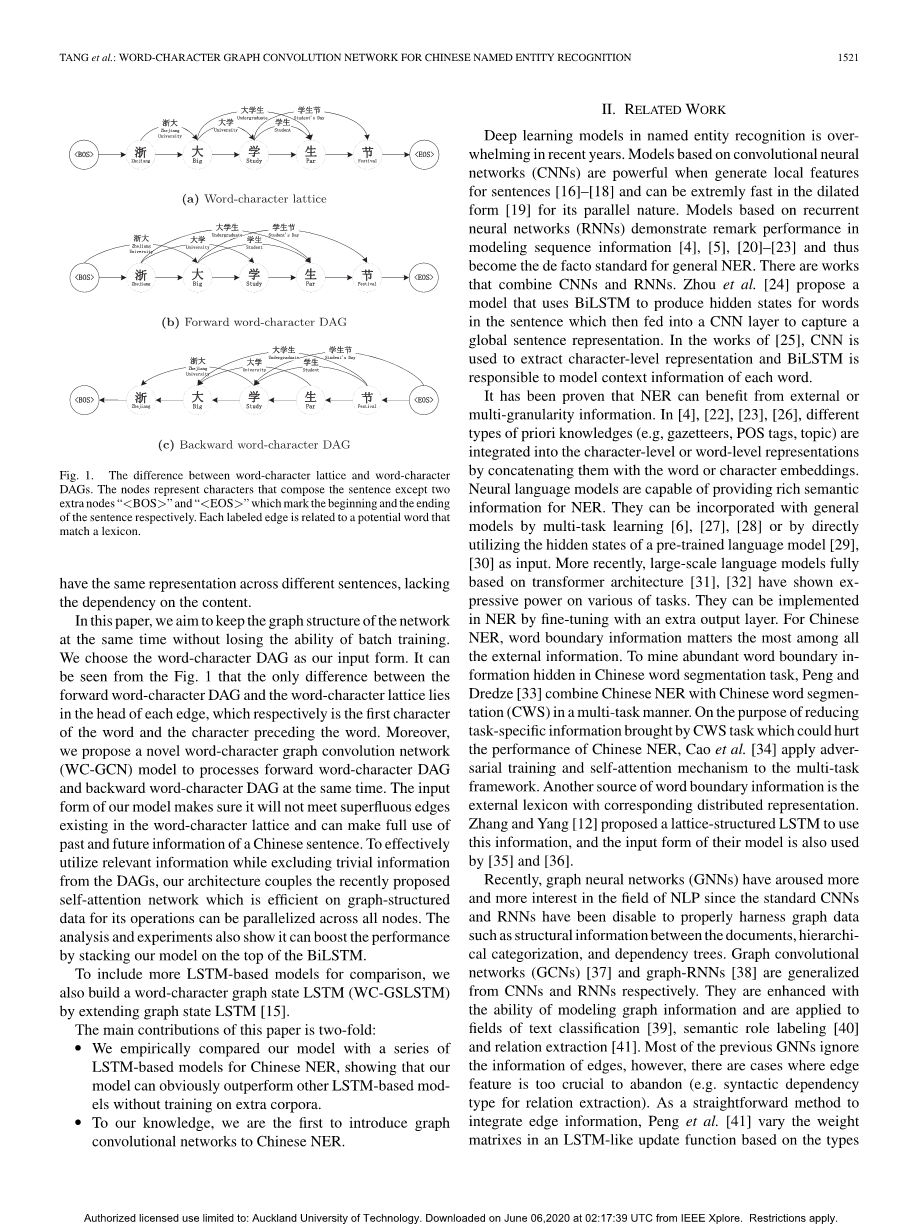

但是,基于字符的模型也有一些缺点。 首先,单词中的字符不一定包含单词的含义。 例如,字符“吉(Lucky)”与单词“吉他(Guitar)”无关。 其次,这些模型没有利用单词绑定的优势,后者在确定实体边界时很有用。 要从单词中添加信息,Zhang等人 [12]提出了一种LSTM的变体,它采用了图1a所示的字-字符格作为输入。 LSTM模型的晶格边缘就像快捷键一样,可以帮助信息流到每个存储单元。

尽管如此,它们的晶格结构还是产生了许多冗余链接。 在图1a中的句子的情况下,除由“大学生(Undergraduate)”和“学生节(Studentrsquo;s Day)”索引的单词边缘以外,所有单词边缘均与原始LSTM中存在的边缘重叠。 而且,由于馈入单元的路径数量是任意的,因此很难在小批量上训练晶格LSTM,因此无法利用GPU的并行功能[13]。

Liu等人提出的WC-LSTM并没有改变网络结构。 [14]将单词信息直接附加到其关联字符上。 由于一个字符可能对应于多个单词,因此使用四种方法将不同的单词嵌入映射到固定长度的向量中,然后将其与字符嵌入连接起来以在每个时间步形成输入。 尽管启用了批量训练,但是导入信息可能会在映射过程中丢失。 而且,每个单词在不同的句子中将具有相同的表示形式,而不必依赖于内容。

图1.字字符格和字字符DAG之间的差异。 这些节点代表组成句子的字符,除了两个额外的节点“ lt;BOSgt;”和“ lt;EOSgt;”分别标记句子的开始和结尾。 每个标记的边都与匹配词典的潜在单词相关。

在本文中,我们的目标是在不丢失批训练能力的情况下,同时保持网络的图结构。我们选择单词DAG作为输入形式。从图1可以看出,前向字字符DAG与字字符点阵之间的唯一区别在于每个边的头部,分别是该单词的第一个字符和该单词之前的字符。此外,我们提出了一种新颖的字-字符图卷积网络(WC-GCN)模型,以同时处理前向字-字符DAG和后向字-字符DAG。我们模型的输入形式确保它不会遇到单词字符格中存在的多余边缘,并且可以充分利用中文句子的过去和将来信息。为了有效利用相关信息,同时又从DAG中排除琐碎的信息,我们的体系结构结合了最近提出的自注意网络,该网络对图结构化数据有效,其操作可以在所有节点上并行进行。分析和实验还表明,通过将我们的模型堆叠在BiLSTM的顶部,可以提高性能。

为了包括更多基于LSTM的模型进行比较,我们还通过扩展图状态LSTM [15]建立了字-字符图状态LSTM(WC-GSLSTM)。

本文的主要贡献有两个方面:

。我们通过经验将我们的模型与一系列基于LSTM的中文NER模型进行了比较,表明我们的模型可以明显胜过其他基于LSTM的模型,而无需经过额外的语料库训练

。据我们所知,我们是第一个将图卷积网络引入中文NER的公司。

二. 相关工作

近年来,命名实体识别中的深度学习模型不胜枚举。 当为句子[16]-[18]生成局部特征时,基于卷积神经网络(CNN)的模型功能强大,并且由于其并行性质,可以以膨胀形式[19]极快地运行。 基于递归神经网络(RNN)的模型在对序列信息进行建模时展示了注释性能[4],[5],[20]-[23],因此成为通用NER的事实上的标准。 有些作品结合了CNN和RNN。 周等。 [24]提出了一个模型,该模型使用BiLSTM为句子中的单词生成隐藏状态,然后将其隐藏到CNN层中以捕获全局句子表示形式。 在[25]的工作中,CNN用于提取字符级表示,而BiLSTM负责对每个单词的上下文信息进行建模。

已证明,NER可以从外部或多粒度信息中受益。在[4],[22],[23],[26]中,通过将不同类型的先验知识(例如,地名词典,POS标签,主题)与单词连接起来,将它们集成到字符级或单词级表示中或字符嵌入。神经语言模型能够为NER提供丰富的语义信息。它们可以通过多任务学习[6],[27],[28]或通过直接利用预训练语言模型[29],[30]的隐藏状态作为通用模型与通用模型合并。最近,完全基于转换器架构的大规模语言模型[31],[32]在各种任务上都表现出了表达力。可以通过对额外的输出层进行微调来在NER中实现它们。对于中文NER,单词边界信息是所有外部信息中最重要的。为了挖掘隐藏在中文分词任务中的大量单词边界信息,Peng和Dredze [33]以多任务方式将中文NER与中文分词(CWS)结合起来。为了减少CWS任务带来的可能会损害中文NER性能的特定任务信息,曹等人。 [34]将对抗训练和自我注意机制应用于多任务框架。单词边界信息的另一个来源是具有相应分布式表示形式的外部词典。 Zhang和Yang [12]提出了一种使用晶格结构的LSTM来使用此信息,[35]和[36]也使用了其模型的输入形式。

最近,图神经网络(GNN)在NLP领域引起了越来越多的兴趣,因为标准的CNN和RNN已被禁用以正确利用图数据,例如文档之间的结构信息,层次分类和依赖树。图卷积网络(GCN)[37]和图RNN [38]分别从CNN和RNN进行了概括。它们增强了具有图形信息建模的能力,并被应用于文本分类[39],语义角色标签[40]和关系提取[41]领域。先前的大多数GNN都忽略了边的信息,但是在某些情况下,边特征太重要而无法放弃(例如用于关系提取的句法依赖类型)。作为一种整合边缘信息的简单方法,Peng等人。 [41]根据当前单元与其前身之间的连接类型,在类似LSTM的更新函数中改变权重矩阵。为了解决在存在大量边缘类型时参数爆炸的问题,Song等人。 [15]通过将边缘类型嵌入与节点表示连接起来,直接将边缘类型嵌入作为输入的一部分。我们的模型采用与Beck等类似的方法 。[42]其中边缘和节点被同等对待,以使图中的所有边缘具有其自己的实例特定表示。

三, 任务定义和基准

A.配方

在中文NER任务中,句子表示为字符序列:c = {c1,c2,...,cn},其中n是句子长度。 为了方便构建单词字符DAG,我们分别使用c0和cn 1指示句子的开头和结尾。 此外,ci:j用于表示c的子序列,该子序列以ci开头,以cj结束。 中文NER的目标是为c1:n分配相应的标签序列:y = {y1,y2,...,yn}。 我们使用BIOES标记方案来定义标记集。 具体来说,实体中的第一个字符标记为B-X,其中X是实体类型。 类似地,实体中的最后一个字符和每个字符分别标记为E-X和I-X。 其余字符标记为O

B.基准:字字符图状态LSTM

我们采用图状态LSTM [15]的一种变体,最初提出是利用句法树和话语树的图特征作为我们的基线模型之一。 字字符图形状态LSTM(WC-GSLSTM)将向前和向后的字字符DAG作为输入。 这两种DAG由句子组成,其节点代表字符,边缘代表单词或相邻字符之间的默认连接。 继宋等。 [15]我们将每个句子的两个DAG集成到一个输入图G中。特别是,前向字字符DAG中连接ci和cj的边表示为三元组(i,j,ci 1:j), 其中0le;i lt;jle;n 1。类似地,将(i,j,cj:i-1)分配给来自后向字字符DAG的边,其中0le;j lt;ile;n 1。Ef(j)和Eb(j)是集合字符j的前进和后退传入边的数量。

输入表示:我们使用以下命令将每个字符ci映射到向量空间:

其中Ec是字符嵌入查找表。 以相同的方式,使用以下命令表示ci:j覆盖的单词:

其中Ew是词嵌入查找表,其中还包括相邻符号cii的嵌入。

通过以下公式计算前缘(i,j,ci 1:j)和后缘(i,j,cj:i-1)的xf i,j和xb i,j表示:

其中W1和b1是可学习的参数。

过渡函数:在每个时间步长t处,输入图的状态表示为:

其中hti是字符ci的隐藏状态。 从ht-1i到hti的所有隐藏状态更新一起构成了从Ht-1到Ht的更新。 与标准LSTM(节点仅与节点的前任或后继节点交换信息)不同,图形状态LSTM通过合并来自直接与其链接的所有字符的信息来更新字符的隐藏状态。

图形状态LSTM使用边缘的表示对单词信息进行编码。 对于字符cj,根据Ef(j)和Eb(j)将输入边缘的输入表示分为两部分,其中:

为了控制字符之间的信息流,我们使用类似于LSTM的单元,其中包含输出门Otj,输入门otj和存储单元ctj。 过渡函数如下:

<p

剩余内容已隐藏,支付完成后下载完整资料</p

资料编号:[405866],资料为PDF文档或Word文档,PDF文档可免费转换为Word

以上是毕业论文外文翻译,课题毕业论文、任务书、文献综述、开题报告、程序设计、图纸设计等资料可联系客服协助查找。