英语原文共 9 页,剩余内容已隐藏,支付完成后下载完整资料

Mask R-CNN

摘要

我们提出了一个概念简单、灵活且通用的对象实例分割框架,它能够有效地检测图像中的对象,同时为每个实例生成高质量的分割掩码,这种方法称为掩码区域卷积神经网络(Mask R-CNN)。通过增加一个用于预测目标掩码的分支并使之与现有边界框识别分支并行,Mask R-CNN扩展了快速区域卷积神经网络(Fast R-CNN)。它以每秒5帧的速度运行,易于训练,仅在Fast R-CNN中增加少量的开销。此外,Mask R-CNN易于推广到其他任务,比如允许我们在同一框架中估计人体姿态。该方法在COCO系列挑战赛的三个项目中表现最佳,包括实例分割、边界框物体检测和人员关键点检测。Mask R-CNN在每个任务上都胜过目前所有的单一模式,包括COCO 2016挑战冠军。我们希望这种简单有效的方法能够作为坚实的基线,帮助简化未来的实例识别研究。它的代码在将来仍然可用。

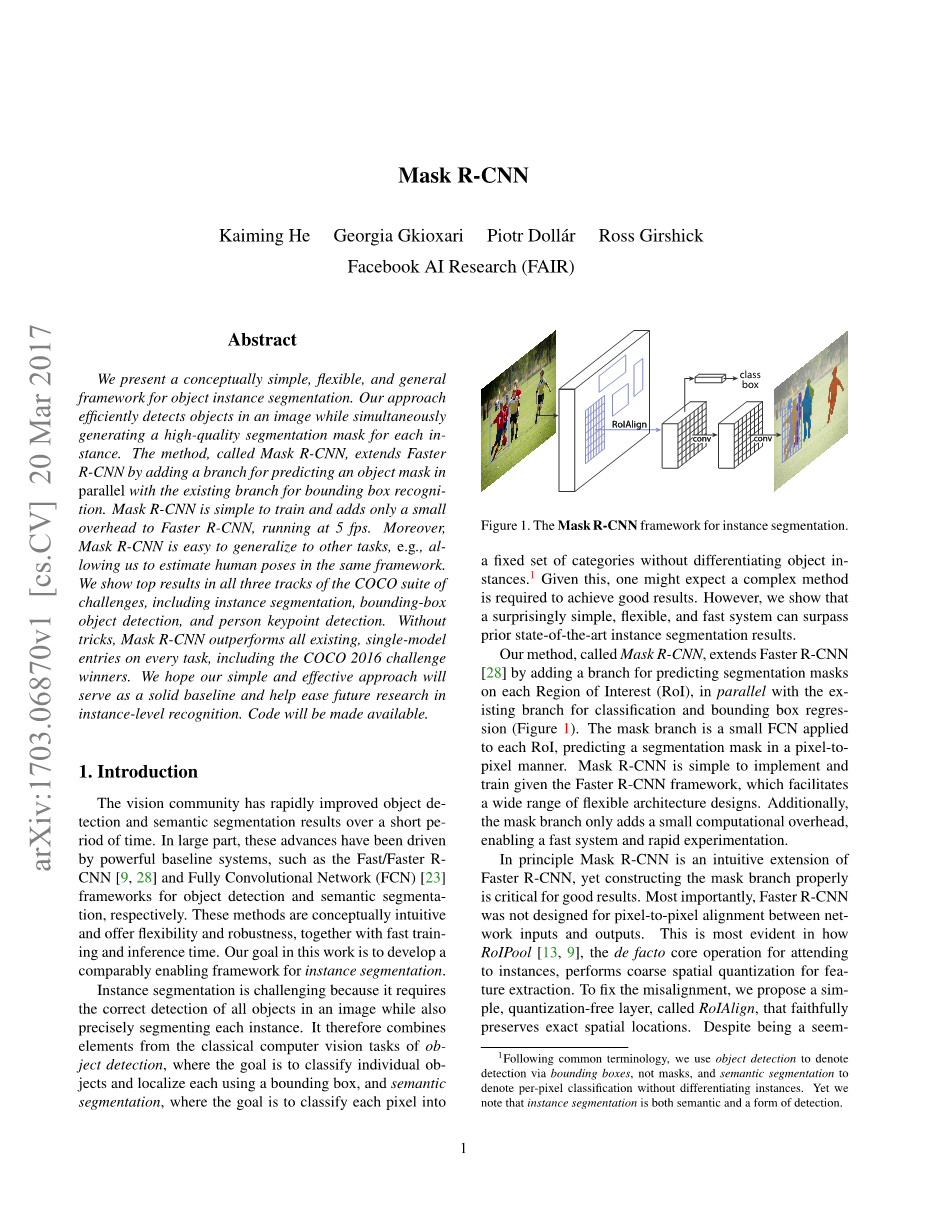

图1.用于实例分割的Mask R-CNN框架

1.引言

视觉领域在短时间内迅速改进了目标检测和语义分割结果。在很大程度上,这些进展是由强大的基线系统驱动的,例如分别用于对象检测和语义分割的Fast/Faster RCNN和全卷积网络(FCN)框架。这些方法的概念很直观,具有灵活性和鲁棒性,同时具有快速训练和推理能力。而本次工作中我们的目标是开发一个可用于实例分割的框架。

实例分割具有挑战性,因为它要求正确检测图像中的所有对象,同时精确分割每个实例。因此,它结合了来自计算机经典视觉任务的元素。对象检测:目标是分类单个对象,并使用边界框对每个对象进行定位。语义分割:目标是将每个像素划分为无差别对象实例的固定类别。鉴于此目的,人们普遍认为可能需要复杂的方法才能获得良好的结果。然而,我们证明了一个极其简单、灵活和快速的系统可以得到超过现有实例分割技术的结果。

我们的方法为Mask R-CNN,通过添加一个与现有分支平行的用于预测每个感兴趣区域(RoI)上分割掩码的分支(如图1所示,现有分支用于分类和边界框回归),Mask R-CNN扩展了Faster R-CNN。掩码分支是应用于每个RoI的小FCN,它以像素拓扑方式预测分割掩码。由于采用了Faster R-CNN框架,Mask R-CNN易于实现和训练,这便于进行广泛的灵活体系结构设计。此外,它使计算更加简单,有利于实现快速系统,进行快速实验。

原则上,Mask R-CNN是Faster R-CNN的直观扩展,但正确构造掩码分支是得到良好结果的关键步骤。最重要的是,Faster R-CNN不是为网络输入和输出之间的像素对齐而设计的。这在感兴趣区域池化(RoIPool,用于处理实例的事实核心操作)所执行的用于特征提取的粗空间量化处理中表现得最为明显。为了进行像素对齐,我们提出了一个简单无量化的层,称为RoIAlign层。它保留了精确的空间位置。尽管看起来只是一个小改变,RoIAlign还是有很大的影响:它使掩码精度提高了10%到50%,在更严格的本地化度量下显示出更大的增益。其次,我们建立了一个二元掩码模型:我们独立预测每个类的二元掩码,没有类之间的竞争,并且依靠网络的RoI分类支路来预测类别。相比之下,FCN通常执行每个像素的多类分类(耦合分割和分类),根据我们的实验结果,它在实例分割项目中的表现很差。

在COCO实例分割任务中,Mask R-CNN超越了目前所有最先进的单模型结果,包括来自2016年竞赛获胜者的精心设计的条目。我们的方法在COCO对象检测任务中同样表现优异。在消融实验中,我们评估了多个基本实例,这允许我们展示该模式的稳健性并分析核心因素的影响。

在单个GPU上,我们的模式以每个框架200毫秒的速度运行,在单个8GPU机器上进行COCO培训则需要1到2天。我们相信,快速训练和测试速度,以及框架的灵活性和准确性,将有利于并简化未来实例分割的研究。

最后,通过在COCO关键点数据集上的人体姿态估计任务,我们展示了该框架的一般性。通过将每个关键点看作一个热二进制掩码,加上一点修改,Mask R-CNN可用于检测实例特定姿态。在同时以每秒5帧的速度运行下,Mask R-CNN超过了2016年COCO关键点比赛的冠军。因此,Mask R-CNN可被看作是一个可改进的框架,用于实例识别和更复杂的任务。

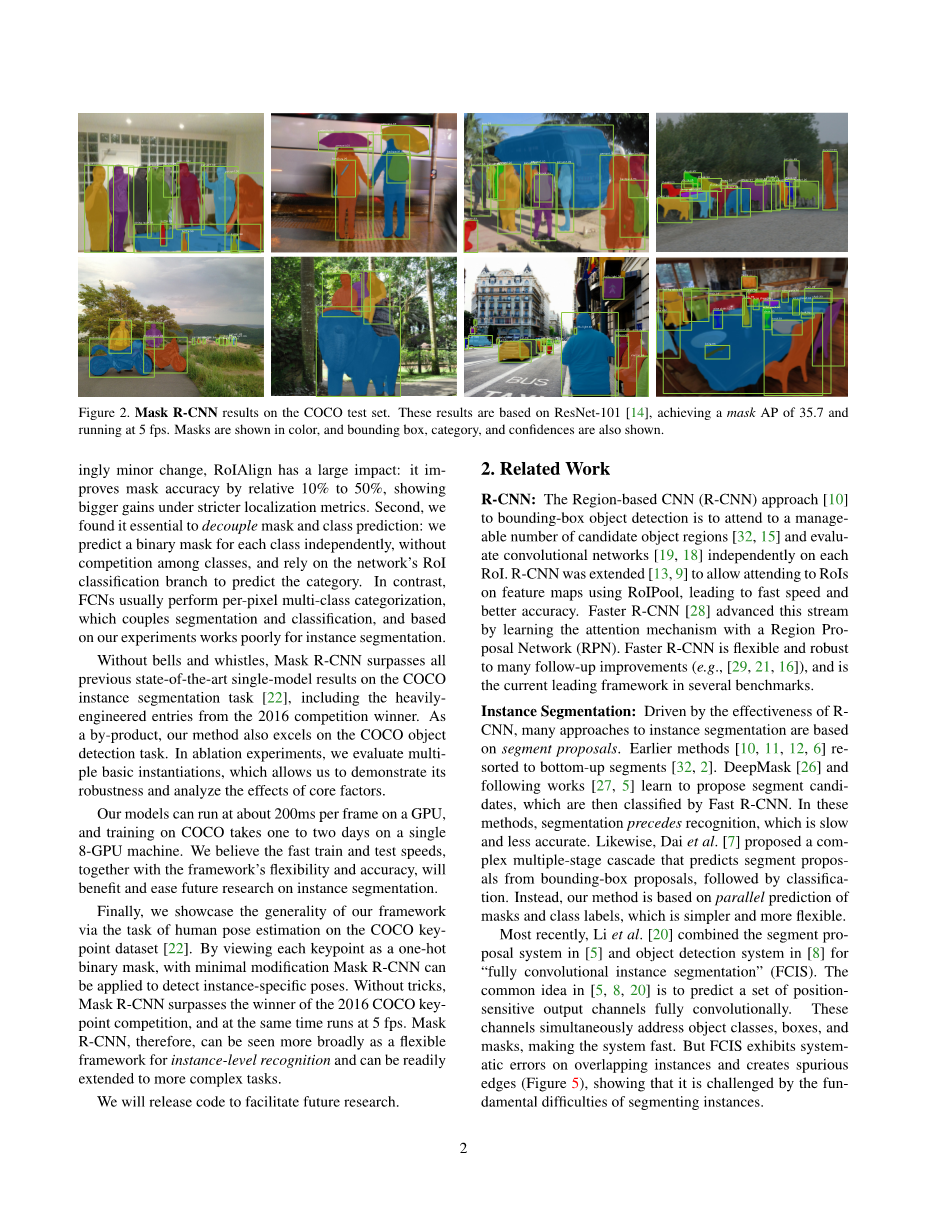

图2.COCO测试集上的Mask R-CNN结果。这些结果基于RESNET-101骨干[14],实现了35.7的Mask AP,并在每秒5帧下运行。掩码通过颜色显示,图像也显示了边界框、类别和可信度。

2.相关工作

R-CNN:用于边界框对象检测的区域卷积神经网络方法(R-CNN)是连接可管理的候选对象区域,并在每个RoI上独立运用卷积网络。R-CNN被改进为允许在特征地图上使用RoIPool处理RoI,从而实现更快的速度和更好的精度。Faster R-CNN[28]通过使用区域建议网络学习注意机制(RPN)来推进这个方法。Faster R-CNN中的许多改进是灵活而健壮的,它是当前几个基准中的领先框架。

实例分割:受R-CNN有效性的驱动,许多实例分割方法都是基于分割建议的。早期的方法采用自下而上的分割,深度掩码(DeepMask)和之后的工作提出分割候选,然后由Fast R-CNN进行分类。在这些方法中,分割先于识别,其速度较慢,精度较低。同样,戴等人提出了一个复杂的多阶段级联,从边界框提议中预测分割提议,然后进行分类。相反,我们的方法是基于掩码和类标签的并行预测,这更简单灵活。最近,李等人结合[5]中的分割建议系统和[8]中的对象检测系统提出了“完全卷积实例分割”(FCIS)。[5,8,20]中的共同思想是完全用卷积的方法预测一组位置敏感输出通道。这些通道同时处理对象的类、框和掩码,使系统运行更快。但是,FCIS在重叠实例上表现出系统性错误,并创建了伪边(图5),表明它受到分割实例的基础差异挑战。

3.Mask R-CNN

Mask R-CNN在概念上是简单的:Faster R-CNN对于每个候选对象有两个输出,一个类标签和一个边界框偏移量。对此,我们添加第三个分支,该分支输出物体掩码。因此,Mask R-CNN是一个自然和直观的想法。但是附加的掩码输出与类别和边框输出不同,需要更多提取对象的空间布局。接下来,我们介绍了Mask R-CNN的关键元素,包括Fast/Faster R-CNN中主要的缺失部分——像素对齐。

Faster R-CNN:我们从R-CNN检测框架的简短回顾开始。Faster R-CNN有两个阶段。第一个阶段,称为区域建议网络(RPN),用于提出候选对象边界框。第二阶段,可以说是Fast R-CNN的本质,使用RoIPool从每个候选框中提取结果,并进行分类和边界框回归。两个阶段可以共享提取特征以便更快运行得出结果。我们向读者推荐查阅[16]以了解Faster R-CNN和其他框架之间的最新最全面的比较。

Mask R-CNN:Mask R-CNN采用相同的两阶段过程,第一阶段完全相同(即RPN)。在第二阶段,除了预测类和边界框偏移,掩码R-CNN同时还为每个RoI输出二进制掩码。这与最近那些分类依赖于掩码预测的系统相反。我们的方法遵循Fast R-CNN的理念,并行应用边界框分类和回归(这大大简化了原始R-CNN的多级流水线)。形式上,在训练期间,我们对每个采样的ROI进行定义L=Lcls Lbox Lmask的多任务损失。分类损失Lcls和边界框损失Lbox与Fast R-CNN中一样。掩码分支具有针对每个RoI的Km2维输出,它编码分辨率为mtimes;m的K个二进制掩码,每个有K类。为此,我们对每个像素采用sigmoid函数并定义Lmask为平均二进制交叉熵损失。对于与基本真值k类相关联的RoI,Lmask仅在第k个掩码上去噪(其他掩码输出不会造成损失)。我们对Lmask的定义允许网络为每个类生成掩码,而不需要类之间的竞争。我们依赖分类分支对用于选择输出掩码的类标签进行预测,这就将掩码和类预测任务解耦。与通常应用FCN进行语义切分不同,FCN通常对每个像素采用softmax函数和多项式交叉熵损失。在这种情况下,跨类的掩码会相互竞争;在我们的例子中,对每个像素用sigmoid函数和二进制损失则不会产生竞争。实验证明,该公式是获得良好实例分割结果的关键。

掩码表示:掩码对输入对象的空间布局进行编码。因此,与通过完全连接(fc)层不可避免地折叠成短输出向量的类标签或框偏移不同,提取掩码的空间结构可以通过卷积层提供的像素对应进行自然编址。特别地,我们使用FCN预测来自每个ROI的Mtimes;M掩码。这允许掩码分支中的每一层保持显式的mtimes;m对象空间布局,而不将其折叠为缺乏空间维度的向量表示。与以往采用fc层进行掩码预测不同,我们的完全卷积层表示只需要较少的参数,并且如实验所证明的那样,能够得到更精确的结果。这种像素对齐的结果需要将RoI特征(它们本身是小特征图)进行重新排列,以忠实地保持每个像素的显式空间对应。这促使我们之后开发了在掩码预测中起关键作用的RoIAlign层。

RoIAlign:RoIPool是从每个RoI中提取一个小特征地图(例如,7times;7)的标准操作。RoIPool首先将一个浮点数RoI量化为特征图的离散粒度,然后将量化的ROI细分为空间箱,这些空间箱本身已被量化,最终将每个箱覆盖的特征值汇总(通常由最大池操作合并)。例如,在连续坐标x上通过计算[x/16]执行量化,其中16是一个特征图步幅,[·]是舍入;同样,当量化数据划分成空间箱(例如,7times;7)时也执行量化。这些量化引入了ROI和提取特征之间的不对准。虽然这可能不会影响分类器(它对于小的转化操作是鲁棒的),但是对于预测像素精确掩码有很大的负面影响。为了解决这个问题,我们提出了一个RoIAlign层,它去除了RoIPool的粗糙量化,利用输入将提取特征对齐。我们提出的改变很简单:我们避免对RoI边界或空间箱进行任何量化(即我们用x/16代替[x/16])。我们用双线性插值来计算每个RoI空间箱中四个正则放大器位置的输入特征精确值并聚合结果(使用最大值或平均值)。正如我们在4.2章节所展示的,RoIAlign是一个巨大的进步。我们还比较了在文献[7]中提出的ROIWARP操作。与RoIAlign不同,RoIWarp忽略了对齐问题,并在[7]中像RoIPool一样对RoI进行量化。因此,即使RoIWarp也采用了由[17]激发的双线性重采样,它的性能与RoIPool相当,实验(表2c)表明了对齐的关键作用。

网络体系结构:为了演示我们方法的通用性,我们用多个体系结构实例化了Mask R-CNN。为了清楚起见,我们在以下两点进行区分:(1) 卷积骨干结构,用于在整个图像上提取特征。(2)分别应用于每个RoI的网络头部的边界框识别(分类与回归)和掩码预测。我们使用网络深度特征来表示骨干架构。我们评估深度50或101层的ResNet[14]和ResNeXt[34]网络。用ResNets实现的Faster R-CNN从第四阶段的卷积层中提取特征,我们称之为C4。例如,RESNET-50的主干由RESNET-50-C4表示,这是在文献[14, 7, 16,30]中常用的选择。我们还探索了最近由林等人提出的另一个称为特征金字塔网络(FPN)的骨干。 FPN使用具有横向连接的自顶向下体系结构来构建网络内特征金字塔。使用了FPN骨干的Faster R-CNN根据不同级别的特征金字塔的规模提取RoI特征,其他部分与vanilla ResNet类似。使用ResNet-FPN骨干的Mask R-CNN进行特征提取时在精度和速度上都获得了极好的增益。关于FPN的进一步细节,我们请读者参考文献[21]。对于网络的头部,我们在以前工作中所提出架构的基础上,添加了一个完全卷积掩码预测分支。特别地,我们扩展了使用ResNet[14]和FPN[21]骨干的Faster R-CNN框架,细节如图3所示。ResNet-C4骨干上的头部包括ResNet的第5阶段(即,9层“res5”[14]),这样的计算是十分密集的。对于FPN,主干包括res5,因此允许使用更少的滤波器和更加可靠的头部结构。我们的掩码分支有一个直接简单的结构。更复杂的设计具有提高性能的潜力,但不是这项工作的重点。

图3.网络头部结构:我们扩展了两个现有的更快的R-CNN头部[14, 21]。左/右面板分别显示[14]和[21]中ResNet C4和FPN骨干的头部,其中添加了掩码分支。数字表示空间分辨率和通道。箭头表示可从上下文推断的卷积、反卷积或全连接层(卷积保留空间维度,反卷积增加空间维度)。所有的卷积核都是3times;3,除了输出卷积核是1times;1,反卷积核是2times;2,步长为2,我们在隐藏层中使用ReLU[24]。左边:res5表示ResNet的第五阶段,为了简单起见,我们对其进行了更改,使得rst卷积在7times;7RoI上以步长1运行(而不是[14]中的14times;14/步长2)。右:“times;4”表示四个连续的一组。

3.1.实现细节

我们在现有的Fast/Faster R-CNN工作上设置超参数。尽管这些决策是在原文[9,28,21]中对目标检测做出的,但我们发现我们的实例分割框架对这些决策是鲁棒的。

训练过程:在Fast R-CNN中,如果RoI具有0.5以上基本真值框的IoU,则认为RoI是积极的,否则是消极的。掩码损失Lmask只有在RoIs积极时被定义。掩码的目标是RoI与其关联的基本真值掩码之间的交集。我们采用了文献[9]中的图像中心训练。图像被调整,使得它们的尺度(短边)为800像素[21]。每个小批次在每个GPU上有2幅图像,每个图像具有N个采样的ROI,正负比为1:3[9]。N在C4中为64,FPN中为512。我们在8个GPU(最小有效批量为16)上进行160k次迭代训练,学习率为0.02,在120k次迭代时减少10%。我们使用0.0001的权重衰减和0.

剩余内容已隐藏,支付完成后下载完整资料

资料编号:[17771],资料为PDF文档或Word文档,PDF文档可免费转换为Word

以上是毕业论文外文翻译,课题毕业论文、任务书、文献综述、开题报告、程序设计、图纸设计等资料可联系客服协助查找。

您可能感兴趣的文章

- 气候系统模式BCC_CSM1.1对东亚高空对流层急流和相关瞬变涡流活动的模拟外文翻译资料

- 基于FAO Penman-Monteith方程与每日天气预报信息估算参考蒸散量研究外文翻译资料

- 稳定非饱和渗流条件下的无限大边坡稳定性外文翻译资料

- CMIP5模式下中国极端降水指数。第二部分:概率投影外文翻译资料

- 2013年2月8-9日东北部地区暴风雪过程的偏振雷达和微物理过程研究外文翻译资料

- 华南前汛期香港中尺度暴雨的研究外文翻译资料

- 边界层对极地春季臭氧损耗现象起止的影响外文翻译资料

- 一种利用神经网络从具有高光谱分辨率的红外光谱 反演温度信息的方法外文翻译资料

- 1961 ~ 2004年青藏高原夏季降水的时空分布外文翻译资料

- 中国中东部地区冬季雾——霾日的年际变化及其与东亚冬季风的关系外文翻译资料