弱监督神经文本分类

Yu Meng, Jiaming Shen, Chao Zhang, Jiawei Han

伊利诺伊大学厄巴纳 - 香槟分校计算机科学系,美国伊利诺伊州

{yumeng5, js2, czhang82, hanj}@illinois.edu

摘要

深度神经网络因其强大的表达能力以及对特征工程的要求较低,而在经典文本分类任务中越来越流行。尽管如此具有吸引力,但神经文本分类模型在实际运用中面临着缺乏训练数据的问题。虽然存在许多半监督和弱监督的文本分类模型,但它们不能很好地应用于深度神经模型,同时仅支持有限的监督类型。在本文中,我们提出一种弱监督方法,这种方法能够解决神经文本分类中缺乏训练数据的问题。这个的方法包含两个模块:(1)伪文档生成器,他利用种子信息生成用于模型预训练的伪标记文档,(2)自我训练模块,用于引导真实的未标记数据以进行模型细化。我们的方法可以灵活地处理各种不同类型的弱监督,并且可以轻易地集成到现有的深度神经网络文本分类模型。我们对来自不同领域的三个真实数据集进行了大量实验。结果表明,我们提出的方法实现了令人激动的性能,而不需要过多的训练数据,并且显著优于基线方法。

关键词 文本分类,弱监督学习,伪文档生成,神经分类模型

1 介绍

在各种应用中,如情感分析到文档分类和查询意图分类,文本分类都发挥着重要作用。最近,深度神经模型(包括卷积神经网络CNNs和递归神经网络RNNs)已经证明其在这项经典任务的优越性。这些神经模型对文本分类任务的吸引力是双重的。首先,它们可以通过自动学习捕获文本语义的分布式表达来大大减少特征工程的工作。其次,它们具有强大的表达能力,因此有可能更好地从数据中学习并产生更好的分类性能。

尽管神经模型对于文本分类有着如此吸引力、并且也日益流行,但训练数据的缺乏仍然是阻碍它们在许多实际场景中被采用的关键瓶颈。实际上,用于文本分类的深度神经模型的训练能够轻而易举的消耗百万级标记文档。收集这些训练数据需要该领域专家阅读数百万份文档,并依靠领域知识仔细对其进行标记,而这通常过于昂贵而无法实现。

为了解决标记稀缺的瓶颈,我们研究了弱监督学习神经模型在文本分类的问题。通常情况下,虽然用户无法标记许多用于训练神经模型文档,但他们可以为分类任务提供少量种子信息。这样的种子信息可以是各种形式:每个类的一组代表性关键词,一些(少于十二个)标记文档,或者甚至仅是类的表面名称。这种问题被称为弱监督文本分类。

现在有许多弱监督文本分类相关的研究。然而,弱监督训练文本分类的神经模型仍然是一个开放的研究问题。虽然已经提出了几种半监督神经模型,但是它们仍然需要数百甚至数千个标记的训练示例,这在弱监督环境中并不适用。另一方面,用于弱监督文本分类的现有方法中,包括了潜变量模型和基于嵌入的方法。这些模型具有以下局限性:(1)监督不灵活:它们只能处理一种类型的种子信息,标记文件的集合或者是一组与类相关的关键词,这限制了它们的适用性;(2)种子敏感性:用户的“种子监督”完全控制模型训练过程,使学习模型对初始种子信息非常敏感;(3)有限的可扩展性:这些方法特定于潜变量模型或嵌入方法,难以应用于基于CNN或RNN的深度神经模型。

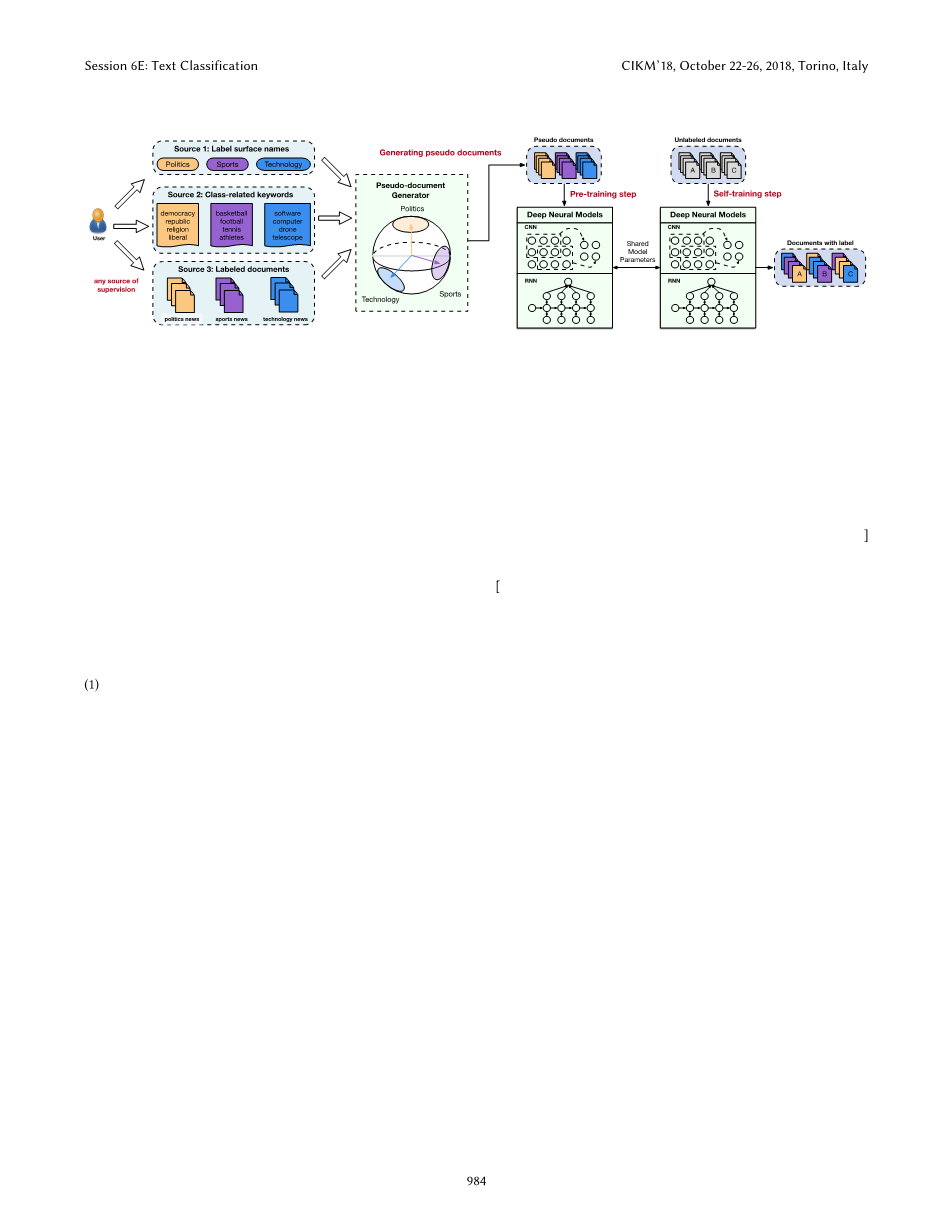

图1

我们提出了一个名为WeSTClass的新方法,用于弱监督文本分类。如图1所示,WeSTClass包含了两个模块来解决上述挑战。第一个模块是伪文档生成器,它利用种子信息来生成伪文档作为综合训练数据。假设单词和文档表示位于同一语义空间中,通过将每个类的语义建模为高维球形分布来生成每个类的伪文档,并进一步对关键词进行采样以形成伪文档。伪文档生成器不仅可以扩展用户给定的种子信息以便更好地泛化,而且可以灵活地处理不同类型的种子信息(例如标记表面名称、类相关关键词、少数标记文档等)。

我们方法的第二个关键模块是一个自我训练模块,它适用于真实的未标记文档以进行模型细化。首先,自我训练模块使用伪文档在基于CNN或基于RNN的模型中预训练以产生初始模型,该初始模型用作后续模型精炼过程中的起点。然后,它运用自我训练程序,迭代地对真实的未标记文档进行预测,并利用高可信度预测来改进神经模型。

总之,本文做了一下工作:

(1)设计了WeSTClass方法来解决神经文本分类问题中标记稀缺的瓶颈问题。据我们所知,WeSTClass是第一个弱监督文本分类方法,可以应用于大多数现有的神经模型,可以同时处理不同类型的种子信息。

(2)将类语义建模为球形分布,提出一种新型的伪文档生成器。生成器能够生成与每个类高度相关的伪文档,同时有效地扩展用户提供的种子信息以便更好地进行泛化。

(3)提出了一种利用伪文档训练深度神经模型的自我训练算法。自我训练算法可以迭代地引导未标记的数据训练以获得高质量的深度神经模型,并且其通用性足以集成到基于CNN或基于RNN的模型中。

(4)对来自不同领域的三个真实数据集进行了全面的评估。实验结果表明,即使没有太多的训练数据,我们的方法也可以实现令人激动的文本分类性能,并且优于各种基线方法。

2 相关工作

在本节中,我们回顾现有的弱监督文本分类,它们可以分为两类:(1)潜变量模型;(2)基于嵌入的模型

2.1 潜变量模型

现有用于弱监督文本分类的潜变量模型主要通过结合用户提供的种子信息来扩展模型。具体而言,半监督PLSA通过结合专家评论片段(主题关键词或短语)的共轭先验来扩展经典PLSA模型,以使得提取的主题与提供的评论片段保持一致。对潜在变量概率模型的后验约束中的先验知识和间接监督进行编码。描述性LDA使用LDA模型作为描述设备,从给定的类别标记和描述中推断出狄利克雷先验。狄利克雷先验引导LDA引发类别感知主题。种子引导主题模型采用与该类别的语义相关的一组少量关键词,然后通过两种主题影响来预测文档的类别标记:类别主题和一般主题。文件的标记是基于后验类话题分配推断。我们的方法与这些潜变量模型的不同之处在于它是一种弱监督神经模型。因此,它相比于这些潜变量模型具有两个优点:(1)它更加灵活,可以处理不同类型的种子信息,这些种子信息可以是标记文档的集合或与每个类相关的一组少量关键词;(2)它不需要对文档主题或主题关键词分布进行假设,而是直接使用海量数据来学习分布式表示来捕获文本语义。

2.2 基于嵌入的模型

基于嵌入的弱监督模型使用种子信息来导出文本分类任务中文档和标记名称的矢量化表示。无数据的分类将类别名称和项目每个词和文档都放入维基百科概念的相同语义空间中。每个类别都用类别标记中的词表示。使用显式语义分析文档和类别之间的矢量相似性来进行文档分类。无监督神经分类将类别名称作为输入并采用级联嵌入方法:首先将种子类别名称和其他重要短语(概念)嵌入到用于捕获概念语义的向量中。然后将概念嵌入到隐藏的类别空间,使类别信息显式化。预测文本嵌入是一种半监督算法,它利用标记和未标记的文档来学习专门用于任务的文本嵌入。标记数据和不同级别的单词共现信息首先表示为大规模异构文本网络,然后嵌入到保持单词和文档的语义相似性的低维空间中。使用one-vs-rest逻辑回归模型作为分类器并将学习的嵌入作为输入来执行分类。与我们的方法相比,这些基于嵌入的弱监督方法不能直接应用于文本分类任务的深度神经模型(CNN,RNN)。此外,虽然它们允许种子信息直接控制模型训练过程,但我们引入了伪文档生成范例,其从种子信息推广出来。因此,我们的模型不太容易出现种子信息过度拟合,并且具有更好的泛化能力。

3 初步准备

在本节中,我们公式化弱监督文本分类的问题,并概述了我们提出的方法。

3.1 问题公式化

给定一个文本集和m个目标类,文本分类的目标就是为每一个文档分配一个类标记。为了描述每个类,传统的监督文本分类方法依赖于大量标记文档。这项工作中,我们专注于弱监督环境下的文本分类,其中监督信号是以下来源之一:(1)标记的表面名称:,Lj是分类Cj的表面名称,(2)类相关的关键词:,其中表示分类Cj的一组k个关键词,(3)带标记文档:,其中表示属于分类Cj中的一组个带标记的文档。在许多情况下,用户可以很容易获得上述弱监督信号。最后,我们将问题定义如下:

定义3.1(问题公式化)。给定一个文本集和m个目标类,以及来自L,S或DL的弱监督,若监督文本分类的任务是每一个文档分配一个类标记。

3.2 方法概述

我们提出的弱监督文本分类方法包含两个关键模块。第一个是伪文档生成器,它统一种子信息并输出用于模型训练的伪文档。我们假设单词和文档共享一个联合语义空间,为处理不同类型的种子信息提供了灵活性。然后,我们将每个类建模为高维球形分布,从中对关键词进行采样以形成伪文档作为训练数据。我们方法的第二个关键模块是一个自我训练模块,它可以轻易地集成到现有的深度神经模型中——无论是基于CNN还是基于RNN。它首先使用生成的伪文档来预先训练神经模型,这使得模型以良好的初始化开始。然后,运用自我训练程序,迭代地对真实的未标记文档进行预测,并利用高可信度预测来改进神经模型。我们在图1中展示了我们方法的整个过程。

4 伪文档生成

在本节中,我们将描述伪文档生成器的详细信息,该生成器利用种子信息生成一组与每个类相关的伪文档。下面,我们首先介绍如何使用单词和文档在联合语义空间中对类分布进行建模,然后描述伪文档生成过程。

4.1 类的分布建模

为了有效利用用户提供的种子信息,以及捕捉词,文档和类别之间的语义相关性,我们假设词和文档共享一个联合语义空间,基于此我们学习每个类的生成模型以生成伪文档。

具体来说,我们首先使用Skip-Gram模型来学习语料库中所有单词的p维向量表示。此外,由于向量之间的方向相似性在捕获语义相关性方面更有效,我们将所有单词嵌入的p维向量规范化,以便它们位于p维实数坐标中的单位球体上,该球体便是联合语义空间。我们称之为“联合”,因为我们假设伪文本向量也位于同一个单位范围内,我们将在4.2节中解释。我们基于种子信息在语义空间中取出一组与每个类相关的关键词。我们将描述如何处理不同类型的种子信息,如下所示:

- 标记表面名称:当仅给出标记表面名称L作为种子信息时,对于每个类j,我们使用其表面名称Lj的嵌入来检索语义空间中的最接近的t个词。我们将t设置为不会导致跨不同类的共享单词的最大数字。

- 类相关的关键词:当用户为每个类j提供一系列关键词Sj是,我们通过测量种子关键词的平均相似度,利用这些种子关键词的嵌入来检索语义空间中的最接近的t个词。

- 带标记的文档:当用户提供少量与类j相关的文档时,我们首先利用tf-idf加权算法从中提取t个代表性的关键词,然后考虑将他们作为类相关关键词。

在获得与每个类相关的一组关键词之后,我们将每个类的语义建模为von Mises Fisher(vMF)分布,其在p维实数坐标中对单位球上的单词嵌入进行建模的有效性已经在各种任务体现出来。具体来说,我们将类的概率分布定义为:

,

其中,归一化常数:

其中Ir(·)表示改进的第一类r阶贝塞尔函数。我们选择vMF分布的理由如下:vMF分布有两个参数——平均方向mu;和浓度参数k。对于某一确定的类,关键词在单位球上的分布集中在平均方向mu;附近,并且如果k很大则更集中。直观的说,平均方向mu;作为单位球的语义焦点,并在其周围产生相关的语义嵌入,其中集中度由参数k控制。

现在我们已经利用种子信息来获得单位球上每个类的一组关键词,我们可以使用这些相关关键词来拟合vMF分布。具体来说,让X是单位球上关键词的一组向量,即:

,

然后我们用最大似然估计找到vMF分布参数mu;和k:

获得的解析解是不可行的,因为该公式涉及隐式方程,它是贝塞尔函数的比率。因此,我们使用基于牛顿迭代法的数值程序来推导出的近似值。

4.2 生成伪文档

为了生成关于类j的伪文档(我们用代替表示这是一个伪文档),我们提出了一个基于类j分布的生成一个混合模型。混合模型重复生成多项来生成一篇伪文档;在生成每个项时,模型从概率为alpha; (0 lt; alpha; lt; 1)的背景分布和具有概率1 - alpha;的类特定分布中选择。

特定类的分布是由基于类j分布的来定义的。特别地,我们首先用对文本向量进行采样,然后为di构建关键词词汇表,其中包含了与di嵌入最相似的gamma;个词。中的gamma;个词都与伪文档高度相关,且在中频繁出现。伪文档的每一项生成都是根据下面的概率分布:

其中是w的嵌入词,是整个语料库的背景分布。

注意到我们从生成了文本向量,而不是将他们

全文共13467字,剩余内容已隐藏,支付完成后下载完整资料

英语原文共 10 页,剩余内容已隐藏,支付完成后下载完整资料

资料编号:[3075]

以上是毕业论文外文翻译,课题毕业论文、任务书、文献综述、开题报告、程序设计、图纸设计等资料可联系客服协助查找。