译文出处:Izquierdo C E, Velarde J L G, Batista B M, et al. Estimation of Distribution Algorithm for the Quay Crane Scheduling Problem[J]. Applied Soft Computing, 2013, 13(10):4063–4076.

视觉SLAM使用多个RGB-D摄像头

摘要:

本文提出了一种利用多台RGB-D摄像机实现视觉同步定位与地图的方法。在SLAM系统中,我们整合了来自RGB-D摄像机的视觉和深度测量数据,以实现在未知环境下更健壮的姿态跟踪和更详细的环境地图。给出了多摄像机情况下RGB-D SLAM系统姿态跟踪和地图细化迭代优化的数学分析。最终的SLAM系统允许配置多个RGB-D摄像机,具有不重叠的视场(fov)。在此基础上,提出了一种基于slam的相机外部标定半自动方法。最后,在复杂室内场景下的实验验证了该算法的有效性。

1. 介绍

为了实现视觉SLAM更加稳健的位姿跟踪,前人在融合多模态传感器信息方面做了大量工作,如融合惯性测量。最近,机器人社区对利用多台摄像机提高可视SLAM的性能表现出了越来越大的兴趣。造成以上两种趋势的原因是单目视觉SLAM系统在复杂环境下,单台摄像机观测到的视觉特征较差,容易导致姿态跟踪失败。这也适用于立体视觉SLAM和RGB-D SLAM,它们使用有限的fov在一个特定的方向上拍摄。实际上,将多个不同方向的摄像机集成在一起,可以获得更大的有效FOV,从而观察到更可靠的视觉特征,完成姿态跟踪和地图更新任务。这意味着可以通过扩展单目视觉SLAM来利用多个摄像机的测量来实现更好的姿态跟踪鲁棒性。

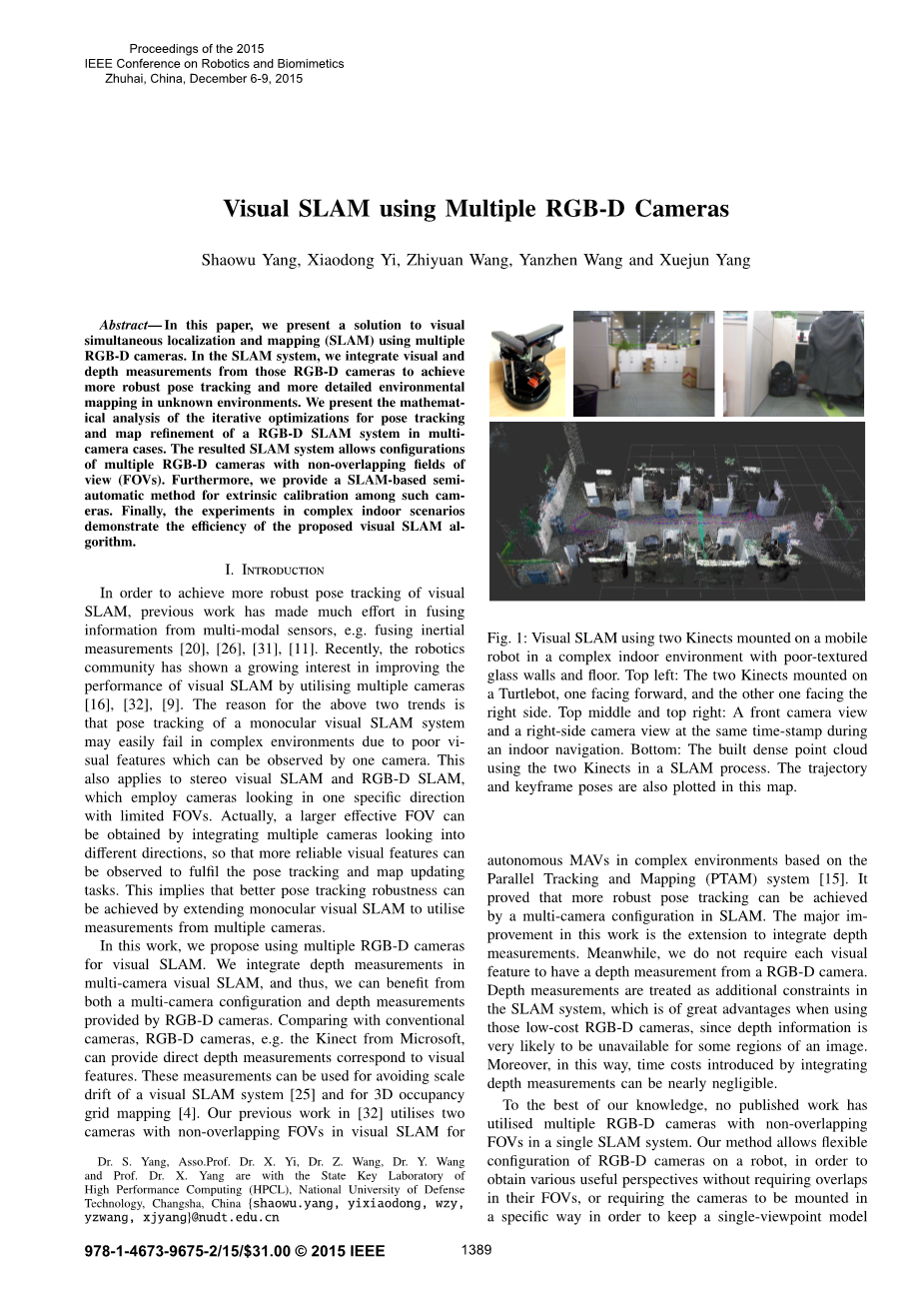

图1 左上 上中 上右

图2 密集点云图

在这项工作中,我们建议使用多个RGB-D摄像机进行可视SLAM。我们在多相机可视SLAM中集成了深度测量,因此,我们可以从RGB-D相机提供的多相机配置和深度测量中获益。与传统相机相比,RGB-D相机,如微软Kinect,可以根据视觉特征提供直接的深度测量。这些测量可用于避免视觉SLAM系统的尺度漂移和3D占用网格地图。我们之前的工作是在visual SLAM中使用两个fov不重叠的摄像头。图1:在复杂的室内环境中,玻璃幕墙和地板纹理较差,使用安装在移动机器人上的两个Kinects进行visual SLAM。左上: 两个Kinects分别面向前方和右侧,安装在一只乌龟身上。上中、上右:在室内导航时,同时显示前视图和右侧视图。下图:SLAM过程中使用两种Kinects构建的密集点云。轨迹和关键帧的姿态也绘制在这张地图。

基于并行跟踪与地图(PTAM)系统的复杂环境下的自主无人机。结果表明,在SLAM中采用多摄像机配置可以实现更稳健的姿态跟踪。这项工作的主要改进是扩展了深度测量的集成。同时,我们并不要求每个视觉特征都有一个来自RGB-D相机的深度测量。深度测量在SLAM系统中被视为附加的约束条件,这在使用那些低成本的RGB-D相机时具有很大的优势,因为深度信息很可能在图像的某些区域是不可用的。此外,通过这种方式,集成深度测量所带来的时间成本几乎可以忽略不计。

据我们所知,还没有其他的成就在单一SLAM系统中使用过具有非重叠fov的多个RGB-D摄像机。我们的方法允许在机器人上灵活配置RGB-D摄像机,以获得各种有用的视角,而不需要fov重叠,也不需要以特定的方式安装摄像机,以保持单视角模型作为一些全向摄像机。我们将来自多个RGB-D摄像机的视觉和深度测量数据进行了集成,并对如何将这些测量数据融合到visual SLAM的优化中进行了数学分析。

2. 相关工作

利用多摄像机系统进行位姿估计的早期工作可以在运动结构(SFM)中找到。[21]中的工作给出了SFM中多摄像机系统的理论处理,推导了广义上的超极约束。在[6]中,提出了一种虚拟摄像机作为多摄像机系统姿态估计的表示。本文采用多摄像机实现了一种结构自运动方案。文献中有许多关于移动机器人姿态估计的多摄像机系统的最新研究。在[23]中,利用两对立体摄像机结合扩展卡尔曼滤波器求解移动机器人的位姿估计问题。这项工作采用一种多摄像机系统的广义摄像机模型,利用2点随机抽样方法估计自驾车运动。在[18]的进一步研究中,这个问题用一个最小的三点对应集来解决。

近年来,多摄像机系统应用于可视SLAM中。在[13]的工作提出了一个关于视觉SLAM与多摄像机设备使用哈里斯角探测器[7]的解决方案。在[14]中,提出了一种考虑机器人运动下摄像机所能观察到的运动特征的贝叶斯数据关联方法。[27]的工作解决了多摄像机目视SLAM中存在的两个不同问题:执行SLAM时的立体设备自动自校准和单眼SLAM协同工作。进一步实现了微型飞行器自主导航的多摄像机可视SLAM。在[29]中,多摄像头可视SLAM是基于PTAM的另一个改进版本实现的。SLAM系统利用泰勒全向相机模型和球面坐标更新方法,在缺乏精确度量尺度的情况下,实现了位姿跟踪与地图的收敛。对于大型环境下的无人机自主导航,[33]中的工作对[32]中的工作进行了修改,使之成为一个健壮的视觉里程计,实现了一个高效的后端闭环。在[9]中,基于广义摄像机模型,利用两对立体对估计了一种微型飞行器的姿态。利用惯性信息,利用米制尺度恢复飞行器的相对运动。在[33]和[9]两种平台上都实现了无人机上实时闭环运行。在[17]的工作中,还引入了多个摄像机来实现闭环。在本研究中,我们利用多摄像机系统的超极几何来获得两个闭环位图顶点之间的相对位姿,而不需要重建三维场景点。

虽然据作者所知,还没有发表的作品展示过使用多个RGB-D相机SLAM,但是在文献中可以找到很多关于使用单个RGB-D相机SLAM的研究。在[10]中,使用连续RGB图像之间匹配特征的深度测量来确定它们的3D位置,这是对更精确的迭代最近点(ICP)算法的初始化。[28]中的SLAM系统使用两层方法来高效地优化地图。它也适用于RGB-D摄像机。[25]中的工作利用PTAM系统中的深度信息解决了单目目视SLAM中的尺度模糊和尺度漂移问题。[5]中的SLAM系统利用两个平面镜子分割RGB-D摄像机的FOV,覆盖移动机器人的前后视图。[30]中的工作在MAV上执行RGB-D视觉里程测量,使其能够自主飞行。然后构建三维占用网格图进行路径规划。为了使用多台摄像机进行位姿估计,需要对多台摄像机进行外部标定。我们在这方面的兴趣主要集中在无重叠fov相机的自动标定上。[3]文献中的工作提出了一种基于SLAM的多摄像机自动标定方案。它使用全局bundle adjustment来优化不同可视SLAM实例构建的地图的对齐,每个可视SLAM实例对应一个摄像机。提出的解决方案按比例计算摄像机之间的相对三维姿态。在[8]最近的一项工作中,自动外部校准是基于之前构建的准确的环境地图实现的。将同步相机在地图环境中进行运动标定,通过2D-3D对应得到一组同步相机的位姿估计,然后进行非线性优化处理,得到初始猜测后的相对位姿估计。

3. 多RGB-D摄像镜头的视觉SLAM

A. 相机投影模型和姿势更新

使用与[15]相同的校准相机模型,地图点pj到相机Ci的图像投影为

其中PCi为考虑镜头畸变的摄像机Ci的投影函数,Pj为地图点pj的世界坐标,Eciw为Lie group SE(3)的成员,表示摄像机在世界坐标系中的姿态,包含旋转和平移分量。

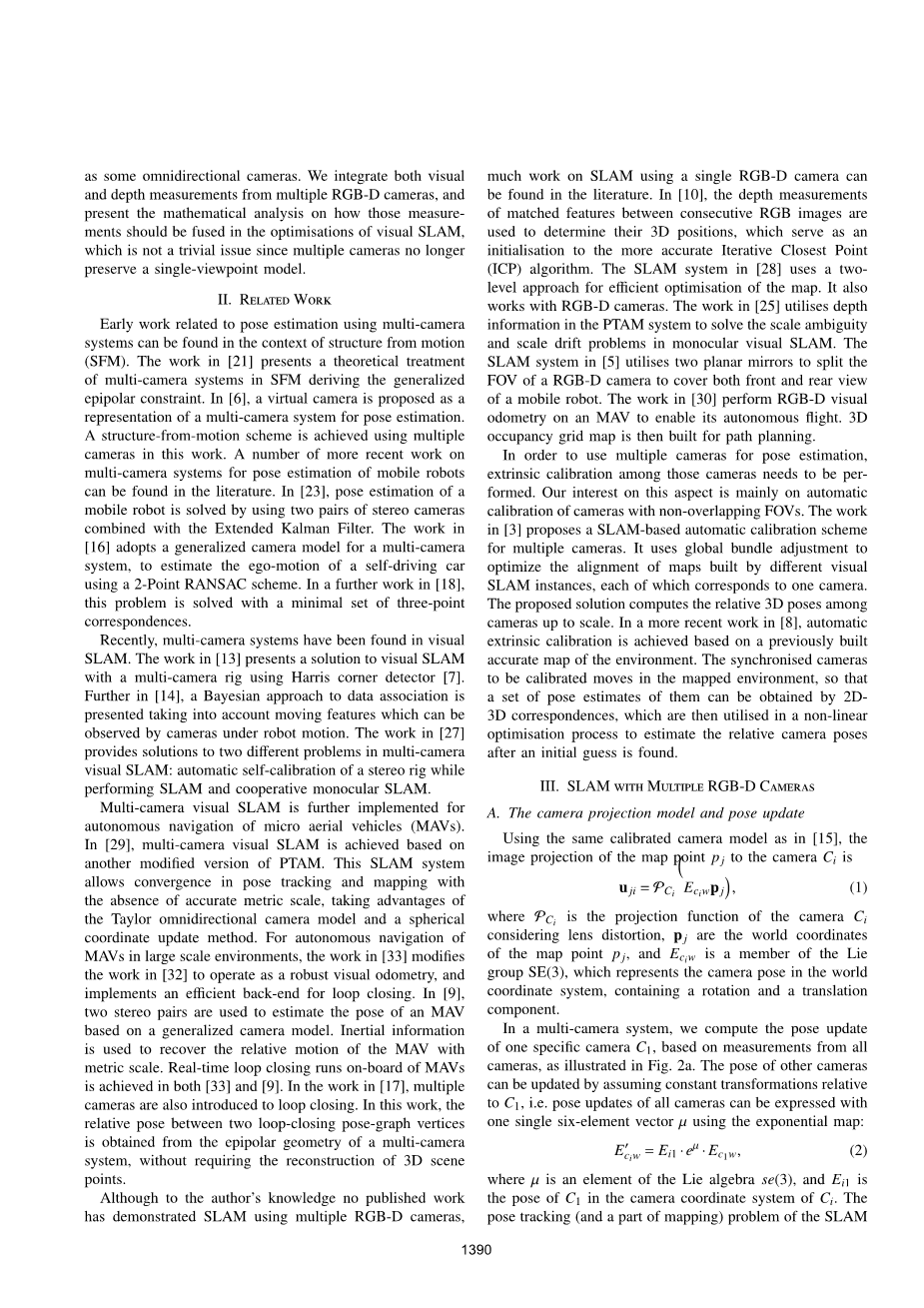

在多摄像机系统中,我们根据所有摄像机的测量值,计算一个特定摄像机C1的位姿更新,如图2a所示。其他相机的姿势可以被假定为相对于C1的常数转换,即提出更新的所有的相机都可以被表示为一个六维向量micro;通过使用指数地图:

其中u是一个在Lie algebra se(3) 中的元素。Ei1是摄像机坐标系统Ci中C1的位姿。图2:(a)双摄像头情况下摄像头姿态更新的二维示意图,(b)双摄像头在两个时间点获得的四个关键帧。对于摄像机位姿的更新,使用所有相机的图像测量来找到C1相机的位姿更新。对于捆绑包(通常在每个基于feature的3D场景重建算法中都要用到BundleAdjustment,它是基于3D结构和视角参数(即相机位置,朝向,固有标定和径向畸变)的优化问题,在假定所获得的图像特征中有一些noise的基础上获得最佳重构效果:如果图像featureerror服从标准高斯分布,那么BundleAdjustment就基于最大似然估计。BundleAdjustment的名字由来于每个3D特征和相机光学中心“发射”出的光束,而这些光束可以根据结构和视角参数进行最佳调节。BundleAdjustment诞生于1950年的摄影学中,之后迅速的被ComputerVision应用。)的调整,所有关键帧的图像测量都被用来发现关键帧K1(K11,K12)的动作更新以及所有测量的地图点的位置更新。

图2

系统主要由如何获得一个优化micro;作为相机C1的姿态更新通过最小化目标函数。相机位姿更新的参数化的优势是它允许方程式(2)封闭的分化通过使用6维向量u

B. 地图

SLAM系统的地图由视觉系统中所有摄像机在不同时间戳下获得的关键帧K和摄像机测量的三维地图点P组成。通过对某一摄像机连续关键帧中匹配的FAST角[24]进行立体三角剖分,或对对应的图像特征进行直接深度测量,可以定位并添加到地图点pj。每个关键帧保存它的绝对姿态和所有的观察到的地图点。我们允许用不同的摄像机观察每个地图点。图2(b)展示了双镜头情况下具有四个关键帧的地图段。

C. SLAM系统概述

SLAM系统的实现基于PTAM框架。它主要由两个独立的线程组成,其中使用了来自多个摄像机的图像:在第一个线程中,负责摄像机姿态跟踪,将固定距离搜索应用于对应于多个摄像机图像中可能可见的地图点的快速特征。然后将得到的2D-3D对应关系用于摄像机姿态跟踪。第二线程将新关键帧从多个相机集成到地图并创建新的地图点。此外,还需要进行本地绑定调整来优化地图。

在我们的视觉SLAM系统中,相机姿态跟踪和地图细化(使用捆绑包调整)是通过迭代最小化图像测量集si重投影误差的鲁棒目标函数来完成的,si是每台相机(或关键帧)i中观测到的地图点。

在一个n-camera(或n-keyframe)系统中,我们需要最小化这个函数

其中,Obj是一个目标函数[12],|eji|是摄像头i测量的点j的重投影误差,sigma;ji是点j的估计测量噪声。sigma;T是所有重投影误差分布的稳健标准误差估计。eji定义为地图点j的图像重投影与其实际测量图像的差值:

当使用RGB-D相机时,我们使用深度测量Di,然后在Si中相应的图像观察值进行捆绑包调整,类似于[25]。然而,由于深度测量误差和图像像素不能在同一个单元中建模,我们将函数建模为以统一形式最小化为

其中C包含n个摄像头(姿态跟踪)或n个关键帧(捆绑包调整),S和D分别为Si和Di的集合。是dji的深度测量误差,它会在Sect. III-E中被分析,这个函数不要求Si中的每个观测都有深度测量。关于n-camera的姿态跟踪系统,优化问题是找到相机C1的优化姿态更新u,通过使用所有相机在当前时间点的图像测量

然后可以推导出所有摄像机的姿态,通过公式(2)

本地捆绑包调整用于改善最近的关键帧位姿和相关的地图点位置在文献[15]里面。在我们的工作中,所有摄像机的测量被利用起来了去计算被第一个摄像机C1获取的关键帧集K1的优化位姿更新。其他刚性连接关键帧Kc的位姿是根据K1中相关关键帧的更新位姿计算的,如图2b所示。这个被在Ka或者Kc测量的地图点Pa的位置也会在捆绑包调整里更新。因此,本地捆绑包调整在我们的SLAM系统里面意味着解决如下最小化问题:

其中,,Kf是包含关键帧的进一步固定关键帧集,其中该关键帧对pa中的任意点进行了测量。Sl是Pa的图像测量值。Dl包含Pa可以获得的所有深度测量值。

D. 雅克比矩阵

利用加权非线性最小二乘迭代法可以解决上述问题。有效地做到这一点的一个基本要求是区分测量误差,即根据需要估计的参数来获得它们的雅可比矩阵。衍生品的跟踪,e霁的估计相机姿态更新micro;需要计算。衍生品的束调整,eji ed霁micro;和地图点位置pj也是必需的。在[32]中,我们为多个常规相机提供了eji的导数。在本节中,我们将工作扩展到分析RGB-D摄像机的深度测量误差。

4. 重新定位

由于

全文共6618字,剩余内容已隐藏,支付完成后下载完整资料

英语原文共 7 页,剩余内容已隐藏,支付完成后下载完整资料

资料编号:[709]

以上是毕业论文外文翻译,课题毕业论文、任务书、文献综述、开题报告、程序设计、图纸设计等资料可联系客服协助查找。

您可能感兴趣的文章

- 2.3港口吞吐量预测外文翻译资料

- 使用多标准移动通信分层遗传算法的阻抗 匹配网络的宽带优化外文翻译资料

- 移动RFID标签阅读与非重叠串联阅读器在输送带的应用外文翻译资料

- 利用数字图像进行的全场应变测量方法外文翻译资料

- 自然灾害中并发事件的多种应急资源的分配外文翻译资料

- 基于主机的卡仿真:开发,安全和生态系统影响分析外文翻译资料

- 实现基于Android智能手机的主机卡仿真模式作为替代ISO 14443A标准的Arduino NFC模块外文翻译资料

- 探索出行方式选择和出行链模式复杂性之间的关系外文翻译资料

- 信息系统研究、教育和实践的基本立场及其影响外文翻译资料

- 仓储和MH系统决策模型的设计优化与管理外文翻译资料