英语原文共 9 页,剩余内容已隐藏,支付完成后下载完整资料

用于单幅图像超分辨率的增强深度残差网络

摘要

近年来,随着深卷积神经网络(DCNN)的发展,超分辨率的研究也取得了新的进展。特别是,残差学习技术表现出更好的性能。本文提出了一种改进的深度超分辨率网络(EDSR),其性能优于目前最先进的SR方法。该模型的显著性能改进是由于在传统的剩余网络中去掉了不必要的模块而进行了优化。在稳定训练过程的同时,通过扩展模型尺寸进一步提高了训练效果。我们还提出了一种新的多尺度深度超分辨率系统(MDSR)和训练方法,可以在一个模型中重建不同上尺度因子的高分辨率图像。所提出的方法在基准数据集上显示出优于最新方法的性能,并通过赢得NTIRE2017超级分辨率挑战赛证明了其卓越性[26]。

一、引言

图像超分辨率(SR)问题,特别是单图像超分辨率(SISR)问题,几十年来得到了越来越多的研究关注。SISR的目标是从一幅低分辨率图像当中重建一幅高分辨率图像。通常情况下,与原始高分辨率图像之间的关系可能因情况而异。许多研究假设是的双三次插值版本,但在实际应用中,也可以考虑模糊、数据抽取或噪声等其他劣化因素。

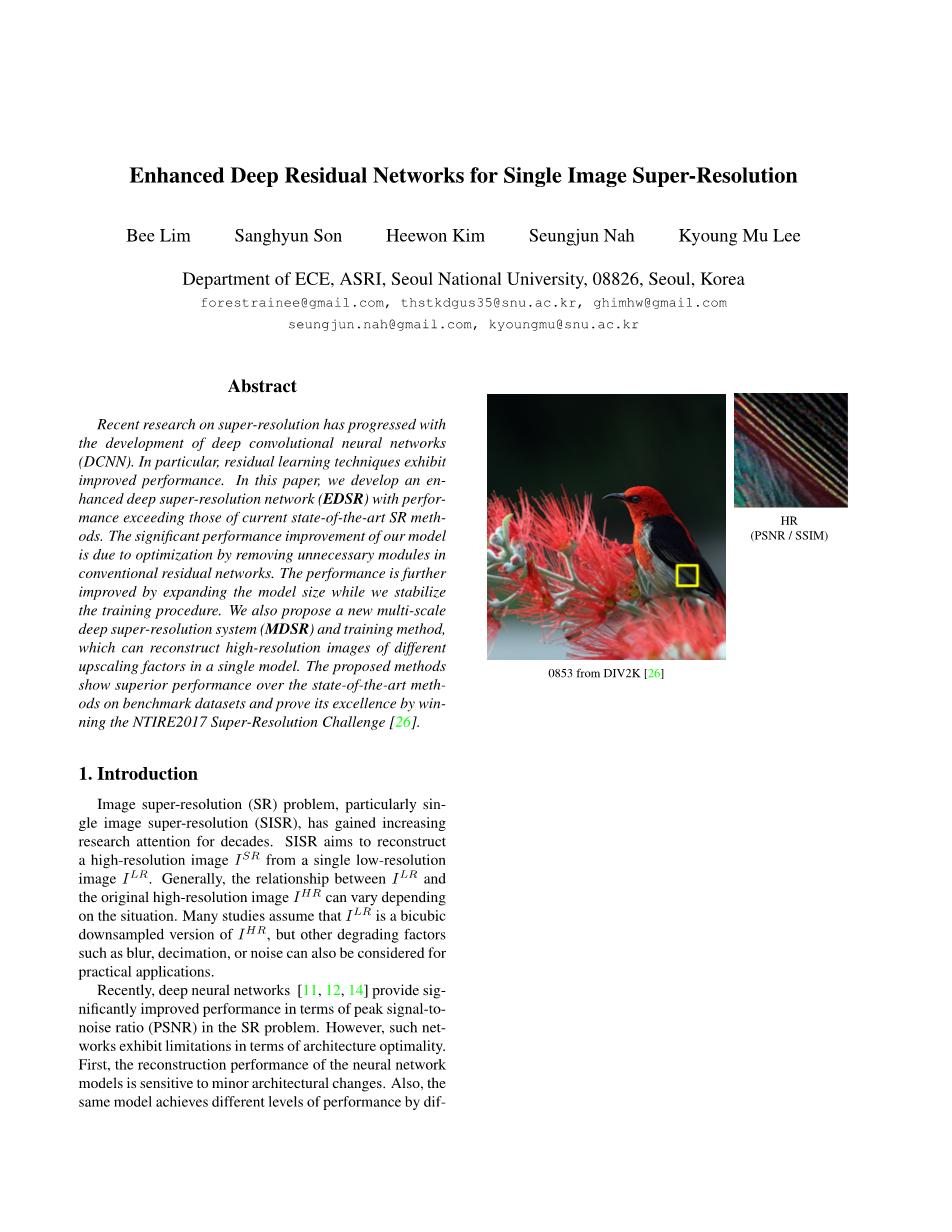

图1:我们的单尺度SR方法(EDSR)的times;4超分辨率结果与现有算法相比

最近,深度神经网络[11,12,14]在SR问题中提供了峰值信噪比(PSNR)方面的显著改进。然而,这种网络在结构优化方面表现出局限性。首先,神经网络模型的重建性能对微小的结构变化敏感。同样,同一个模型通过不同的初始化和训练技术会达到不同的性能水平。因此,精心设计的模型结构和复杂的优化方法对神经网络的训练至关重要。

其次,现有的SR算法大多将不同尺度因子的超分辨率问题作为独立问题来处理,没有考虑和利用SR 中不同尺度之间的相互关系。因此,这些算法需要许多特定规模的网络,这些网络需要独立训练以处理不同尺度的问题。特别情况下,VDSR[11]可以在单个网络中联合处理多个尺度的超分辨率。多尺度训练的VDSR模型显著提高了系统的性能,并优于尺度特定训练,这意味着尺度特定模型之间存在冗余。尽管如此,VDSR风格的体系结构需要双三次插值图像作为输入,与采用比例特定的上采样方法的体系结构相比导致了更大的计算时间和内存[5,22,14]。

尽管SRRes-Net[14]以良好的性能成功地解决了这些时间和内存问题,但它仅仅采用了He等人的Res-Net体系结构,[9] 没有太多修改。然而,原始的Res网是为了解决更高层次的计算机视觉问题,如图像分类和检测。因此,将Res-Net体系结构直接应用于超分辨率等低层次视觉问题可能是欠佳的。

为了解决这些问题,基于SRRes网络结构,我们首先通过分析和删除不必要的模块来优化SRRes网络结构。当模型复杂时,训练网络就变得很重要了。因此,我们对网络进行了适当的损失函数训练,并在训练的基础上对模型进行了细致的修改。实验表明,改进后的方案取得了较好的效果。

其次,我们研究了模型训练方法,该方法是从在其他尺度上训练的模型迁移学习的。为了在训练过程中利用尺度的无关信息,我们从预先训练的低尺度模型训练高尺度模型。此外,我们还提出了一种新的多尺度结构,在不同尺度上共享大部分参数。与多个单尺度模型相比,所提出的多尺度模型使用的参数明显减少,但显示出可比较的性能。

我们在标准基准数据集和新提供的DIV2K数据集上评估我们的模型。所提出的单尺度和多尺度超分辨率网络在PSNR和SSIM方面显示了所有数据集的最新性能。我们的方法在2017年第二届超级分辨率挑战赛中分别排名第一和第二。

2、相关理论

为了解决超分辨率问题,早期的方法使用基于采样理论的插值技术[1,15,34]。然而,这些方法在预测细节的真实纹理方面显示出局限性。以往的研究[25,23]采用自然图像统计的方法来重建更好的高分辨率图像。

高级工作旨在学习和图像对之间的映射函数。这些学习方法依赖于从邻域插值[3,2,7,21]到分散编码[31,32,27,33]的技术。Yang等人介绍了另一种对patch空间进行聚类并学习相应函数的方法。一些方法利用图像的自相似性来避免使用外部数据库[8,6,29],并通过补丁的几何变换来增加有限内部字典的大小[10]。

近年来,深度神经网络的强大功能使SR得到了显著的改善。自Dong等人[4,5]首先提出了一种基于深度学习的SR方法,研究了各种CNN结构的SR。Kim等人[11,12]首先引入了剩余网络来训练更深层次的网络结构,并取得了优异的性能。特别地,他们表明跳跃链接和递归卷积减轻了在超分辨率网络中携带身份信息的负担。类似于[20],Mao等人[16] 解决了编码器-解码器网络和对称跳跃链接的一般图像恢复问题。在[16]中,他们认为这些嵌套的跳跃链接提供了快速和较好的收敛性。

在许多基于深度学习的超分辨率算法中,输入图像在进入网络之前通过双三次插值进行上采样[4,11,12]。与其使用插值图像作为输入,还可以在网络的最末端训练上采样模块,如[5、22、14]所示。通过这样做,可以在不损失模型容量的情况下减少许多计算,因为特征的大小会减小。然而,这类方法有一个缺点:它们不能像VDSR[11]那样在单个框架中处理多尺度问题。在这项工作中,我们解决了多尺度训练和计算效率的难题。我们不仅利用了每个尺度下学习特征之间的相互关系,而且提出了一种新的多尺度模型,可以有效地重建不同尺度下的高分辨率图像。此外,我们还开发了一种适当的训练方法,对单尺度模型和多尺度模型都使用多尺度。

为了更好地训练网络模型,一些研究也集中在损耗函数上。均方误差(MSE)或L2损失是一般图像恢复中应用最广泛的损失函数,也是解决这些问题的主要性能指标。然而,赵等人。[35]报告说,在PSNR和SSIM方面,与其他损失函数相比,对L2损失的训练不能保证更好的性能。在他们的实验中,用L1训练的网络比用L2训练的网络获得了更好的性能。

三、提出方法

在本节中,我们将描述所建议的模型体系结构。我们首先分析了最近发表的超分辨率网络,提出了一种结构更简单的剩余网络结构的改进方案。结果表明,我们的网络在提高计算效率的同时,性能优于原始网络。在下面的部分中,我们建议使用处理特定超分辨率比例的单尺度体系结构(EDSR)和在单个模型中重建高分辨率图像的各种尺度的多尺度体系结构(MDSR)。

3.1残差块

近年来,残差网络[11,9,14]在计算机视觉问题中表现出了从低级到高级的优异性能。尽管Ledig等人。[14] 将Res-Net结构成功地应用到SRRes-Net的超分辨率问题中,通过采用更好的Res-Net结构进一步提高了系统的性能。

图2 原始Res Net,SRRes Net和我们自己的残差块的比较。

在图2中,我们比较了来自原始ResNet[9]、SRResNets[14]和我们提出的网络的每个网络模型的构建块。我们将批量归一化层从网络中移除,如Nah等人[19] 在他们的图像去模糊工作中一样。由于批量归一化层规范化了特征,它们通过规范化特征来消除网络的范围灵活性,因此最好删除它们。我们的实验表明,这种简单的修改大大提高了性能,详细可见Sec4。

此外,由于批处理规范化层消耗的内存量与前面的卷积层相同,因此GPU内存使用量也被充分减少。与SRRes网相比,我们的没有批处理规范化层的基准模型在训练期间节省了大约40%的内存使用。因此,在有限的计算资源下,我们可以建立一个比传统Res网络结构性能更好的模型。

图3 建议的单规模SR网络(EDSR)的体系结构

3.2 单尺度模型

提高网络模型性能的最简单方法是增加参数的个数。在循环神经网络中,可以通过多层叠加或增加滤波器的数目来提高模型的性能。具有深度(层数)B和宽度(特征通道数)F的通用CNN架构使用O()参数大致占用O()内存。因此,当考虑有限的计算资源时,增加F而不是B可以使模型容量最大化。

然而,我们发现增加一定数量的特征映射会使训练过程在数值上不稳定。Szegedy[24]等人也报道了类似的现象。我们采用系数为0.1的残差尺度[24]来解决这个问题。在每个剩余块中,在最后一个卷积层之后放置恒定缩放层。当使用大量滤波器时,这些模块极大地稳定了训练过程。在测试阶段,为了提高计算效率,该层可以集成到之前的卷积层中。

我们用图2中提出的残差块构造基准(单尺度)模型。该结构类似于SRRes网[14],但我们的模型在剩余块之外没有Re-LU激活层。另外,我们的基准模型没有剩余的缩放层,因为我们只对每个卷积层使用64个特征映射。在最终的单尺度模型(EDSR)中,我们通过设置B=32,F=256,比例因子为0.1来扩展基准模型。模型架构如图3所示。在对我们的模型进行上采样因子times;3和times;4的训练时,我们使用预先训练的times;2网络初始化模型参数。如图4所示,这种训练前策略加速了训练并提高了最终性能。对于上尺度times;4,如果使用预先训练的尺度times;2模型(蓝线),则训练收敛速度比从随机初始化(绿线)开始的要快得多。

图4 对times;4模型(EDSR)使用预训练的times;2网络的效果。红线表示绿线的最佳性能,训练期间使用10张图像进行验证.

3.3 多尺度模型

从图4的观察,我们得出结论,在多个尺度上的超分辨率是相互关联的任务。我们通过构建一个多尺度体系结构来进一步探索这一思想,该体系结构像VDSR[11]一样利用尺度间的相关性。我们设计了基准(多尺度)模型,使其具有一个主分支,其B=16个残差块,以便在不同尺度上共享大多数参数,如图5所示。

图5 建议的多尺度SR网络(MDSR)的体系结构。

表1 型号规格

在我们的多尺度体系结构中,我们引入特定尺度的处理模块来处理多尺度下的超分辨率。首先,在网络前端设置预处理模块,以减小不同尺度输入图像的方差。每个预处理模块由两个5times;5卷积核的残差块组成。通过为预处理模块采用更大的卷积核,我们在网络的早期阶段则覆盖了较大的接收范围的同时使特定于比例的部分保持较浅。在多尺度模型的最后,将尺度特定的上采样模块并行放置,进行多尺度重建。上采样模块的体系结构与前一节中描述的单尺度模型的体系结构相似。

我们构建了最终的多尺度模型(MDSR),B=80,F=64。我们的三种不同尺度的单尺度基准模型各有大约150万个参数,总计450万个,而我们的多尺度基准模型只有320万个参数。然而,多尺度模型表现出与单尺度模型相当的性能。此外,我们的多尺度模型在深度上是可伸缩的。虽然我们的最终MDSR的深度大约是基准多尺度模型的5倍,但只需要2.5倍的参数,因为残余块比特定尺度的部分更加轻量化。注意,MDSR还显示了与特定规模的edsr相当的性能。我们提出的模型的详细性能比较见表2和表3。

表2 DIV2K验证集(PSNR(d B)/ SSIM)上的体系结构之间的性能比较。 红色表示最佳性能,蓝色表示次优。 EDSR 和MDSR 表示EDSR和MDSR的自集成版本

表3 公开基准测试结果和DIV2K验证结果(PSNR(d B)/ SSIM)。 红色表示最佳性能,蓝色表示次优。 请注意,DIV2K验证结果是从已发布的演示中获取的代码

4、实验

4.1数据集

DIV2K数据集[26]是一种新提出的用于图像恢复任务的高质量(2K分辨率)图像数据集。 DIV2K数据集由800个训练图像、100个验证图像和100个测试图像组成。由于测试数据集的基本真实性没有发布,我们报告并比较了验证数据集上的性能。我们还比较了四个标准基准数据集的性能:Set5[2]、Set14[33]、B100[17]和Urban100[10]。

4.2 训练详情

对于训练,我们使用LR图像48times;48大小的RGB输入块和相应的HR块。我们用随机水平翻转和90次旋转来增加训练数据。我们通过减去DIV2K数据集的平均RGB值来预处理所有图像。通过设置、和=,我们使用ADAM优化器[13]训练模型。我们把小批尺寸设为16。学习率初始化为,每2times;次小批量更新减半。

对于单尺度模型(EDSR),我们按照Sec3.2节中的描述训练网络。times;2模型是从头开始训练的。在模型收敛后,我们将其作为其他尺度的预训练网络。 在每次更新训练多尺度模型(MDSR)时,我们构造一个在times;2、times;3和times;4中随机选择尺度的小批量模型。仅启用和更新与选定比例对应的模块。因此,没有启用或更新与所选比例以外的不同比例相对应的比例尺特定的剩余块和上采样模块。

我们使用L1损耗而不是L2来训练网络。最小化L2通常是首选的,因为它最大化了PSNR。然而,基于一系列的实验,我们经验发现L1损失比L2提供更好的收敛性。对这一比较的评估见4.4。

我们使用Torch7框架实现了所提出的网络,并使用NVIDIA Titan X gpu对其进行了训练。培训EDSR和MDSR分别需要8天和4天。源代码在网上是公开的。

4.3 几何自集成技术

为了最大化模型的潜在性能,我们采用了类似于[28]的自集成策略。在测试期间,我们翻转并旋转输入图像,为每个样本生成七个增强输入,其中表示8个包括恒等的几何变换,。利用增强后的低分辨率图像,利用网络生成相应的超分辨率图像。然后对输出的图像进行逆变换,得到原始的几何图形。最后,我们将变换后的输出平均起来,得到如下的自集成结果。。

这种自系综方法与其他系综相比具有优势,因为它不需要对单独的模型进行额外的训练。这是有益的,尤其是当模型大小或训练时间的问题。尽管自集成策略保持了参数总数不变,但我们注意到,与需要单独训练模型的传统模型集成方法相比,自集成策略提供了大致相同的性能增益。我们通过在方法名中添加“ ”后缀来表示使用自集成的方法;即EDSR /MDSR 。注意,几何自集成技

剩余内容已隐藏,支付完成后下载完整资料

资料编号:[239599],资料为PDF文档或Word文档,PDF文档可免费转换为Word

以上是毕业论文外文翻译,课题毕业论文、任务书、文献综述、开题报告、程序设计、图纸设计等资料可联系客服协助查找。