英语原文共 14 页,剩余内容已隐藏,支付完成后下载完整资料

利用泄露信息进行对抗性训练生成长文本

Jia Jiaian Guodagger;,Sidi Ludagger;,Han Caidagger;,Weinan Zhangdagger;lowast;,Yong Yudagger;,Jun WangDagger;

dagger;上海交通大学, Dagger;伦敦大学学院

{jiaxian,steve lu,hcai,wnzhang,yyu}@apex.sjtu.edu.cn, j.wang@cs.ucl.ac.uk

摘要

自动生成连贯且语义上有意义的文本在机器翻译,对话系统,图像字幕等方面具有许多应用。最近,通过结合策略梯度,生成对抗网(GAN)使用判别模型来指导生成模型的训练。强化学习政策在文本生成方面显示出有希望的结果。然而,标量引导信号仅在生成整个文本之后可用,并且在生成过程期间缺少关于文本结构的中间信息。因此,当生成的文本样本的长度很长(超过20个单词)时,它限制了它的成功。在本文中,我们提出了一个名为LeakGAN的新框架,以解决长文本生成的问题。我们允许判别网络将其自身的高级提取特征泄漏到生成网络, 以进一步帮助指导。生成器通过附加的MANAGER模块将这些信息信号合并到所有生成步骤中,该模块获取当前生成的单词的提取特征并输出潜在向量以指导WORKER模块用于下一单词生成。我们使用图灵测试对合成数据和各种现实世界任务进行了大量实验,证明LeakGAN在长文本生成方面非常有效,并且还提高了短文本生成场景的性能。更重要的是,在没有任何监督的情况下,LeakGAN只能通过MANAGER和WORKER之间的交互来隐式学习句子结构。

介绍

生成连贯且语义上有意义的文本的能力在许多自然语 言处理应用中起着关键作用,例如机器翻译(Yang et al.2017 ) , 对话生成( Li et al.2017 )和图像字幕(Fang et al.2015))。虽然大多数先前的工作侧重于监督环境中的任务特定应用( Bahdanau , Cho 和Bengio,2014; Vinyals等,2015),但最近的通用无监督文本生成旨在模仿来自语料库的真实文本的分布。 吸引了很多关注(Graves 2013; Yu et al.2017; Zhang et al.2017;

lowast;与魏渭南的通信。这项工作得到了国家自然科学基金委员会(61702327)和上海航海项目(17YF1428200)的资金支持。

胡等人。2017年)。一种典型的方法是训练一个递归神经网络(RNN),以最大化给定先前观察到的单词 的每个地面实况单词的对数似然性(Graves,2013), 然而,由于两者之间的差异,所以它们遭受所谓的暴 露偏差。训练和推理阶段:模型在推理期间基于先前 生成的单词顺序地生成下一个单词,但是训练自己以 生成给定地面真实单词的单词(Husza#39;r 2015)。提出了一种预定的抽样方法(Bengio et al.2015)来解决这个问题, 但事实证明它基本上是不一致的( Husza#39;r 2015 ) 。 生成对抗网( GAN ) ( Goodfellow 等, 2014),首先提出用于连续数据(图像生成等),然 后扩展到离散的顺序数据,以缓解上述问题,并显示 出有希望的结果(Yu等人2017)。由于文本样本的离 散性,文本生成被建模为顺序决策过程,其中状态是 先前生成的单词,动作是下一个要生成的单词,生成 网tt是映射当前的随机策略声明在行动空间上的分布。在完成整个文本生成之后,然后将生成的文本样本馈 送到判别网D,该训练分类器被训练以区分真实和生成的文本样本,以获得用于更新tt的奖励信号。

从那时起,通过GAN在文本生成中提出了各种方法

(Lin等人2017; Rajeswar等人2017; Che等人2017)。尽管如此,报告的结果仅限于生成的文本样本很短(例 如,少于20个单词)的情况,而很难研究更具挑战性 的长文本生成,这对于诸如自动生成新闻文章等实际 任务是必要的。产品说明。现有长文本生成方法的主 要缺点是来自D的二进制引导信号是稀疏的,因为它仅在生成整个文本样本时可用。此外,整个文本的标量 指导信号是非信息性的,因为它不一定保留关于正在 为tt充分学习而生成的文本的中间句法结构和语义的图片。

一方面,为了使引导信号更具信息性,鉴别器D可能提供除最终奖励值之外的更多指导,因为D是训练模 型,例如卷积神经网络(CNN),而不是一个未知的黑匣子。同时这个想法(Zhang et al.2017)提出要训练发电机tt

通过逼迫D的实际和生成文本的学习特征表示来匹配,而不是直接训练tt以最大化来自D的奖励(Yu等人2017)。这种方法在短文本生成中可能是有效的,但在文本结束之前仍然没有引导信号(Zhang et al.2017)。

另一方面,为了减轻引导信号的稀疏性问题,在文本生成中自然会出现层次结构的概念,因为真实文本样本是按照语义结构和词性等某种层次结构生成的( Mauldin 1984)。通过根据层次结构将整个生成任务分解为各种子任务,模型变得更容易学习。早期的努力已经将层次结构理念纳入文本生成(Dethlefs和Cuaya#39;huitl 2010; Peng等人2017),但都使用来自领域知识的预定义子任务集,这使得它们无法适应任意序列生成任务。

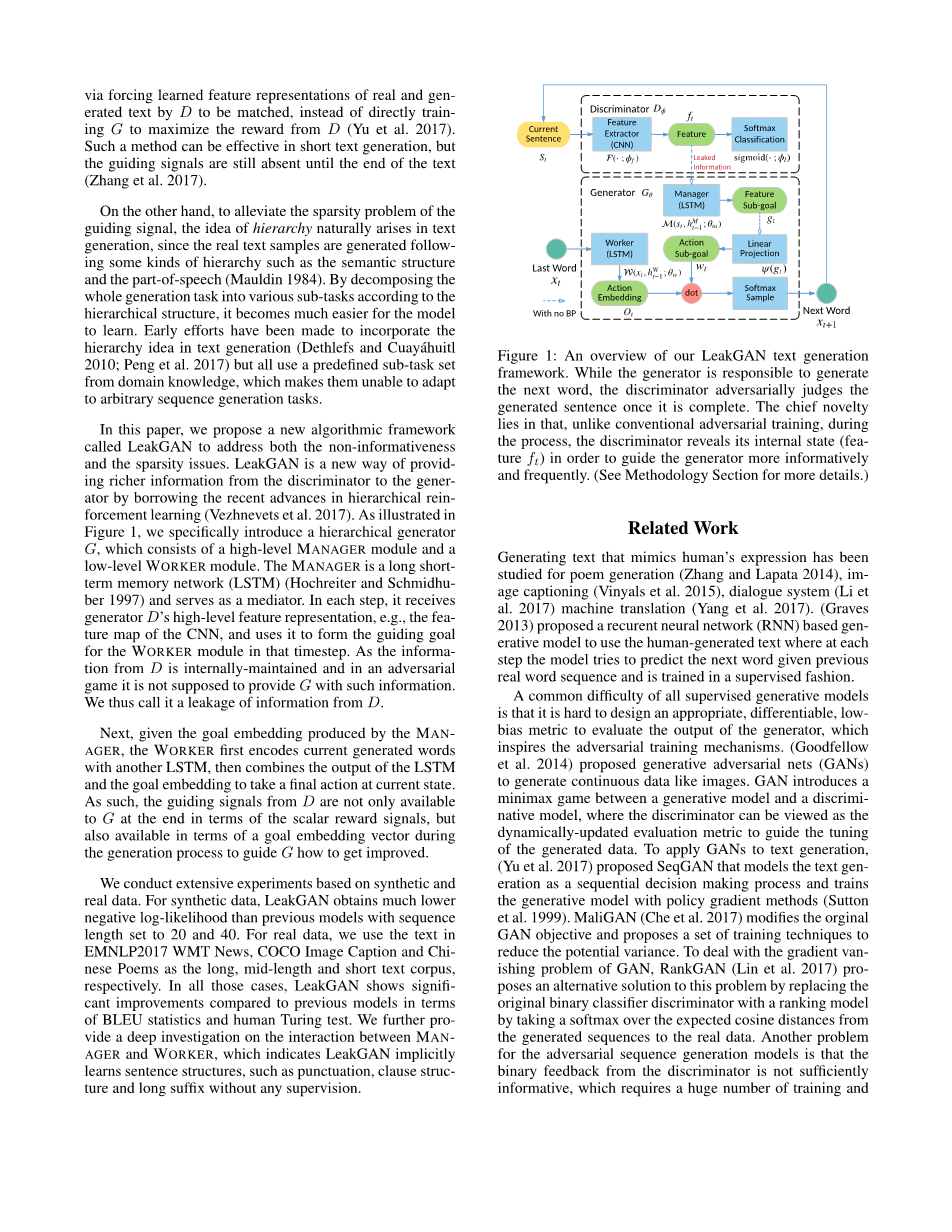

在本文中,我们提出了一个名为LeakGAN的新算法框架,以解决非信息性和稀疏性问题。LeakGAN是一种通过借鉴分层强化学习的最新进展(Vezhnevets等人,2017),从鉴别器向发生器提供更丰富信息的新方法。如图1所示,我们专门介绍了一个分层生成器tt,它由一个高级MANAGER模块和一个低级WORKER模块组成。MANAGER是一个长期短期记忆网络(LSTM)(Hochreiter和Schmidhuber 1997),并担任调解员。在每个步骤中,它接收生成器D的高级特征表示,例如CNN的特征映射,并使用它在该时间步长中形成WORKER模块的引导目标。由于来自D的信息是内部维护的,并且在对抗性游戏中,它不应该提供这样的信息。因此我们称之为D的信息泄漏。

接下来,给定由MANAGER生成的目标嵌入,WORKER首先使用另一个LSTM对当前生成的单词进行编码,然后将LSTM的输出与目标嵌入相结合,以在当前状态下进行最终操作。因此,来自D的引导信号不仅在标量奖励信号方面最终可用,而且在生成过程期间可用于目标嵌入向量以指导如何改进。

我们基于合成和实际数据进行广泛的实验。对于合成数据,LeakGAN获得的负对数似然性比序列长度设置为20和40的先前模型低得多。对于实际数据,我们使用EMNLP2017 WMT新闻,COCO图像标题和中国诗歌中的文本作为长,中长和短文本语料库。在所有这些情况下,LeakGAN在BLEU统计和人体图灵测试方面与之前的模型相比显示出显着的改进。我们进一步深入调查了MANAGER和WORKER之间的相互作用,这表明LeakGAN在没有任何监督的情况下隐式学习了句子结构,如标点符号,子句结构和长后缀。

图1:LeakGAN文本生成框架的概述。当生成器负责生成下一个单词时,鉴别器会在生成的句子完成后对其进行异地判断。主要的新颖之处在于,与传统的对抗性训练不同,在此过程中,鉴别器显示其内部状态(特征ft),以便更有信息和更频繁地指导发生器。(有关详细信息,请参阅方法部分。)

相关工作

生成模仿人类表达的文本已被研究用于诗歌生成(Zhang和Lapata 2014),图像标题(Vinyals等人2015),对话系统(Li等人2017)机器翻译(Yang等人2017)。(Graves 2013)提出了一种基于recurent神经网络(RNN)的生成模型来使用人类生成的文本,其中模型试图在每个步骤预测给定前一个真实单词序列的下一个单词并以受监督的方式进行训练。

所有监督生成模型的一个常见困难是难以设计适当的,可微分的,低偏差的度量来评估生成器的输出,这激发了对抗性训练机制。(Goodfellow等人,2014)提出了生成对抗网(GAN)来生成像图像这样的连续数据。GAN在生成模型和判别模型之间引入了一个minimax游戏,其中可以将鉴别器视为动态更新的评估度量,以指导生成数据的调整。为了将GAN应用于文本生成,(Yu et al.2017)提出了SeqGAN,它将文本生成建模为顺序决策过程,并使用策略梯度方法训练生成模型(Sutton等,1999)。MaliGAN(Che et al.2017)修改了原始GAN目标,并提出了一套减少潜在方差的训练技术。为了解决GAN的梯度消失问题,RankGAN(Lin et al.2017)提出了一种替代方案来解决这个问题,方法是将原始二元分类器鉴别器替换为排序模型,方法是在生成序列的预期余弦距离上采用softmax。真实的数据。对抗序列生成模型的另一个问题是来自鉴别器的二进制反馈信息量不足,这需要大量的培训和

生成样本以改善发生器并可能导致模式崩溃问题。特征匹配(Zhang et al.2017)提供了一种机制,通过核心化的可接受性度量来匹配实际序列和生成序列的潜在特征分布,以减轻弱指导和模式崩溃问题。然而,这种增强仅在生成整个文本样本时发生,因此在训练期间引导信号仍然稀疏。

另一方面,当奖励信号稀疏时,强化学习(RL)也面临类似的困难(Kulkarni等人,2016)。分层RL是处理稀疏奖励问题的有前途的技术之一(Sutton,Precup和Singh 1999)。分层RL中的典型方法是通过为每个子任务定义若干低级子任务和学习微策略来手动识别代理的分层结构,同时学习用于选择要解决的子任务的宏策略。当在给定的特定任务中使用领域知识先验地知道分层结构但是不能灵活地适应其他任务时,这样的方法可以是非常有效的。最近,(Vezhnevets等人,2017)提出了一种用于分层RL的端到端框架,其中子任务不是手动识别,而是由MANAGER模块隐式学习,该模块将当前状态作为输入并输出目标嵌入向量以指导低级WORKER模块。

在这项工作中,我们通过对抗性训练和政策梯度对文本生成过程进行建模(Yu et al.2017)。为了解决长文本生成中的稀疏奖励问题,我们遵循(Vezhnevets等人2017)并为生成器提出层次结构设计,即MANAGER和WORKER。由于我们案例中的奖励函数是判别模型而不是黑盒子(Vezhnevets等人2017),由鉴别器提取的给定当前生成的单词序列的高级特征被发送到MANAGER模块。因此,MANAGER模块也可以被视为间谍,其泄漏来自鉴别器的信息以更好地引导发生器。据我们所知,这是第一项考虑在GAN框架中泄漏信息以获得更好的训练生成器并结合分层RL来解决长文本生成问题的工作。

方法

我们将文本生成问题规范化为顺序决策过程(Bachman and Precup 2015)。具体地,在每个时间步t,代理将先前生成的单词作为其当前状态,表示为st =(x1,...,xi,...,xt)其中xi 表示给定词汇表V中的单词标记。对应于随机策略的theta;参数化生成网tttheta;将st 映射到整个词汇表的分布,即tttheta;(st),其中动作xt 1 ),即选择下一个要选择的单词。我们还训练了一个phi;参数化的判别模型

·|

允许鉴别器Dphi; 提供当前句子的特征ft的附加信息t (它在内部用于Dphi; 本身用于区分)到生成器tttheta;(st)。在LeakGAN中,分级RL架构被用作有效的机制,以将这种泄漏信息ft 有效地结合到tttheta; 的生成过程中(也参见图1)。

D作为指导信号的泄漏特征

·|

与奖励功能是黑盒子的典型无模型RL设置不同,我们的对抗文本生成使用Dphi; 作为学习奖励功能。通常,Dphi; 是神经网络,可以分解为特征提取器(;phi;f )和最终的S形分类层,具有权重

F ·

矢量phi;l。在数学上,给定输入s,我们有

Dphi;(s) = 乙状结肠 (Tl f (s;f ) = sigmoid (l f), (1)

其中phi;=(phi;f ,phi;l)和sigmoid(z)= 1 /(1 eminus;z)。f =(s;phi;f )是最后一层中s的特征向量

F

Dphi;

剩余内容已隐藏,支付完成后下载完整资料

资料编号:[446264],资料为PDF文档或Word文档,PDF文档可免费转换为Word

以上是毕业论文外文翻译,课题毕业论文、任务书、文献综述、开题报告、程序设计、图纸设计等资料可联系客服协助查找。