英语原文共 6 页,剩余内容已隐藏,支付完成后下载完整资料

基于深度强化学习的云无线接入网功率资源分配框架

许志远,王延之,唐健,王静,Mustafa Cenk Gursoy

摘要----云无线接入网络(RAN)已经成为下一代(5G)无线通信的关键支持技术,可以满足大量增长的无线数据流量的需求。然而,云无线接入网络中的资源分配仍需进一步改善,以达到在长时间运行期间最小化功耗和满足无线用户需求的目标。受深度增强学习(DRL)在解决复杂控制问题方面的成功启发,我们提出了一种新的基于DRL的云RAN中功率高效资源分配框架。具体来说,我们定义了状态空间,动作空间和奖励功能,应用深度神经网络(DNN)近似行动价值函数,并正式制定资源分配问题(在每个决策时期)作为凸优化问题。我们通过仿真将它与两个广泛使用的基线进行比较来评估所提议的框架的性能。仿真结果表明,它可以在满足用户需求的同时实现显着的节能,并且能够很好地处理高度动态的情况。

关键词---深度增强学习,资源分配,云无线接入网,绿色通信

一、简述

云无线接入网络(RAN)[5]已成为下一代(5G)无线通信的关键支持技术。与基带处理单元(BBU)和无线电台集于一起的传统RAN不同,云RAN采用独立的BBU和远程无线电设计。所有DSP处理器都被移入云中的中央BBU池分布式射频拉远头(RRH)负责通过前端链路将接收到的无线电信号的无线电信号压缩并转发至BBU。在云无线接入网中,RRH只需要维护一些基本的传输功能,这大大降低了设计和运营成本,使得大规模的高密度网络部署成为可能。并且,这种集中式体系结构可以轻松收集和分析运行时系统的统计数据。

强化学习(RL)[19]已被证明是通信和计算系统资源分配的有效解决方案之一。通过与环境交互的直接奖励反馈,RL代理可以相应地生成(接近)最优控制行动。RL代理并不是简单地以贪婪的方式优化当前的奖励,而是考虑到一个长期目标,这对于时变动态系统(如无线网络和云计算系统)来说基本上非常重要。新兴的深度强化学习(DRL)[15]可以被认为是传统RL的增强版本,它提供了处理复杂控制问题的有前景的技术。DRL技术由离线深度神经网络(DNN)[10]构建阶段组成,该阶段将价值函数与相应的状态和动作相关联,以及用于动作选择、系统控制和动态网络更新的在线动态深度Q学习阶段。在基于DRL的控制框架下,决策是在强大的DNN的指导下进行的,该DNN提供准确的估计和预测,这通常提供整个运行周期的整体良好解决方案[15,18]。另外,DRL可以用来解释状态转换开销(例如,从睡眠/活动转换到活动/睡眠模式的功耗),这些非常重要[24,25],但是被大多数资源分配算法仅为当前时隙(或时间帧)提供最优/次优解决方案。

然而,当应用DRL解决云RAN中的动态资源分配问题时,需要克服一个重要挑战:DRL的在线程序需要通过探索所有可能的行动,在每个决策时期推导出理想的行为,并找到最佳行动 具有从DNN估计的最大(或最小)状态动作Q值,因此动作集要求可枚举。为了减少基于DRL框架中行动空间的大小,我们在每个决策时期创新性地提出了一个两步决策框架:DRL代理首先确定用于开启(或进入睡眠状态)的一组RRH(数字和ID)来限制动作空间大小。随后,DRL代理可以通过求解凸优化问题,基于给定的一组活动的RRH导出最优资源分配解决方案。 通过DRL和优化的组合,可用的操作变得可枚举。

在本文中,我们提出了基于DRL的C-RAN动态资源分配框架,该框架可以在确保满足每个无线用户需求的同时最大限度地降低总功耗。我们的主要贡献总结如下:

bull;我们首次提出了基于DRL的C-RAN动态资源分配框架。

bull;我们为DRL代理定义动作空间、状态空间和奖励函数,形式上制定资源分配问题(在每个决策时期 )作为一个凸优化问题给定一组主动RRH,并应用一个DNN来逼近动作决策的动作值函数,该动作决策直接从当前状态提取信息并避免使用人造的特征。

bull;仿真结果很好地证明了基于DRL的建议框架在功效,用户需求满意度和处理高度动态情况下的有效性。

二、相关工作

C-RAN中的资源分配已在过去几年中进行了研究。在开创性的工作中,Bhaumik等人[4]提出了CloudIQ,这是一种资源分配框架,它(1)将一组基站(BS)划分为在共享同构计算平台上为给定统计保证同时处理的组,(2)调度BS集合分配给一个平台,以满足他们的实时处理需求。已经表明,该框架节省了高达19%的计算资源,可能出现1亿分之一的失败概率。在[20]中,Sundaresan等人提出了另一个资源分配框架FluidNet,以确定满足总流量需求最大化的配置,同时优化BBU池中的计算资源使用。Shi等人[17]提出了一个节能型C-RAN的框架,该框架被制定为RRH联合选择和功率最小化波束赋形问题,并通过稀疏波束赋形方法解决。Dai等人[6]考虑了一个非凸优化问题,最小化受到用户目标速率约束的总网络功耗。他们利用重加权最小化l1和连续凸近似技术来设计可证明的收敛算法。 [13],[16],[21]也研究了类似的问题。不像这些相关作品提出了针对当前时间段(或时间框架)优化特定目标(如功耗)的算法,我们提出了一个基于DRL的框架,该框架对资源分配做出一系列决策,以最大限度地减少整体能源消耗运营期。此外,我们也考虑到了转换能力,这是象征性意义的[24,25],但大多数相关工作忽视了这一点。

DRL最初由DeepMind开发,最近引起了业界和学术界的广泛关注。在一项开创性的工作[15]中,Mnih等人提出了深度Q网络(DQN),它可以直接从高维感官输入中学习成功的策略。这项工作弥合了高维传感输入和行为之间的差距,从而形成了第一个能够学习在各种具有挑战性的游戏任务中表现突出的人造代理。[11]的作者提出了双Q学习作为DQN的具体适应,它被引入到表格设置中,并且可以推广到与大规模函数逼近一起工作。文献[8]考虑了多个智能体在环境中感知和行为的问题,其目的是最大化他们的共享效用,并提出了两种方法:增强的智能体间学习(RIAL)和可区分的智能体间学习(DIAL)。为了进一步将DRL延伸到连续作用域和大离散作用域,Duan等人[7]提出了一套基准控制任务来量化连续控制领域的进展;Lillicrap等人[12]提出了一种基于确定性策略梯度的行为准则,无模式算法,该算法可以在连续动作空间上运行。其他与此主题相关的作品包括[2],[9]。在本文中,我们首次将DRL应用于云RAN中的动态资源分配。

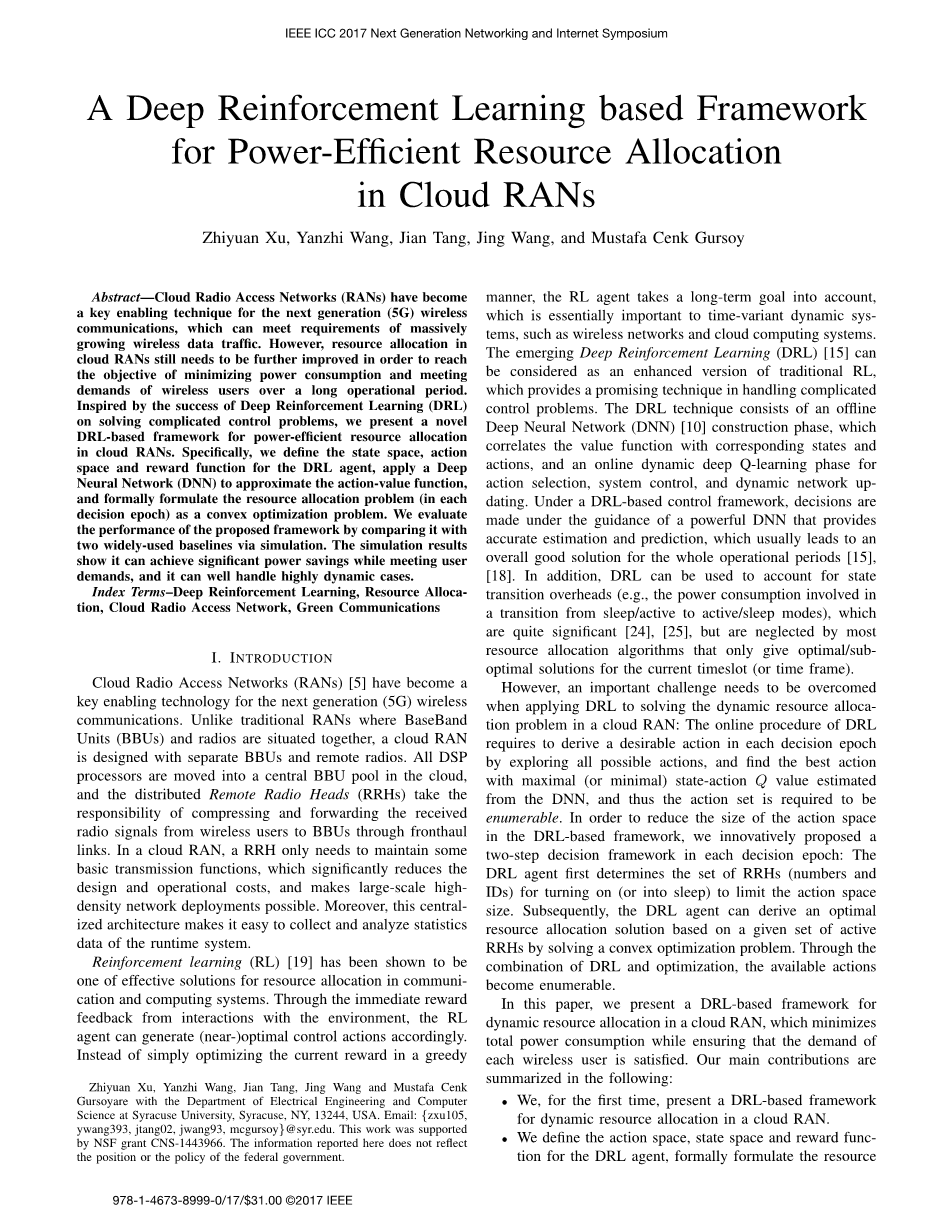

图1 云RAN中基于DRL的动态资源分配

三、系统模型

我们考虑一个典型的云RAN中的单个小区,它由一组含有R个RRH的集合R = {1,2,...,R}和一组U个用户U = {1,2,...,U }。如图1所示,在每个决策历元tk中,网络向DRL代理报告相关用户的需求和所有RRHs的当前状态(活动,睡眠等)。而且,根据最后执行的行动的结果,奖励可以由DRL代理(稍后解释)来计算。在这里,我们假设所有的RRH和用户都配备了一个天线。所提出的解决方案可以很容易地推广到多天线案例,如[6]所示。所有的RRH都连接到云BBU池,RRH的信息可以集中共享,所有用户都可以访问小区内的所有RRH。 DRL代理将基于系统状态sk做出行动决策ak,使某些RRH打开或进入睡眠,并且从每个RRH r向每个用户u分配波束形成权重wr,u。表I中总结了主要标志。

根据天线波束赋形模型[6],用户u的接收机处的相应的信号与干扰加噪声比(SINR)可以给出为:

其中,hu = [h1u, h2u, ..., hRu]T并且每个元素hru是从RRH r到用户u的信道增益;类似的,wu = [w1u, w2u, ..., wRu]T,并且每个元素wru是从RRH r到用户u的波束赋形权重。他们都可以是复数。sigma;2是背景噪声。应用Shannon Hartley定理[22],用户u的可实现的数据率由下式给出:

其中B是信道带宽,Gamma;m是取决于调制方案的SNR间隙。

在蜂窝网络中,如[3]所示,发射功率和BS功耗之间的关系几乎是线性函数,这也适用于RRH。 因此,我们采用每个RRH的经验线性功率建模:

其中Pr,trans是RRH r的发射功率,满足Pr,trans = Sigma;risin;ASigma;uisin;U |wr,u|2。eta;l是一个常数,代表功率放大器的漏极效率。Pr,active表示主用模式下RRH的功耗,这是维持RRH基本操作所必需的。如果未选择RRH进行传输,则进入睡眠模式,此时RRH所消耗的功率为Pr,sleep,Asube;R和Ssube;R分别代表主动和睡眠RRH集合,其中Acup;S= R

除了上述功耗部件之外,我们还考虑了转换功率(从睡眠/活动到活动/睡眠模式)。 设G表示当前历元模式转换中的RRH集合,由DRL代理确定。大多数相关工作忽略了转换功耗。 但是,如[24],[25]所示,这是重要的,因此必须在功率最小化框架中考虑。基于以上分析,当前周期RRH的总功耗可以表示为:

值得一提的是,所提出的基于DRL的框架是灵活的,可以应用于其他网络和功耗模型。由于与模式转换相关的功耗和时间开销,云RAN控制应该在整个运行期间动态优化总预期功耗和累计功耗,而不是优化每个决策时刻的瞬时功耗。优化瞬时功耗仅可能导致在时变用户需求的情况下在附近的决策周期中导致不同的导通RRH集合,从而导致高功率和定时开销。云RAN中的动态资源分配问题在状态空间(用户需求和信道增益)以及复杂的动作空间(活动RRH和波束赋形权值集)中表现出高维度。这两个功能都激励DRL解决这个问题,这将在下一节详细介绍。

表1 主要符号

|

符号 |

描述 |

|

R和r |

RRHs的总数和指数 |

|

R |

RRHs集 |

|

A |

活动的RRHs集 |

|

S |

睡眠的RRHs集 |

|

G |

传输的RRHs集 |

|

U和u |

用户总数和单个用户系数 |

|

U |

用户集 |

|

Pr,sleep |

RRH r在睡眠模式下的功耗 |

|

Pr,active |

RRH r在工作模式下的功耗 |

|

Pr,transition |

RRH r在传输模式下的功耗 |

|

wr,u |

从RRH r到用户u的波束赋形权重 |

|

hr,u |

从RRH r到用户u的信道增益 |

|

tk |

第k个决策单元 |

|

sk |

tk时刻的状态 |

|

ak |

tk时刻的动作 |

|

rk |

tk时刻的奖励 |

四、基于DRL的资源分配框架

在本节中,我们将介绍基于DRL的动态资源分配框架,该框架可以在确保满足每个用户的需求的同时最大限度地降低

全文共12896字,剩余内容已隐藏,支付完成后下载完整资料

资料编号:[12596],资料为PDF文档或Word文档,PDF文档可免费转换为Word

以上是毕业论文外文翻译,课题毕业论文、任务书、文献综述、开题报告、程序设计、图纸设计等资料可联系客服协助查找。