英语原文共 7 页,剩余内容已隐藏,支付完成后下载完整资料

结合语义和几何特征的室内场景对象类分割

摘要场景理解是机器人在复杂环境中自主行动的必要前提。像微软Kinect这样的低成本RGB-D相机为分析室内场景提供了新的方法,现在广泛应用于室内机器人技术中。我们研究了有效的室内场景像素级对象标记策略,该策略结合了从大型彩色图像数据集中传输的预训练语义特征和相对于房间结构计算的几何特征,包括到墙的新距离特征,它编码场景点与检测到的房间主墙的接近程度。我们在流行的纽约大学v2数据集上评估我们的方法。测试了几种深度学习模型,这些模型旨在利用数据的不同特征。这包括两种不同池大小的特性学习。我们的结果表明,结合语义和几何特征可以显著提高对象类分割的效果。

索引术语语义场景:理解、分类、分割。

1.导言

随着服务机器人在家庭和办公室中的应用越来越多,理解复杂场景变得越来越重要。室内场景的密集结构描述对于执行精确的分析至关重要。为了达到这一目的,RGB-D相机的使用变得无处不在,因为它们提供彩色图像和场景的密集深度图。一旦确定了场景中对象的精确位置,诸如“拾取对象”和“计划操作操作操作”[1]-[3]等任务就会简化。一种促进对象定位的方法是对场景进行像素级语义标记[4]。这涉及到基于场景语义的不同对象类的识别和标记。近年来,卷积神经网络(CNNs)在语义标注方面取得了令人瞩目的成果[5],[6]。CNN的体系结构和使用的输入特征是决定场景语义学习质量的重要因素。这项工作解决了这些方面与提出的新颖性,以提高语义标记的准确性。

语义标注的准确性取决于场景模型描述在摄像机姿态、光照条件、物体位置等自然变化下的一致性。对象曲面(如“地板”和“墙”)很容易识别和分割,因为它们通常遵循类似的模式。“小结构”、“家具”和“壁挂”等可移动物体较难识别。这一点也可以通过比较不同方法的单个类标记精度来证明(见表五)。为了缓解这种情况,[7]提出了一种深度规范化方案,其中最远的点被赋予一个相对深度。采用深度规范化方法对分割结果进行了改进,这促使我们进一步探索室内环境的显式建模。

对于室内环境,对象高于地平面的高度强烈指示了相应的对象类。例如,“电视”通常放置在离地平面更高的位置,而不是“床”或“沙发”。[8] 结果表明,该特征改善了对象类分割问题的结果。我们使用[9]的HHA表示,它将深度数据编码为三个通道:地面高度、水平视差和法线与推断重力方向的夹角。这种编码方法在目标检测和标记任务中取得了良好的效果。

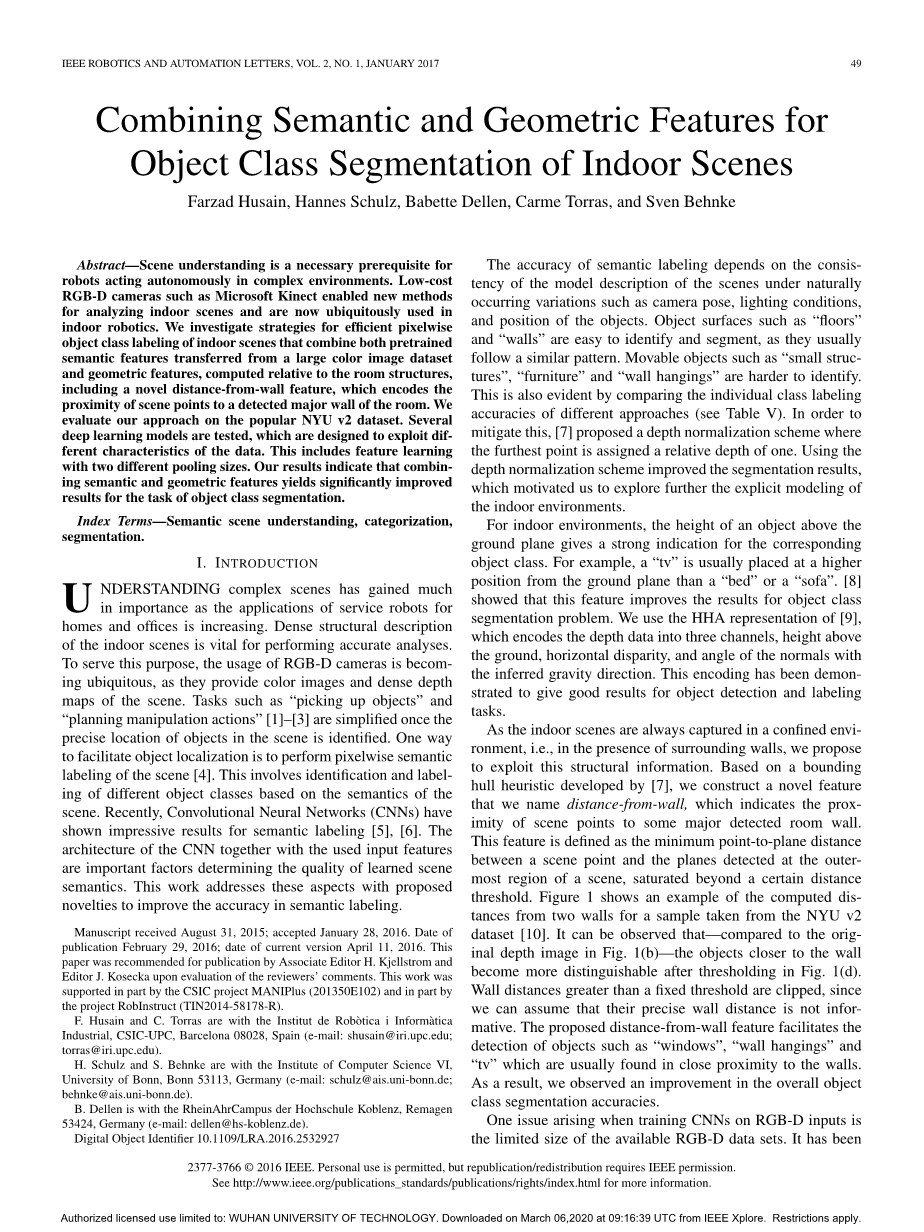

由于室内场景总是在一个封闭的环境中拍摄,即在周围墙壁的存在下,我们建议利用这种结构信息。在文献[7]提出的包围壳启发式算法的基础上,我们构造了一个新的特征,称之为离墙距离(distance from wall),它表示场景点与主要检测房间墙壁的接近程度。该特征被定义为场景点与在场景最外层区域检测到的平面之间的最小点到平面的距离,其饱和程度超过一定的距离阈值。图1显示了从NYUv2数据集采集的样本的计算距离示例[10]。可以观察到,与图1(b)中的原始深度图像相比,在图1(d)中进行阈值化之后,更靠近墙壁的物体变得更容易区分。大于固定阈值的墙距离将被剪裁,因为我们可以假设它们的精确墙距离没有信息。提出的离墙距离特征有助于检测通常靠近墙壁的物体,如“窗户”、“壁挂”和“电视”。结果,我们观察到整体对象类分割精度的提高。

在对神经网络进行RGB-D输入培训时出现的一个问题是可用RGB-D数据集的大小有限。一直以来研究表明,在大数据集上训练分类任务得到的语义CNN特征可以转化为相关任务,如目标检测[11]、[12]、子类别化、域自适应、场景识别[13]、属性检测和实例检索[12]。这种预训练语义特征的转移对于RGB-D对象分类、实例识别和姿态估计[14]以及RGB-D对象类分割任务[5]也很有用。

我们的目标是构建一个稳定的CNN架构,为场景中的每个像素预测一个语义标签。我们使用两组不同的池大小来训练CNN模型,这些池大小与彩色图像端到端、HHA编码[9]和我们提出的离墙距离特征。我们从一个在ImageNet数据集1上训练的CNN模型中传输预先训练的语义特征。通过学习网络的参数,使预测标签与地面真实值之间的像素交叉熵损失最小。我们通过分别评估每个提出的模式,并将其与广泛使用的纽约大学v2数据集上的其他最新方法进行比较,证明了我们的方法的有效性[10]。

这封信的主要贡献是:

bull;提出了一个新的特性,称为离墙的距离,

bull;使用两种不同的池大小的新型CNN架构,产生了改进的结果,以及

bull;与其他最新方法的评估和比较,显示了改进的整体性能。

2.相关工作

传统的语义标注方法分为几个阶段进行[4]、[15]、[19]。这涉及到预处理,将场景分成小块,然后进行特征提取和分类。最终的分类结果取决于在方法的每个阶段获得的结果。另一种方法是以端到端的方式训练深层CNN,即直接从输入像素到语义标签[5]、[8]、[20]。

[4]对图像和点云进行多尺度分割,提取特征向量。利用随机森林(RF)对每种模式的特征向量进行分类,并利用条件随机场(CRF)对分类结果进行融合和进一步细化,以增强空间一致性。手工制作的特征,如“面积”、“直径”和“方向”被用来识别不同的特征。然而,从组合的原始数据和手工制作的特征中学习特征往往会产生更好的结果,因为它同时利用了隐藏的线索和人类知识。[19] 是这样一种方法的一个例子,其中作者将地上高度特征与逐像素RF分类结合起来[21],并基于手动设计的特征学习超级像素之间的二元势。

[22]和[17]呈现一个场景,然后构建一个利用它们的语义关系的模型。[22]使用基于CRF的模型将逐像素和成对的观察与用于分层语义标记的标签相关联。[17]使用随机决策树进行语义分割,并使用密集的CRF进一步细化结果。类似地,文[18]提出了分割和随机森林分类来初始化CRF的一元电位。

[8]训练一个深CNN使用图像补丁作为网络的输入,其中补丁大小根据测量的补丁中心的深度进行调整。这增加了尺度不变性,并导致改进的对象类分割结果。

为了提高深CNNs的尺度不变性,[20]和[5]使用了多尺度输入。应用于深度信道的定向梯度(HOG)描述符直方图的简化版本向CNN提供了深度信息。

为了提高语义分割的空间精度,[5],[6]提出了两种不同的CNN模型。[5] 将CNN分为三个子网,从粗到细逐步预测输出。网络由ImageNettrained AlexNet初始化[24]。此外,通过调整损失函数,优化了松散相关的计算机视觉任务(估计深度和曲面法线)。[6]将中间层的上采样预测与最终层的上采样预测相结合,从而得到更精确的结果。一个单一的图像分类网络适应于一个完全卷积的网络,并对语义分割进行微调。

另一个研究方向是利用RGB-D视频序列的时间积分。例如,[25]执行RGB-D SLAM来估计摄像机的运动,并在3D中从多个视图聚合语义分割。[26]直接训练层次递归卷积神经网络对RGB-D视频中的对象类进行分割。在这项工作中,我们不处理时间集成,只处理单个RGB-D帧。

3.问题公式

给定一幅彩色图像和一幅场景的稠密深度图X,我们的目标是获得对应于像素位置处的对象类的每个像素位置xpisin;X的标签circ;ypisin;。在我们的任务中,我们处理自然的室内场景,这些场景通常与物体的大小和数量不平衡。例如,属于floor类的像素数远远大于家具类的像素数。因此,我们使用加权的多类交叉熵损失函数[5]:

Ci,是位置i的预测类分布,ci,·是各自的地面真值类分布。因子alpha;根据在训练集中出现的频率对每个类进行加权,而中值频率(C)是所有类频率的中值。

4.方法

我们分两个阶段使用卷积神经网络,如图所示2和3在第一阶段中,我们使用两组不同的池运算符大小来训练网络。在第二阶段,我们将前一阶段的两个网络的最后一层的特征映射连接起来,然后再次训练网络。这两个阶段的方法产生精确的结果。最后,我们从距离墙特征(秒)的角度,利用几何墙邻近信息来丰富连接特征集。IV-B段)。

A、网络体系结构

我们的网络需要三个输入,即彩色图像、HHA编码和距离墙特征。彩色图像通过五个卷积层的叠加。HHA编码和距离墙特征分别由四层和三层卷积层处理。该网络由纽约大学CILVR实验室设计,并在ImageNet数据集上训练,用于彩色图像分类。在训练过程中,这两层的权重保持不变,作为语义特征提取器。该网络还包含池层,一个退出层,并分为四个配置,如表一所述。我们在第一个卷积层之后训练具有两个不同池大小的网络。因此,配置A中的最终特性映射大小要么是池大小的4倍,要么是池大小的8倍。这同样适用于配置B。配置A和B不需要培训,因为过滤器是从OverFeat网络传输的。

配置C仅包含“与墙的距离”功能。配置A、B和C的输出被连接起来并反馈到配置D,我们使用标记的训练示例对配置D进行训练。

这些网络是为两组不同的池大小而训练的。在上采样之前,如图3所示,将来自配置D的最终输出串联起来并再次训练。学习了一个滤波器个数等于对象类个数且大小为(3times;3)的卷积层。通过将不同池大小的网络连接起来,在保留空间位置信息的同时,利用了对局部变形的不变性,提高了分割精度。

B、离墙距离

我们设计了一个简单而健壮的启发式方法来检测室内场景最外面区域的墙。这涉及到分割点云并拾取位于最外边界区域内的那些线段。然后,选择两个最大的线段,并使用平面模型计算每个点到这些平面的距离。这些步骤如图4所示,并在下面详细说明。

1)分割点云:我们使用两种不同的方法将点云分割为曲面段。第一种方法使用RANSAC将平面拟合到点云(见图4(c))。第二种方法基于二次曲面拟合对3D点进行分段,如[28]所述(见图4(d))。我们使用这两种不同的方法,因为根据场景的复杂性,一种方法比另一种方法表现得更好。[28]提出的方法在包含大部分非平面表面的复杂场景中表现得更好,而RANSAC在由平面表面控制的场景中表现得更好。

2) 检测最外边界:为了检测最外边界,我们使用了[7]中描述的技术,即,如果一个点的深度在图像网格每列中最大深度的4%以内,则将其标记为边界区域。图4(a)示出了用蓝色着色的边界区域。我们只将位于最外边界的线段作为墙的候选对象,如图所示。4(e)和(f)。

3)从顶部查看时,选择最大的两段:要生成近似的俯视图,我们假设垂直摄影机轴始终指向向上方向。我们从分段的点云中选择最多两个线段,从顶部看,这两个线段具有最大的三角形宽度且不共面。然后我们选择具有最大宽度和的段。因此,在无花果中。4(g)和(h),选择图4(g)中的两个段。

4)计算与墙的距离特征:一旦选择了这两个线段,我们使用平面曲面方程计算所有场景点的最小点到平面的距离。因为在每个场景中,我们最多有两个平面,每个平面产生一个点-平面距离值(见图。4(i)和(j)),我们取最小值,得到离墙的最终距离(见图4(k))。

其中pi;1 x和pi;2 x分别是点x到平面pi;1和pi;2的点到平面距离。我们使用一米的阈值。如图4(l)所示,对值超过阈值的所有点进行剪裁。这个特定值背后的理由是,距离墙壁1米范围内的物体的深度读数可能略有不同,但与墙壁本身明显不同,例如“灯”、“壁挂”和“橱柜”。应用此阈值后,这些对象将从场景的其余部分亮显。距离一米远的物体通常不会出现在离墙的特定距离内,因此特征变得毫无意义。

五、实验

在本节中,我们将描述纽约大学v2数据集的评估结果。我们在一秒内使用四个对象类[10]Sec.V-A和13个对象类[29]Sec.V-B型。

该数据集共包含1449个不同室内场景的样本。我们使用数据集作者提供的训练/测试分割。梯度下降的参数,即学习率、动量和迭代次数,通过首先分离10%的训练实例并加以验证来调整。

为了深入了解我们提出的模型的优点,我们分别评估了不同的方面。这包括来自第一阶段的网络(称为net-ABCD)和不具有“与墙的距离”功能的网络(称为net-ABD),来自第二阶段的网络(称为net-ABCD combined)以及不具有“与墙的距离”功能的网络(称为net-ABD combined)。我们将第一阶段中不同池大小的成对采样因子区分为U4和U8。

我们使用Silberman和Fergus[10]定义的四个类来展示NYU v2数据集的结果。表二显示了四个类别中每一个类别的单个标签精度的比较。在结构类(81.9%vs.81.6%和79.9%)和家具类(72.8%vs.66.6%和72.0%)两个网络组合后,我们得到了更好的结果。表三和表五是根据与表二和表四相对应的准确度的增加程度排列的。与net-ABCD-U4和net-ABCD-U8相比,net-ABCD组合显示了改进的总体结果。我们的结果与级联多尺度CNNs方法具有竞争力[5]。然而,由于不同的网络层叠,后一种模型需要两步训练。此外,与我们的单尺度模型相比,[5]中的多尺度特征学习方法似乎是有益的。

图5显示了从纽约大学v2数据集的测试集中选择的示例。文中给出了有壁面距离和无壁面距离的计算结果。可以观察到,家具(棕色)和道具(粉色)类的分割效果更好。例如,在图5(2c)中,可以看出“tv”在与墙壁特征的距离上容易区分,并且当使用该特征时,它更好地分割(参见图5(2d)和(2e))。

我们给出了纽约大学v2数据集的结果,使用了Couprie等人定义的13个类。[29]。表V显示了13个类别中每个类别的单个标签精度的比较。可以观察到,我们的方法对于通常更靠近墙壁的较小对象类别(如“图片”、“电视”和“窗口”)表现得更好。表IV显示了与表V中的结果相对应的平均类精度和平均像素精度的比较。可以观察到类似的行为,如四个类的情况,即与net-ABCD-U4和net-ABCD-U8相比,结合net-ABCD的结果更好。

六、结论

提出了一种基于深度学习的语义对象类分割模型。

剩余内容已隐藏,支付完成后下载完整资料

资料编号:[239786],资料为PDF文档或Word文档,PDF文档可免费转换为Word

以上是毕业论文外文翻译,课题毕业论文、任务书、文献综述、开题报告、程序设计、图纸设计等资料可联系客服协助查找。