英语原文共 13 页,剩余内容已隐藏,支付完成后下载完整资料

在线和手写汉字识别:全面的研究和新的基准

Xu-Yao Zhang a,n, Yoshua Bengio b, Cheng-Lin Liu a,c

摘要:最近的基于深度学习的方法通过直接从原始数据中学习歧视性表示,实现了手写汉字识别(HCCR)的最新性能。尽管如此,我们认为经过长期和深入研究的领域特定知识仍应有助于提高HCCR的性能。通过将传统的归一化协作方向分解特征映射(directMap)与深度卷积神经网络(convNet)相结合,我们能够在ICDAR-2013竞争数据库中获得线上和线上HCCR的最高精度。借助这个新框架,我们可以消除数据增强和模型集成的需求,这些需求在其他系统中得到广泛应用,以实现最佳效果。这使我们的框架在培训和测试方面效率和效率都很高。此外,虽然directMap convNet可以取得最佳效果并超越人类表现,但我们表明在这种情况下书写者适应仍然有效。提出了一种新的适应层来减少特定源层上的训练和测试数据之间的不匹配。适应过程可以有效和有效地以无监督的方式实施。通过在预训练的convNet中增加适应层,它可以适应特定书写者的新手写风格,并且识别准确性可以进一步持续和显着提高。本文概述和比较了近期基于深度学习的HCCR方法,并为在线HCCR和流动HCCR设定了新的基准。

关键字:手写识别 汉字 在线 离线 方向特征图 卷积神经网络 自适应

- 绪论

手写汉字识别(HCCR)已经进行了五十多年的研究[1,2],以应对大量字符类别,相似字符之间的混淆以及不同个人手写风格的挑战。根据输入数据的类型,手写识别可以分为在线和离线。在线HCCR中,笔尖运动的轨迹被记录和分析以识别表达的语言信息[3],而在HCCR中,分析字符(灰度或二值)图像并将其分为不同的类别。目前,HCCR已经发现了许多应用,例如邮件分拣[4],银行支票阅读,书本和手写笔记转录,而在线HCCR已经被广泛用于笔输入设备,个人数字助理,智能手机,计算机辅助教育等等上。此外,HCCR也是手写文本识别(线上[5]和文件[6])的重要组成部分,它同时考虑了分割和识别。高的字符识别精度对手写文本/字符串识别的成功至关重要[7]。

为促进HCCR的学术研究和基准测试,中国科学院自动化研究所(CASIA)国家模式识别国家实验室(NLPR)在CCPR-2010 [8],ICDAR-2011 [9],和ICDAR-2013 [10]。比赛结果显示随着时间的推移而改进,并涉及许多不同的识别方法。基于深度学习的方法逐渐在竞争中占主导地位。从一开始,CCPR-2010提交的所有系统都是传统方法。在ICDAR-2011中,来自瑞士的IDSIA团队基于卷积神经网络(convNet)提交了他们的系统[11],并赢得了HCCR的第一名。这是使用convNet进行HCCR的第一个工作。后来在ICDAR-2013上,线上和线下HCCR的获奖者都在使用convNets。富士通研发中心的团队使用4-convNet投票方式赢得了离线别的竞争,而来自华威大学的团队使用稀疏的convNet [12]赢得了在线认证的竞争。

深度学习方法可以直接从原始数据中学习歧视性重现[13],因此可以为许多模式识别问题提供端到端的解决方案。然而,经过充分研究的领域特定知识对于进一步提高HCCR的性能仍然有帮助[14,15]。 HCCR最重要的领域知识包括字符形状归一化和方向分解特征映射。字符识别团体已经提出了许多有用的形状归一化方法,如非线性归一化[16],双时刻归一化[17],伪二维正规化和线密度投影插值[18]。形状规范化可以减少类内的变化,从而提高识别的准确性[19]。另一个重要的领域知识是方向分解特征映射。通过将不同方向(从0°到360°)分解为梯度(对于图像图像)或局部中风(对于在线行程轨迹),我们可以获得多个特征图,每个特征图代表原始梯度/行程。这是对写作过程中由基本方向笔画产生的汉字的强大的先验知识。在convNet到来之前,将汉字表示为方向特征一直是最先进的方法[19-21]。

为了提高HCCR的准确性,我们不是从原始数据训练convNet,而是使用归一化合作的[22]方向分解特征映射(directMap)来表示在线和手写的字符,它们可以被看作是adtimes;ntimes;n稀疏张量(d是量化方向的数量,n是映射的大小)。 DirectMap包含形状标准化和方向分解的特定主要知识,因此是HCCR的强大代表。此外,受最近使用非常深的convNet进行图像分类的成功启发[23-25],我们为HCCR开发了一个11层convNet。通过将directMap与convNet相结合,我们能够在ICDAR-2013竞争数据库中获得在线和流畅HCCR的新基准[10]。以前的作品通常采用不同的方法来分别获得在线和流畅HCCR的最佳性能。但是,通过直接Mapthorn;convNet,我们能够在同一框架下为在线HCCI和流动HCCR提供最先进的性能。由于嵌入领域特定的知识,我们也可以消除数据增强和模型集成的需求,这对其他系统实现最佳性能至关重要。这使我们的模型在培训和测试过程中都能够高效。

个人手写风格的巨大差异是HCCR的另一个挑战。作家适应[26,27]被广泛用于通过逐渐减少不依赖写作者的系统和特定个人之间的不匹配来应对这一挑战。尽管基于深度学习的方法已经创造了超过人类表现的HCCR的高纪录,但我们表明在这种情况下作家适应仍然有效。受到我们早期关于样式转换映射[28]的启发,我们在convNet中添加了一个特殊的适应层,以无监督的方式匹配和消除训练和测试数据之间的分布转换。由于学习过程中涉及正规化,适应性可以保证性能提高,即使只有少量样本可用。在我们针对60名在线HCCR和流行HCCR的作者进行的实验中,我们观察到convNet的适应性显着提高了准确性。

手写识别社区已经报告了以前的[3,29-33]综述文章中许多有用和重要的成果(从1980年到2008年)。如今,基于深度学习的方法成为解决手写相关问题的新型尖端技术。本文可以看作是对近期的研究进展(特别是通过三次竞赛[8-10])对使用深度学习方法进行手写汉字识别(HCCR)的任务。这里报告的结果和比较可以作为未来在线和流动HCCR领域研究的新基准。

本文的其余部分安排如下。第2部分回顾相关的作品。第3节介绍了生成在线和直接地图的程序。第4节展示了从传统方法到convNet的演变。第5节介绍了我们系统中使用的convNet的细节。第6节介绍了如何在convNet中添加一个适配层以便作者适应。第7部分报告实验结果,第8部分总结评论。

- 相关工作

随着深度学习的成功[34,35]在不同领域的影响,HCCR的解决方案已经从传统方法变为卷积神经网络(convNet)[36]。第一次报告成功使用convNet作为HCCR(流体)的是多柱深层神经网络(MCDNN)[37,38]。之后,在ICDAR-2013竞赛中,使用稀疏convNet [39]来实现在线HCCR的最佳性能。 [40]提出了经过训练的松弛卷积神经网络用于HCCR。最近,[41]通过整合多种策略(如局部和全局扭曲,多监督训练和多模式投票)实现了最高精确度的HCCR。 ConvNet也被成功地用于手写的Hangul识别[42],这与HCCR类似。虽然这些方法在传统方法上大幅度优于传统方法,但它们是基于端到端学习,忽略了HCCR中经过长期和深入研究的领域特定知识。

最近,[15]将传统的特征提取方法(如Gabor和梯度特征映射)与GoGelNet [24]相结合,以获得非常高的HCCR精度。此外,对于在线HCCR,[14]和[43]通过使用具有各种领域知识的convNet,包括变形,想象笔画图,路径签名图和方向图,实现了最佳性能。这些结果清楚地表明了使用领域知识进一步提高性能的优势。应该指出的是,在大多数图像分类任务的深度学习中,为了增加训练数据而产生的扭曲图像也是一种领域知识的利用。然而,在我们的想法中,最重要的领域特定知识应该是形状归一化和方向分解。利用我们提出的directMap CONVNet,无需数据增强或模型集成的帮助,我们就可以实现在线和无线HCCR的新基准,这对于[15,43]获得最佳结果至关重要。

基于深度学习的方法在其他笔迹相关问题中也有应用,如书写器识别[44],混合模型[45],置信度分析[46],手写法律数量识别[47]和文本识别[48]。 ConNet也可以与隐马尔可夫模型(HMM)结合用于在线手写识别[49]。最近,具有长期短期记忆(LSTM)[50]的递归神经网络(RNN)已经成功地用于手写中文文本识别而没有明确的字符分割[51]。 RNN和convNet的组合也被[52,53]用于场景文本阅读。很明显,越来越多的字符识别相关问题会将注意力转向高性能解决方案的深度学习方法。

作家适应已被广泛用于个性化手写识别系统[26,27]。我们以前的工作[28]提出了一种适用于不同分类器的样式转换映射(STM)框架,[54-56]对此进行了进一步研究。以前的作者适应主要集中在传统的分类器上,如最近的原型分类器[57]和修正的二次判别函数[1]。然而,作者对深度转网络的适应尚不清楚。传统的深层网络适应方法[58]是重新训练一个分类层,将现有网络中的一个激活为输入特征(如DeCAF [59])。当标注数据不可用于目标域时,子空间对齐(em-bedding)[58]被广泛用于最小化域偏移。在这项工作中,通过将STM看作一个新的特殊层,我们可以用一个无监督的方式将conNet适应新型的特定作者,只需少量的作者特定的数据。所提出的适应层是神经网络的一个简单和基本的组成部分,因此可以很容易地与不同的网络架构集成。

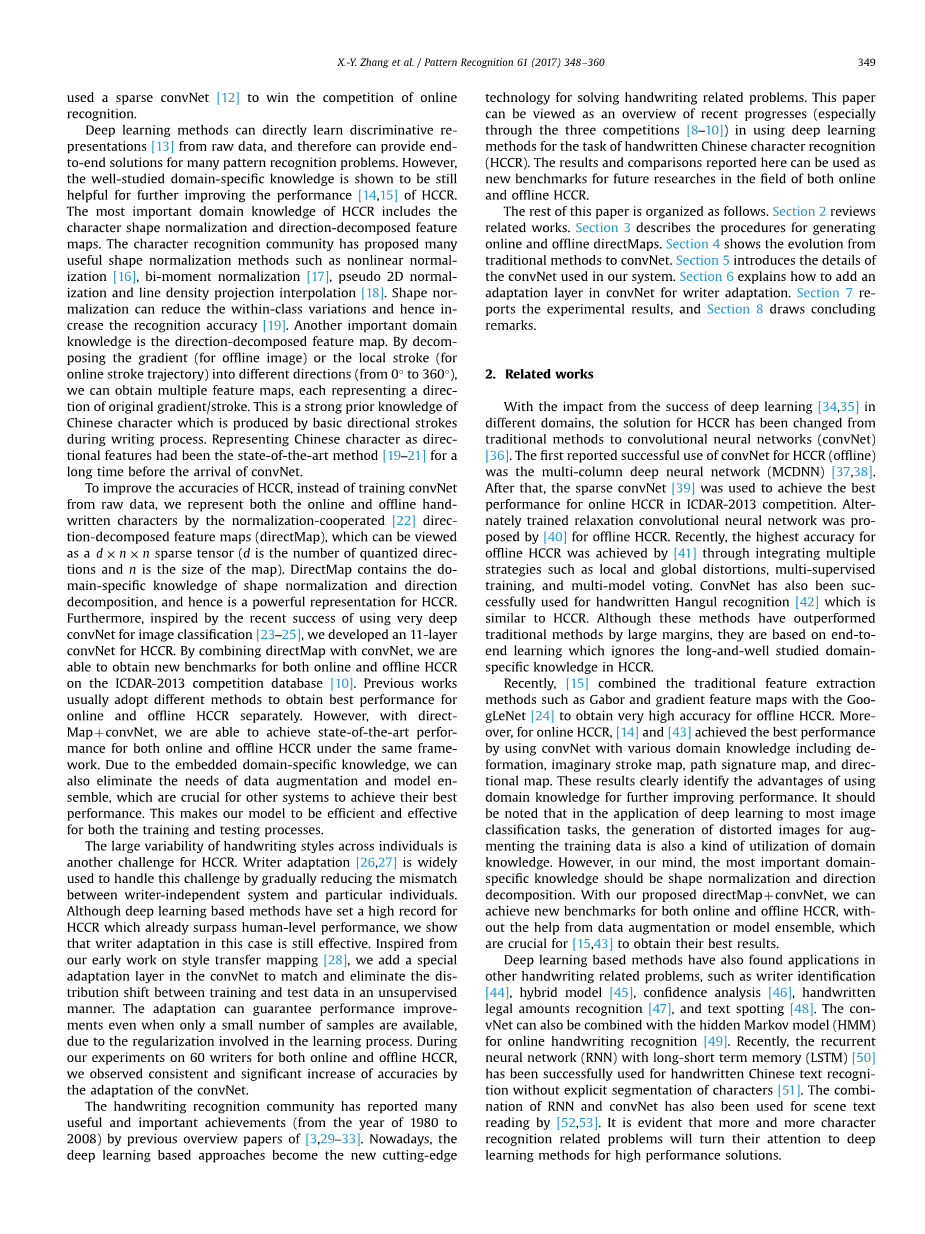

图1.在线和手写汉字的directMaps。

- 方向分解特征图

形状归一化和方向分解是HCCR中强大的领域知识。 形状规范化可以被看作原始和规范化字符之间的连续2D空间中的坐标映射。 因此,方向分解可以在原始(归一化合作)或归一化(基于归一化)字符上实现[22]。 规范化协作方法将原始字符的方向元素映射为方向图而不产生正规化字符,从而可以减轻由形状归一化引起的中风方向畸变的影响,并提供更高的识别准确度[22]。 我们使用归一化合作方法为线上和线下HCCR生成directMaps [19]。

-

- 离线directMap

离线HCCR数据集提供灰度图像,背景像素标记为255.为了快速计算,我们首先反转灰度级:背景为0,前景为[1,255]。之后,将前景灰度级非线性地归一化为特定范围,以克服不同图像之间的灰度变化[19]。由于其优良的性能,我们选择线密度投影插值(LDPI)方法[18]。对于方向分解,我们首先通过Sobel算子从原始图像计算梯度,然后通过平行四边形规则将梯度方向分解为两个相邻的标准链码方向[60]。请注意,在此过程中,不会生成标准化字符图像,而是将原始图像的梯度元素直接映射到包含像素坐标变换的标准图像大小(例如64times;64或32times;32)的定向图。

-

- 在线directMap

在线HCCR数据集提供了笔画的坐标序列。 我们还对在线手写字符使用归一化协作方法,即,从包含坐标变换的原始模式中提取特征而不生成归一化模式。 由于LDPI不适用于在线轨迹,因此用于在线HCCR的形状归一化方法是伪2D二阶矩标准化(P2DBMN)[61]。 对于方向分解,将(由两个相邻点形成的线段的)局部行程方向分解为8个方向,然后生成每个方向的特征映射[61,21]。 想象的笔画(笔提升或被称为off-stroke)[62]也加上0.5的权重以获得加强的表现。

-

- 总结

为了构建紧凑的表示,我们将特征映射的大小设置为32,因此生成的directMap是8times;32times;32张量。图1显示了在线和直接映射的示例。第一列是原始字符,而以0-7索引的列是八个方向图。为了更好地说明,我们还显示了八个定向地图的平均地图。结果表明,平均图中的形状与原始字符相比是正常化的。对于不稳定的特征,对梯度进行分解,因此平均地图给出了原始图像的轮廓信息。相反,对于在线人物,局部笔画被分解,因此输入字符可以通过平均地图很好地重建,从中我们还可以发现虚拟笔画已经被考虑。因为梯度垂直于局部中风,所以在线和直接地图都是不同的,尽管它们采用了与图1右侧相同的方向编码。

DirectMap是HCCR的一个强大代表,它利用了强大的先验知识,即汉字在写作过程中由基本的定向笔画产生。如图1所示,directMap非常稀疏。实际上,在我们的实验数据库中,directMap中元素的92.41%(在线)和79.01%(元素)是零。有了这个稀疏性,我们可以有效地存储和重用提取的directMaps。由于稀疏性,使用尺寸小于原始图像(大于64times;64)的地图不会丢失形状信息。

- 从传统的HCCR到convNet

在获得directMap后,传统的HCCR方法[19]在每张地图上采用取样策略。如图2所示,在每个采样位置,高斯模糊[19]用于减少行程位置变化的影响。通常情况下,每个地图都会定期采样8times;8个点,从而产生一个维度为512(8个方向)的特征向量,这被广泛称为方向特征。之后,Box-Cox转化[63]将y = x0.5应用于每个特征维度以增加数据的高斯性。然后使用主成分分析(PCA),Fisher判别分析(FDA)[64]和判别特征提取(DFE)[65]等线性降维方法将特征减少到低维子空间(例如160) 。在这个子空间中,最近的原型分类器(NPC)[57],修正的二次判别函数(MQDF)[1]和区分性学习二次方差分函数(DLQDF)[66]被广泛用作最终的分类器(

全文共32385字,剩余内容已隐藏,支付完成后下载完整资料

资料编号:[10750],资料为PDF文档或Word文档,PDF文档可免费转换为Word