英语原文共 7 页,剩余内容已隐藏,支付完成后下载完整资料

用于图像字幕生成的基于文本引导的视觉注意模型

Jonghwan Mun,Minsu Cho,Bohyung Han

韩国POSTECH计算机科学与工程系

摘要:视觉注意在理解图像和证明其在生成描述图像的自然语言的有效性方面扮演着重要的角色。另一方面,最近的研究表明,与图像相关的语言可以在我们的认知过程中引导场景中的视觉注意力。受此启发,我们引入了一个用于生成图像字幕的基于文本引导的视觉注意模型,能够学习使用相关字幕来吸引视觉注意力。对于该模型,我们提出了一种基于样本的学习方法,该方法从与每个图像相关联的字幕的训练数据中检索,并使用它们来学习对视觉特征的关注。我们在MSCOCO Captioning(一个计算机视觉权威赛事)基准测试中验证了我们的模型,并在标准指标中实现了最先进的性能。

引言

图像字幕旨在自动生成图像的自然语言描述,是场景理解中的主要问题之一。长久以来,这个问题一直被视为一项极具挑战性的任务,因为它需要从低级到高级方面捕捉并表达图像局部和全局区域内包含的各种场景元素及其之间的关系。

尽管存在这些挑战,但该问题已引起广泛关注,并且由于深度神经网络的不断发展以及大规模数据集的构建,在过去几年中已经实现了显着的改进。例如,编码器 - 解码器框架(Kiros,Salakhutdinov,和Zemel 2015; 毛等人。2015B; Vinyals等。 2015年;吴等人。 2016),使用端到端训练的深度神经网络来替代传统的单任务管道(例如检测对象和活动,排序单词等)方法来制定图像字幕问题。

最近,一个主要的进步方法是通过将一种形式的视觉注意力结合到图像编码器中来实现图像字幕(Xu等人2015; You等人2016)。注意模型不是将整个图像压缩成平面表示,而是允许编码器仅关注与图像字幕相关的特征。这有助于描述感兴趣区域中的精细细节,即使是在杂乱的图像也能做到这种精度。

另一方面,最近的心理学研究揭示了语言与视觉注意之间的密切关系(Mishra 2015)。表达对象和事件的口语或文本语言引导人们构建关于它们的心理表征。这种表现有助于预测人的眼球运动,从而成功监测物体和行为(Lupyan和Spivey,2010)。这表明与场景相关联的口语或文本语言可以为场景中的视觉注意提供有用的信息。

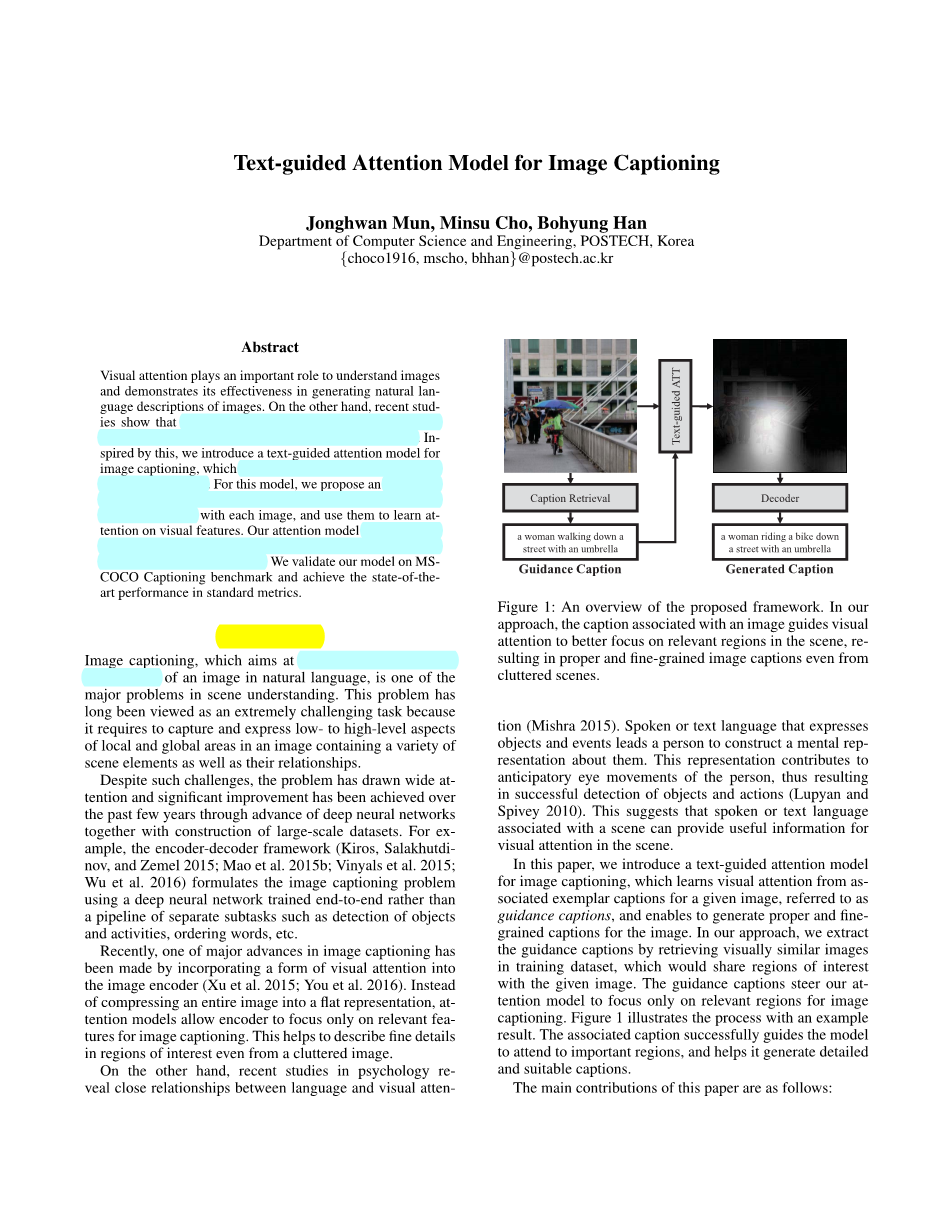

在本文中,我们引入了一个用于图像字幕的基于文本引导的注意模型,该模型从给定图像的相关示例字幕学习视觉注意,称为引导字幕,并且能够为图像生成适当且细粒度的字幕。在我们的方法中,我们通过在训练数据集中检索视觉上相似的图像来提取引导字幕,该图像将与给定图像共享感兴趣的区域。引导标题引导我们的注意力模型仅关注与图像字幕相关的区域。图1以一个示例的结果来说明了该过程。相关标题成功指导模型参与重要区域,并帮助其生成详细和合适的字幕。

图1:计划框架概述。在我们的方法中,与图像相关联的标题来引导视觉注意力更好地聚焦在场景中的相关区域,从而使得即使在杂乱的场景中也能产生合适且细粒度的图像字幕。

本文的主要贡献如下:

- 我们引入了一种新的用于图像字幕生成的注意力模型,它直接利用训练数据中的示例字幕作为视觉注意的指导源。这种基于范例的注意力模型是在我们的图像字幕体系结构中以端到端的方式学习的。

- 我们开发了一个基于抽样的方案,通过使用多个范例指导字幕来学习注意力。 这避免了训练中的过度拟合,并减轻了从杂乱的指导字幕中学习到误导性注意力的问题。

- 我们的具备指导注意力模型的图像字幕自动生成网络在MS-COCO字幕基准上实现了最先进的性能(Lin et al.2014),优于最近所有的基于注意力的方法。

本文的其余部分安排如下。 我们首先回顾相关工作并概述我们的架构。 然后,详细描述了我们方法的每个组成部分,并讨论了训练和推理过程。 最后,我们提出实验结果,并将我们的算法与现有算法进行比较。

相关工作

我们在图像字幕和视觉注意的背景下简要回顾现有的算法。

图像字幕生成

最近用于图像字幕自动生成的大多数方法基于编码器 - 解码器框架(Kiros,Salakhutdinov和Zemel 2015; Mao等人2015b; Vinyals等人2015; Wu等人2016)。该方法使用CNN对图像进行编码,并使用RNN将编码的表示变换为字幕。 (Vinyals等人,2015)介绍了一种基本的编码器 - 解码器模型,该模型使用GoogLeNet(Szegedy等人2015)提取图像特征,并将该特征作为第一个字馈入长短期记忆(LSTM)解码器。 (Mao等人,2015b)提出了一种将RNN的图像特征和隐藏状态转换为中间嵌入空间的技术,而不是将图像特征馈入RNN。基于每个时间步的嵌入特征的聚合来预测每个单词。另一方面,学习图像属性,并且将属性的存在而不是编码图像特征给予LSTM作为生成字幕的输入(Wu等人,2016)。 在(Kiros,Salakhutdinov和Zemel 2015)中,学习图像和字幕之间的多模态空间,并且将嵌入的图像特征作为视觉信息馈送到语言模型。

注意力模型

受人类感知过程的启发,当前已经针对各种任务场景开发出了多种注意机制,如物体识别(Ba,Mnih和Kavukcuoglu 2015; Kantorov等2016),图像生成(Gregor等人2015),语义 细分(Hong et al.2016)和视觉问答(Andreas等人2016; Noh和Han 2016; Xu和Saenko 2016; Yang等人2016)。在图像字幕自动生成中,有两种形式的采用视觉注意的代表性方法。在(You et al。2015)的每个时间步骤中使用LSTM的隐藏状态估计单词的空间注意力,而(You et al。2016)中的算法计算对字幕候选单词的语义关注,使用它来细化每一步的LSTM输入和输出。虽然这些方法证明了视觉注意在图像字幕中的有效性,但它们并未考虑更直接地使用训练数据中可用的字幕。我们的方法通过学习经历了推理的字幕,将它们作为视觉注意的高级指导。据我们所知,上面所提出的方法是图像字幕生成的第一项工作,它将视觉注意力与相关文本语言的指导相结合。

概述

对于一对图像I和由单词T(w1; w2; :::; wT)组成的字幕c,使用注意模型的常规图像字幕方法(Xu等人2015)最小化训练中的负对数似然如下:

公式中,fatt是注意力模型,ht-1是前者隐藏的LSTM状态。注意,我们在方程(1)中使用另外两个单词:w0(lt;BOSgt;)和wT 1(lt;EOSgt;)分别表示句子的开头和结尾。基于先前的隐藏状态在每个时间步中自适应地计算注意力。

在我们的方法中,我们利用指导字幕作为引导相关视觉注意力的文本语言。我们的图像字幕网络经过训练,可以将以下损失降至最低:

其中fT-att是建议的文本引导注意模型。 与之前基于注意力的方法相反,我们模型的注意力不仅受图像特征的驱动,而且受到从引导字幕获得的文本特征的驱动。注意力仅在开始时计算一次并用于计算初始隐藏状态h-1。

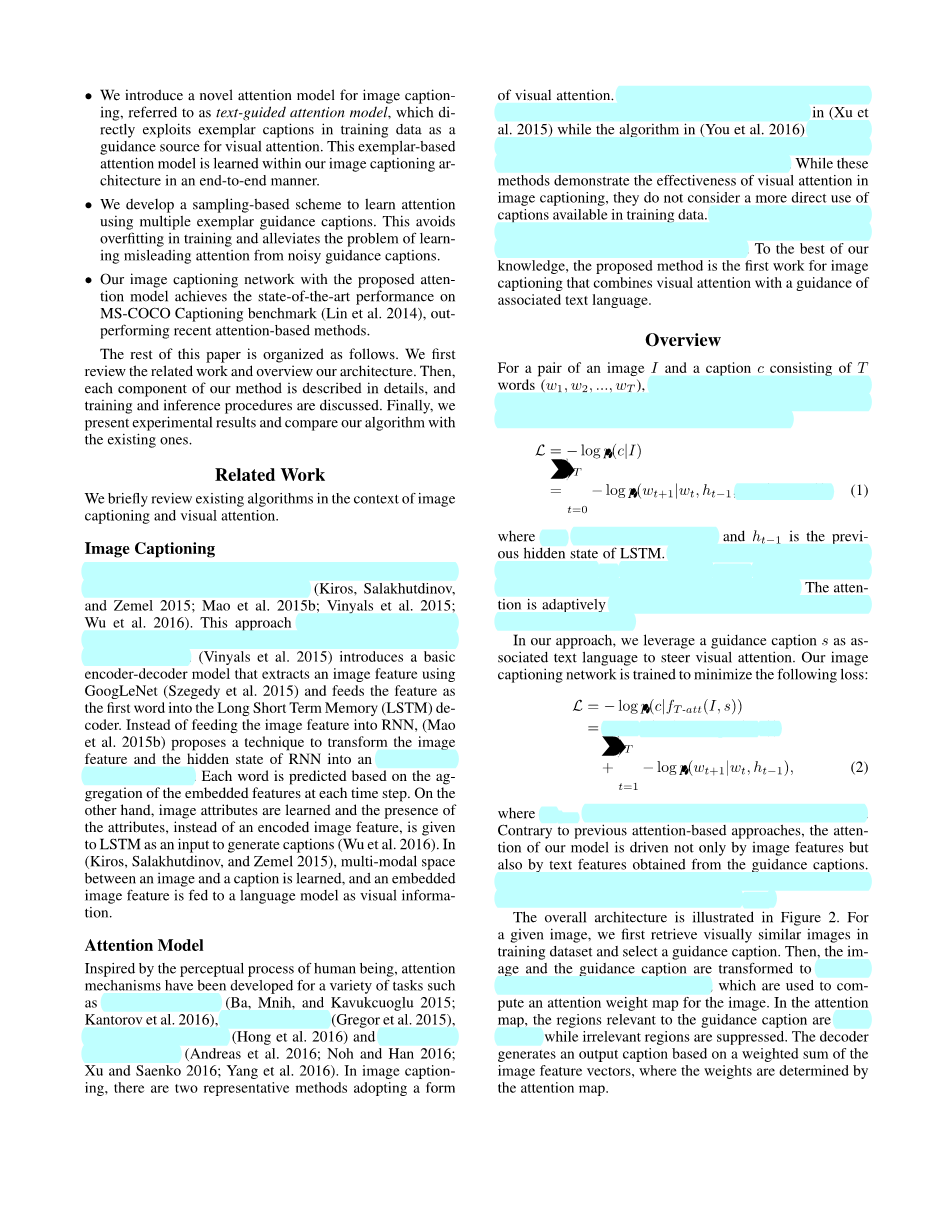

整体架构如图2所示。对于给定的图像,我们首先在训练数据集中检索视觉上相似的图像,然后选择一个指导字幕。然后,将图像和引导字幕变换为分离的多维特征向量,其用于计算图像的注意力权重图。在关注图中,突出显示与引导字幕相关的区域,同时抑制不相关的区域。解码器基于图像特征向量进行加权并生成输出字幕,其中权重由关注图确定。

图2:带有文本引导注意力模型的图像字幕生成整体架构。给定输入图像,我们首先使用视觉相似性和字幕共识分数从训练数据中检索前k个候选字幕(CC)。我们随机选择其中一个作为训练中的指导字幕,同时使用所有候选字幕作为测试时间的指导字幕。文本引导注意层(T-ATT)计算注意力权重图,其中与给定引导字幕相关的区域具有较高的注意权重。通过聚合由关注图加权的图像特征向量来获得上下文向量。最后,LSTM解码器根据上下文向量生成输出字幕。有关详细信息,请参阅文本。

算法与体系结构

本节讨论我们的算法和提出的架构的细节。

指导字幕提取

地面真实字幕作为视觉注意的引导标题是理想的,但在推断图像字幕生成时不可用。因此,我们使用基于范例的方法来获得指导性字幕,为视觉注意提供有用的信息。我们观察到视觉上相似的图像倾向于共享其字幕中经常描述的显着对象和事件。基于这一观察结果,我们使用共识字幕(Devlin等人,2015)进行指导字幕提取。共识标题被定义为由视觉特征空间中的n个最近邻字幕中的代表性字幕。在实践中,字幕可能与查询图像的字幕一致,而不是最近邻居的字幕。对于每个图像,我们从视觉特征空间中的n个最近邻图像中收集一组字幕CNN。 字幕ci的共识分数si是通过与CNN中所有其他字幕的平均相似度计算得出的:

其中Sim(ci; c0)是两个字幕ci和c0之间的相似性。 我们使用CIDEr(Vedantam,Lawrence Zitnick和Parikh 2015)作为相似度函数。我们使用共识得分作为指导字幕候选而不是仅选择排在第一位的字幕,维持一组排列在靠前k个字幕(k lt;jCNNj)。

编码器

我们的架构中有两个编码器,一个图像编码器和一个引导字幕编码器。我们分别使用CNN作为图像编码器,RNN作为引导字幕编码器。CNN图像编码器提取特征映射,其包含相应感受域的P维特征。 对于RNN指导字幕编码器,我们采用Skip-Thought Vector模型(STV)(Kiros等人,2015)。通过在大型语料库上预测超过七千四百万个句子的周围两个句子,在无监督学习技术中训练该句子嵌入模型。STV由门控递归单元(GRU)(Chung等人,2014)组成,其类似于但比LSTM更简单,并且引导字幕特征从GRU的最后隐藏状态获得。 请注意,我们在训练期间修复了两个编码器的参数。

文本引导的注意力模型

给定图像特征fI和指导字幕特征fS,我们的下一个目标是提取描述图像的相关内容的上下文向量。让我们用f i I表示图像中第i个位置的区域特征。 我们的注意模型使用简单的前馈神经网络计算引导标题特征fS的注意权重:

其中WI; WS; Watt分别是用于图像特征,引导字幕特征及其加权和的嵌入矩阵。 在计算所有区域的注意权重之后,应用softmax以使注意力的总和变为1。 然后,我们获得上下文向量作为图像特征向量的加权和:

在训练注意模型时,我们通过在(2)中添加熵项log(alpha;)来规范(5)中的注意权重,这鼓励注意权重是均匀的并且过分关注某个区域。在训练期间,注意模型逐渐从统一的注意力开始学习感兴趣的区域。

解码器

整个解码器包括字嵌入层,LSTM单元和字预测层。 我们假设字幕由T个字组成(w1; w2; :::; wT)。 对于句子的开头,我们添加单词w0,即lt;BOSgt;。 我们的解码器由一下方程制定:

其中Wz,We和Wh被嵌入学习用于上下文向量,输入字和隐藏状态的矩阵。 pt 1表示所有单词的概率分布。在每个时间步t,输入字wt被投影到字向量空间中。 LSTM单元基于单词矢量xt和先前隐藏状态ht-1计算当前隐藏状态ht。然后,基于当前隐藏状态ht预测该单词。在下一个时间步骤中将预测字和当前隐藏状态反馈到解码器单元中,并且重复整个过程直到发出字lt;EOSgt;。在初始步骤(t = -1),包含图像信息的上下文向量用作初始单词。这里,嵌入上下文向量以使其维度与单词向量的维度相匹配。给定嵌入的上下文向量x-1,LSTM单元使用在前一个隐藏状态h-2的位置具有全零的向量来计算初始隐藏状态h-1。单词嵌入和预测层共享其权重以减少参数的数量(Mao等人,2015a)。

学习和推理

在我们的方法中,指导字幕的质量对于训练和测试都至关重要。即使我们设法通过方程(3)的共识字幕方案过滤掉许多嘈杂的指导字幕,我们观察到当使用最高共识分数的标题作为指导标题时,我们的注意模型经常遭受过度拟合。为了解决这个问题,我们使用一组顶级k共识字幕作为培训和测试中指导标题的候选者。

在训练中,我们在每个图像的前k个共识字幕中随机选择一个字幕。这种随机抽样策略允许我们的注意力模型避免过度拟合并从不同的共识字幕中学习适当的注意力。

在测试中,我们使用所有k个共识字幕作为指导字幕生成k个字幕,然后通过重新排列k个字幕来选择最佳字幕。请注意,我们应用大小为2的波束搜索,同时生成一个字幕,每个共识字幕作为指导字幕。对于重新排名,我们采用(Mao等人,2015b)的方案,该方案测量CIDEr与训练数据中其n个最近邻图像的字幕的相似性。 在我们的实验中,我们在训练和测试中确定n = 60和k = 10。

实验

本节描述了我们的实验设置,并提供了算法的定量和定性结果,与最近的方法进行了比较。

数据集

我们在MS-COCO数据集上训练我们的模型(Lin et al.2014),其中包含123,287个图像。 图像分为82,783个训练图像和40,504个验证图像。 每张图片都

全文共14722字,剩余内容已隐藏,支付完成后下载完整资料

资料编号:[136],资料为PDF文档或Word文档,PDF文档可免费转换为Word

您可能感兴趣的文章

- GIS矢量地图的鲁棒水印方案外文翻译资料

- 中国相似地理位置发达地区房价影响因素的差异——以西安高新区和沣渭新区为例外文翻译资料

- 集成数据在城市土地利用变化时空动态监测的应用——以印度金奈都市为例外文翻译资料

- 全球地表水及其长期变化的高分辨率制图外文翻译资料

- 造成沿海大型城市内涝灾害的主要因素识别——以中国广州为例外文翻译资料

- 基于SFPHD框架的中国快速城市化地区城市生态系统健康综合评价方法外文翻译资料

- 基于绿地演变的未来城市地表热岛强度的多情景模拟预测外文翻译资料

- 中国大陆272个城市地面和冠层城市热岛强度的长期趋势外文翻译资料

- 与孟加拉湾热带气旋有关的中国低纬度高原远距离降雨事件外文翻译资料

- 新丰江水库流域GPM IMERG降水产品评价及水文效用研究外文翻译资料