英语原文共 13 页,剩余内容已隐藏,支付完成后下载完整资料

当司机们都犯错误时,他们受到的指责比他们的自动驾驶汽车还多

Edmond Awad 1,2,9, Sydney Levine 1,3,4,9, Max Kleiman-Weiner 3,4, Sohan Dsouza1, Joshua B. Tenenbaum3*, Azim Shariff5*, Jean-Franccedil;ois Bonnefon 1,6* and Iyad Rahwan 1,7,8*

当一辆自动汽车伤害到某人时,谁会被听到它的人责怪呢?在这里,我们要求人类参与者考虑一个假设的案例,其中一名行人被一辆由一名主要和一名次要驾驶员共同控制的汽车撞死,并指出应该如何分配责任。我们发现,当只有一个驱动程序出错时,不管这个驱动程序是机器还是人,都会受到更多的指责。然而,当两个驾驶员在人机共享控制车辆的情况下都出现错误时,归咎于机器的责任就减少了。这一发现预示着公众对自动汽车故障的人工智能部件反应不足,因此具有直接的政策含义:允许陪审团系统在法庭上确立共享控制车辆的事实标准,可能无法适当地规范这些车辆的安全;相反,可能需要自上而下的计划(通过联邦法律)。

每年,全世界约有125万人死于车祸。有关过失原则的法律目前裁定,在这些有害事故中,如何将责任和责任分配给伤害他人的个人。即将向全自动汽车过渡,这意味着在发生车祸的情况下,责任和责备的方式将发生根本性的转变,但大多数人同意,很少或根本不会归咎于车上的乘客,届时,他们将完全脱离决策循环。然而,在全自动汽车时代到来之前,我们正进入一个人类和机器共享控制的微妙时代。12

这一新的时刻标志着一种新的制度的背离,即个人完全控制自己的车辆,从而对撞车事件承担全部责任(在没有缓解情况的情况下),一种新的制度,在这种制度下,责任和责任可能由人和机器司机共同承担。当人和机器共同控制一辆车时,人们对撞车的自发反应至少有两个直接的工业图形含义。首先,目前,公众对涉及人和机器司机的交通事故可能做出的反应知之甚少。这种不确定性具有具体的含义:制造商对产品定价,以反映他们预期从这些产品的销售中产生的责任。如果制造商无法评估他们将从自动车辆中承担的责任范围,这种不确定性将转化为自动车辆价格的大幅上涨。此外,自动车辆的采用率将与消费者采用新技术的成本成正比。(这项技术的采用率取决于许多其他因素,包括消费者对使用汽车的相对风险和利益的理解。我们不是说制造商责任范围的不确定性是影响采用的唯一因素,只是这是一个重要因素。)因此,企业对自动车辆碰撞责任程度的不确定性可能会减缓自动车辆的采用,同时人们每年都会死于车祸。澄清制造商在自动撞车事故中如何以及何时承担责任,将是减少这种不确定性和加快采用自动车辆(最终是全自动车辆)的第一步。222

这项工作的第二个直接含义将是预测一个基于侵权行为的监管计划(该计划是根据陪审团的决定来决定的)将如何产生。换言之,了解公众对涉及人和机器司机的交通事故的可能反应,将给我们一个提示,如果我们让陪审团的决定来塑造这些事故,将制定什么样的标准。如果我们的工作揭示了可能影响陪审团的系统性偏见,并会阻碍自动汽车的采用,那么联邦法规的出台或许是有意义的,这将阻止侵权制度成为为这些汽车制定标准的途径。

自动撞车已经成为公众关注的焦点。2016年5月,特斯拉(Tesla)自动驾驶汽车发生首例致命车祸,车上乘客丧生。在新闻稿中,特斯拉解释说:“无论是自动驾驶仪还是司机都没有注意到在明亮的天空下牵引车的白色一侧,所以刹车没有应用。”。2018年3月,发生了导致一名行人死亡的第一起自动撞车事故。一个过街的行人没有被车和后备司机注意到。车祸发生前几秒钟,这辆车终于确认应该刹车,但没有刹车。司机也因刹车太晚而无法避免碰撞。3

在致命的特斯拉和优步事故中,机器司机和人类司机都应该采取行动,但都没有。机器和人的错误都导致了坠机。国家公路安全交通管理局对特斯拉事件进行了调查,没有发现特斯拉有过错

在车祸中。同样,Uber在一名县检察官的调查后也被免除了刑事指控。值得注意的是,媒体对特斯拉事件的关注明显偏向于将车祸归咎于人类司机,很快传闻说司机一直在看哈利波特的电影,不过经过进一步调查发现,没有证据证明这一说法成立。同样,Uber后备司机的命运仍不得而知,媒体关注的焦点是司机分心的本质。456758

围绕这两起车祸的一系列轶事开始显示出一种令人不安的模式,即在某些类型的自动车辆碰撞中,人类可能比机器伙伴受到更多的指责。这种模式是对坠机事件和新闻环境的侥幸心理吗?或者它是否反映了更深层次的心理反应,可能会影响我们对人-机联合行动的反应,特别是当一对人-机联合控制一辆车时?

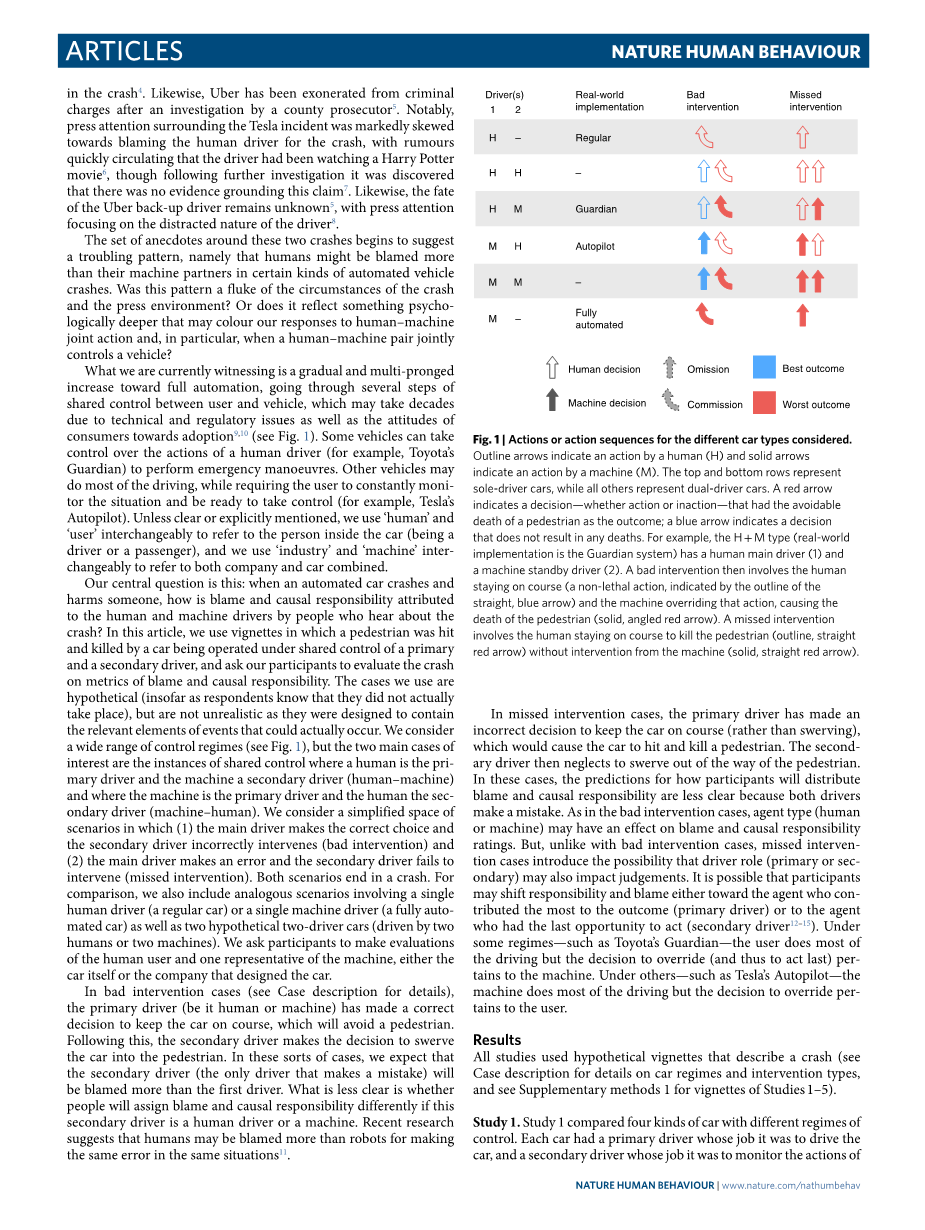

我们目前所看到的是逐步和多管齐下地向全自动化方向发展,在用户和车辆之间经历了几个共享控制步骤,由于技术和法规问题以及消费者对采用的态度,这可能需要几十年的时间(见图1)。一些车辆可以控制人类驾驶员(例如丰田的守护者)执行紧急操作的行为。其他车辆可能会完成大部分驾驶任务,同时要求用户持续监控情况并做好控制准备(例如,特斯拉的自动驾驶仪)。除非明确或明确提及,否则我们将“人”和“用户”互换指车内人员(司机或乘客),将“工业”和“机器”互换指公司和汽车的组合。9,10

|

1媒体实验室,麻省理工学院,剑桥,硕士,美国。经济系,埃克塞特大学商学院,埃克塞特,英国。麻省理工学院脑与认知科学系,剑桥,马萨诸塞州,美国。心理学系,哈佛234 剑桥大学,硕士,美国。不列颠哥伦比亚大学心理学系,温哥华,温哥华,不列颠哥伦比亚,加拿大。图卢兹56 经济学院(TSM研究),国家科学研究中心,图卢兹首都大学,图卢兹,法国。中心7 人与机器,马克斯·普朗克人类发展研究所,柏林,德国。数据、系统和社会研究所,麻省理工学院,剑桥,马萨诸塞州,美国。这些作者同样贡献:埃德蒙阿瓦德和悉尼莱文。*电子邮箱:jbt@mit.edu;shariffa@uci.edu;jean-francois.bonnefon@tse-fr.eu;irahwan@mit.edu89 |

我们的核心问题是:当一辆自动驾驶的汽车撞毁并伤害到某人时,听说撞车事件的人如何将责任和因果关系归咎于人和机器司机?在本文中,我们使用了一个小插曲,其中一名行人被一辆由一名主要和一名次要驾驶员共同控制的汽车撞死,并要求参与者根据责任和因果责任的标准来评估车祸。我们使用的案例是假设性的(只要受访者知道它们实际上并没有发生),但并不不切实际,因为它们旨在包含实际可能发生的事件的相关元素。我们考虑了广泛的控制机制(见图1),但两个主要的关注点是共享控制的实例,其中人是主要驱动程序,机器是次要驱动程序(人-机),机器是主要驱动程序,人是次要驱动程序(机-人)。我们考虑一个简化的场景空间,其中(1)主驱动程序做出正确的选择,次驱动程序错误地干预(错误干预)和(2)主驱动程序出错,次驱动程序未能干预(错过干预)。两种情况都以崩溃告终。为了进行比较,我们还包括类似的场景,包括一个人驾驶(普通汽车)或一台机器驾驶(全自动汽车)以及两个假设的两人驾驶汽车(由两个人或两台机器驾驶)。我们要求参与者对人类用户和机器的一个代表进行评估,无论是汽车本身还是汽车设计公司。

在不好的干预情况下(详见案例说明),主要驾驶员(无论是人还是机器)已做出正确的决定,使汽车保持在行驶路线上,从而避免行人。随后,副驾驶决定将汽车转向行人。在这种情况下,我们预计次要驱动程序(唯一出错的驱动程序)将比第一个驱动程序受到更多的指责。不太清楚的是,如果次要驾驶员是人类驾驶员还是机器驾驶员,人们是否会以不同的方式分配责任和因果关系。最近的研究表明,在同样的情况下,人类比机器人更容易犯同样的错误。11

图1|所考虑的不同车型的动作或动作顺序。轮廓箭头表示人的动作(H),实心箭头表示机器的动作(M)。顶排和底排代表单司机汽车,而所有其他代表双司机汽车。红色箭头表示作为或不作为的决定,其结果是可避免的行人死亡;蓝色箭头表示不会导致任何死亡的决定。例如,H M类型(现实世界的实现是守护系统)有一个人类主驱动程序(1)和一个机器备用驱动程序(2)。然后,一个糟糕的干预措施涉及到人类停留在航线上(非致命性动作,由蓝色直线箭头的轮廓表示)和机器超越该动作,导致行人死亡(实心、有角度的红色箭头)。遗漏的干预措施包括:在没有机器干预的情况下(实心的、直的红色箭头),让人在行驶途中杀死行人(轮廓线、直的红色箭头)。

在错过干预的情况下,主要驾驶员做出了错误的决定,使汽车保持在行驶路线上(而不是转弯),这将导致汽车撞死行人。然后,副驾驶忽略了转向行人的道路。在这些情况下,关于参与者将如何分配责任和因果关系的预测就不那么清楚了,因为两个驱动因素都会犯错误。在不良干预案例中,代理人类型(人或机器)可能对责任和因果责任等级产生影响。但是,与糟糕的干预案例不同,遗漏的干预案例引入了驾驶员角色(主要或次要)也可能影响判断的可能性。参与者可能会将责任转移到对结果贡献最大的代理(主要驱动因素)或最后有机会采取行动的代理(次要驱动因素)身上。在一些制度下,如丰田的监护人,用户驾驶的大部分,但决定超越(从而采取最后行动)属于机器。在诸如特斯拉自动驾驶仪这样的其他驾驶模式下,机器可以完成大部分驾驶任务,但超越的决定权属于用户。12–15

结果

所有的研究都使用了描述车祸的假想的小插曲(关于汽车状况和干预类型的详细信息,请参见案例描述,关于研究1-5的小插曲,请参见补充方法1)。

研究1 比较了四种不同控制方式的汽车。每辆车都有一个主要驾驶员负责驾驶汽车,还有一个次要驾驶员负责监控第一个驾驶员的行为,并在第一个驾驶员出错时进行干预。最受关注的汽车架构是人-机-次(人-机)和机-主-人-次(机-人)。我们还包括人-人和机器-机器的架构进行比较。这使我们能够看到,当每个驱动角色(主或次)的驱动类型(人或机)没有差异时,在双驱动架构中如何分配责任。

糟糕的干预。在不良干预案例中,两个预测因素被纳入回归分析,结果变量为责备和因果责任等级:(1)驾驶员是否犯了错误;(2)驾驶员类型(人或机器)。主要发现是驾驶员是否犯了错误是评分的一个重要预测因素(见表1,不良干预,研究1)。换言之,司机不必要的干预导致了行人的死亡,而不仅仅是司机按照正确的路线行驶,而不管司机是人还是机器。这里值得注意的是,我们没有检测到驾驶员类型(人与机器)的可靠影响,一旦纠正了多次比较(见表1,人,不良干预,研究1)。在不良干预案例中,我们不进一步讨论这一因素。

遗漏的干预措施。在遗漏的干预案例中,指责和责任判断不能取决于司机是否犯了错误,因为两个司机在这些案例中都犯了错误。这些案例的主要发现是,驾驶员类型(驾驶员是人还是机器)对评分有显著影响。具体地说,在这些人和机器都犯了错误的共享控制场景中,机器驱动程序总是比人驱动程序受到更少的指责(表1,遗漏干预,研究1)和图2)。

人与机器之间的差异似乎是由于当有人在回路中时,减少了对机器的指责。当将共享控制的人-机和机-人实例与机器-机场景进行比较时,这一点很明显。请注意,这些场景中的行为是相同的,但机器受到指责的程度取决于它是与人共享控制,还是同时操作主要和次要驱动程序角色。当机器是主要驱动程序时,当它的次要驱动程序是人类(m1=57.2)与辅助驱动器也是机器(m)时相比2=68),t(760.6)=-5.0,Plt;0.0001,米2——百万1=10.8,m的95%置信区间2——百万1=6.6–15(所有测试都是双尾的)。同样,当机器是次要驱动程序时,当它的主要驱动程序是人(m1=53.4)与主驱动器也是机器(m)时相比2=68),t(722.77)=-6.6,Plt;0.0001,米2——百万1=14.6,m的95%置信区间2——百万1=10.2至19。

研究2。研究2将人类-机器和机器-人类共享控制车与两种不同的基准车进行了比较:一种是由人类驾驶的标准车,另一种是由机器驾驶的全自动车。这使我们既能复制研究1的主要结果(对机器-人和人-机碰撞的反应),又能确定双驱车与单驱车相比,责任分配的不同。行业代表各不相同(汽车和公司),但本研究和后续研究均未分析这一探索性变量。

糟糕的干预。我们复制了研究1的主要结果:即,在共享控制车(机器-人类和人类-机器)的不良干预情况下,驾驶员犯错是否是评分的重要预测因素(表1,不良干预,研究2和图2)。

图2|六种车型的用户和行业责任评级。a、 b,条形图(a)和圆点图(b)。来自研究1(S1:n=786,观察值=3144)和研究2(S2:n=382,观察值=1528)的数据。责任和因果责任的等级是加总的(以下统称为责任)。

对汽车和公司的评级进行汇总(以下统称为行业)。y轴表示S1和S2中考虑的六种车型。这两项研究都考虑了两种类型的汽车,HM(人-机)和MH(机-人)。y轴标签包括研究和车型。例如,S1-HM代表研究1中收集的人机状态评级。在这六种车型中,第一驾驶者的x轴标

剩余内容已隐藏,支付完成后下载完整资料

资料编号:[235760],资料为PDF文档或Word文档,PDF文档可免费转换为Word

以上是毕业论文外文翻译,课题毕业论文、任务书、文献综述、开题报告、程序设计、图纸设计等资料可联系客服协助查找。