英语原文共 7 页,剩余内容已隐藏,支付完成后下载完整资料

嵌入概念的知识图谱

Niannian Guan, Dandan Songlowast;, Lejian Liao

北京理工大学计算机科学与技术学院

文章信息

文章历史:

2018年5月17日收到

于2018年10月4日收到修订后的表格

2018年10月5日接受

2018年11月15日在线提供

关键词:

知识图谱嵌入

概念空间

知识图谱补全

摘要:

知识图谱嵌入旨在将知识图谱的实体和关系嵌入到低维向量空间中,这可以广泛应用于许多任务。用于知识图谱嵌入的现有模型主要集中在实体-关系-实体三元组上,或者与文本语料库交互。但是,三元组信息量较少,并且域内文本语料库并不总是可用,这使得嵌入结果偏离了实际含义。与此同时,我们的心理世界包含许多关于世俗事实的概念。对于人类的认知,与我们学到的知识相比,常识概念更为基础和一般,并且在人类知识积累中起着重要作用。在本文中,基于概念图中实体的常识概念信息,我们提出了一种知识图谱嵌入概念(KEC)模型,它将实体的实体和概念联合嵌入到语义空间中。来自知识图谱的三元组的事实由概念图中的实体的常识概念信息调整。我们的模型不仅关注实体之间的相关性,还关注它们的概念。因此,该模型提供精确的语义嵌入。我们在知识图谱完成和实体分类的任务上评估我们的方法。实验结果表明,我们的模型在这两个任务上优于其他基线。

copy; 2018 Elsevier B.V.保留所有权利。

1.引言

作为人类知识的集合,知识图谱已成为许多人工智能和自然语言处理应用的重要资源,例如问答,网络搜索和语义分析。在相关过程中,知识嵌入是知识表示和知识图谱利用的关键步骤,特别是因为它与深度学习方法的兼容性,深度学习方法目前正变得越来越流行。

知识图谱编码关系事实的结构化信息,这些信息通常以三元组(头部实体,关系,尾部实体)的形式表示(表示为(h,r,t))。知识图谱的嵌入是学习实体的连续矢量表示(嵌入)和结构化知识库(KB)的关系,例如Freebase [1]和Wordnet [2],其旨在为知识图谱提供数值计算框架。为了实现这一目标,已经探索了许多嵌入方法,例如TransE [3],PTransE [4]等。

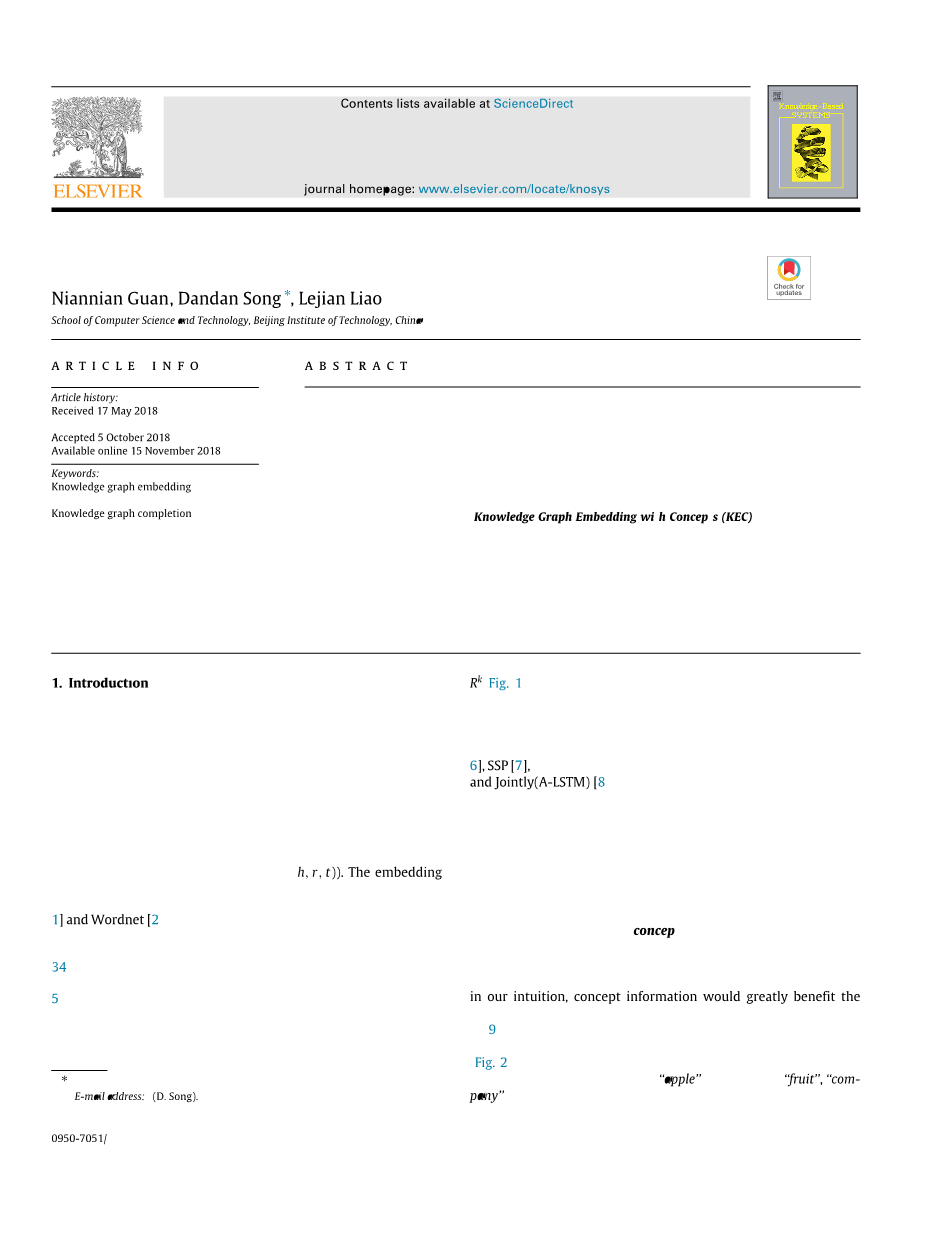

在这些方法中,基于翻译的方法,如TransE和TransH [5],简单而有效。他们通过将关系视为从头部实体到尾部实体的转换来构建实体和关系嵌入。这些模型假设嵌入在同一语义空间R k中的实体和关系。但是,只有三联体信息不足。如图1所示,头部和尾部实体可以具有多个概念,并且各种关系可以关注于实体的不同概念,这使得仅一个语义空间不足以进行建模。

改进的知识嵌入方法和文本描述取得了很大的成功,例如DKRL [6],SSP [7]和Jointly(A-LSTM)[8],具有深度神经网络。他们在嵌入中使用实体和关系的补充文本描述来发现语义相关性。当存在许多实体和关系相关的文本描述时,已成功应用这些方法。但是,文本描述并不总是可用,尤其是对于域内描述,而跨域语料库会导致嵌入结果出现偏差。

与此同时,虽然我们的心理世界包含许多关于世俗事实的概念,但概念是人类认知的另一个重要资源。与知识相比,常识概念更为基础和一般,它们在人类知识学习和积累中发挥着重要作用。因此,在我们的直觉中,概念信息将极大地有益于知识嵌入结果。

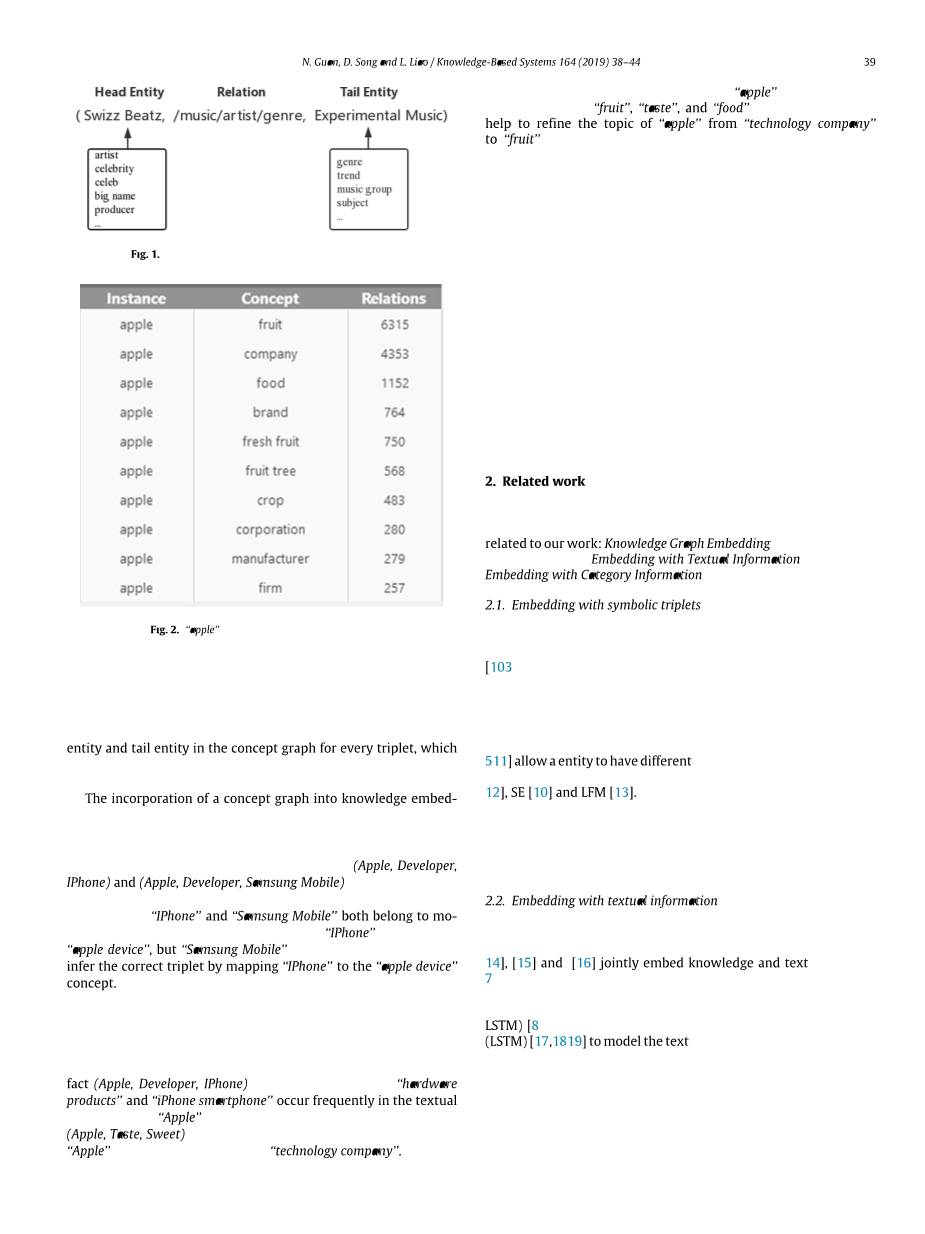

Microsoft Concept Graph [9]将文本输入实体映射到不同的语义概念,并使用依赖于上下文的相应概率标签进行标记。例如,如图2所示,实例(即实体)#39;#39;apple#39;#39;被映射到#39;#39;fruit#39;#39;,#39;#39;company#39;#39;和其他概念,以及相应的频率标签(由微软定义为#39;#39;关系#39;#39;)。概念化将实例或短文本映射到大型自动学习概念空间,这是一个具有人类概念推理的向量空间。因此,我们可以在概念图中为每个三元组构建一个概念子空间,其概念具有头部实体和尾部实体,这使我们能够以原则方式计算实体之间有意义的概念相关性。

将概念图结合到知识嵌入中可以揭示实体之间的概念相关性并有助于精确的语义表达。此外,概念相关性和精确的语义表达能够识别真正的三元组。

例如,对于两个三元组(苹果,开发者,iPhone)和(苹果,开发者,三星移动),很难区分哪个是真正的三元组只包含事实三元组,因为#39;#39;iPhone#39;和#39;#39;三星手机#39;#39;都属于手机。然而,在概念图中,#39;#39;iPhone#39;#39;有一个概念#39;#39;苹果设备#39;#39;,但#39;#39;三星移动#39;#39;没有。因此,通过将“IPhone”映射到“苹果设备”概念,很容易推断出正确的三元组。

与具有文本信息的嵌入方法相比,具有概念信息的嵌入方法在其任务中更加通用,并且它不依赖于语料库的主题。具体来说,当提供关于技术的语料库时,具有技术文本描述的嵌入方法可以很容易地推断出事实(苹果,开发者,IPhone),因为关键字“硬件产品”和“iPhone智能手机”经常出现在文本中#39;#39;Apple#39;#39;的描述。然而,很难推断出事实(Apple,Taste,Sweet),这与#39;#39;苹果#39;#39;关于#39;#39;科技公司#39;#39;特定主题的文字描述无关。

相比之下,“苹果”的概念信息包含相关概念,如“水果”,“味道”和“食物”。这些概念可以帮助将“苹果”的主题从“技术公司”改进为“水果”。因此,概念信息不同于特定领域的文本语料库,它涵盖了各种主题。此外,必须从知识库或其他资源中提取文本描述,而Microsoft概念图提供了可以直接在应用程序中使用的概念信息。因此,我们的方法相对更有效,并且在数据采集中具有较低的劳动力需求。

在本文中,我们提出了一个知识图谱嵌入概念模型(KEC),它通过在概念子空间中执行嵌入过程来构建符号三元组和概念图之间的强相关性。具体而言,我们通过将损失向量投影到概念子空间(例如表示实体之间的概念相关性的超平面)来测量三元组的可能性。因此,只要在语义概念空间中其预测的损失向量的2范数足够小,就总是接受事实三元组。

我们使用Freebase和WordNet的基准数据集上的知识图谱完成和实体分类任务来评估我们的模型。实验结果表明,与最先进的模型相比,KEC模型实现了显着且一致的改进。

2.相关工作

近年来,已经开发了许多知识嵌入方法,它们通常包括与我们的工作相关的三个分支:知识图谱嵌入仅具有符号三元组的模型,嵌入文本信息模型和嵌入类别信息模型。

2.1.嵌入符号三元组

知识图谱嵌入到低维连续向量空间中,同时保留了它的某些属性[10]。例如,最着名的TransE [3]模型关系通过将它们解释为对实体的低维嵌入进行操作的翻译而发生。 TransE在1对1关系中表现良好,但它存在建模1对N,N对1和N对N关系的问题。因此,假设TransE的许多变体,并且它们将实体转换成不同的子空间。例如,TransH [5]和TransR [11]允许实体在不同的关系下具有不同的表示。还有一些其他系统,如RESCAL [12],SE [10]和LFM [13]。

但是,三元组信息的信息量较少。由于存在其他可用的信息源(例如以下小节中的文本信息,以及本文中的概念信息),这可能是增强知识图谱嵌入的补充,因此提出了一些改进的模型。

2.2.嵌入文本信息

嵌入文本信息试图使用文本信息来帮助知识图谱表示学习。 [14],[15]和[16]中的研究通过对齐方法将知识和文本共同嵌入到同一空间中。 SSP [7]通过将三元组嵌入到诸如超平面的语义子空间上来关注更强的语义交互。联合(ALSTM)[8]使用双向长短期记忆网络(LSTM)[17,18]和注意机制[19]来模拟文本描述。

文本信息被批准为有效地帮助知识图谱嵌入。但是,这些方法需要文本语料库,主要是实体的文本描述。但是,对于许多长尾实体而言,文本描述不可用或准备不充分。如果使用跨域语料库,则会使嵌入结果偏离。

2.3.嵌入类别信息

有一些嵌入方法可以整合来自大规模知识库的层次类别信息。实体层次结构嵌入[20]学习每个类别节点的距离度量,并在聚合度量下测量实体向量相似性。 HCE [21]学习实体和类别嵌入以捕获实体和类别之间的语义相关性。但是,他们的目标是从纯文本中提取语义,这与我们的知识图谱嵌入目标不同。

3.方法

我们的知识图谱嵌入概念(KEC)模型是将概念图信息集成到知识图谱嵌入中。因此,它由两部分组成:概念图嵌入和概念图信息增强知识图谱嵌入。

受知识图谱嵌入文本描述方法SSP [7]的启发,我们的模型为知识图谱嵌入执行概念空间投影。换句话说,三元组的损失向量被投影到概念子空间上作为超平面,其表示实体之间的概念相关性。

3.1.概念图嵌入

在Microsoft Concept Graph中,如图2所示,数据以(实例(即实体),概念,关系(即频率))的形式存储。应当注意,这里“关系”的使用不同于知识图谱三元组(h,r,t)中的关系r。由于Microsoft概念图在其当前版本中包含“IsA”关系,因此“关系”表示映射到概念的实例的频率,该概率通过其出现的总数来度量。

为了学习可以捕获其语义相关性的概念和实体的表示,我们使用skip-gram模型[22]进行嵌入。 skip-gram模型旨在生成善于预测在滑动窗口中围绕目标词的上下文词的词表示。我们将实体的上下文扩展为具有最大频率的实体,这些实体被概念化为相同的概念。因此,如下从概念图三元组中获取一组实体对D =(et,ec),其中et表示目标实体,ec表示上下文实体。

在概念图中,如图3所示,每个实体et可以概念化为一个或多个概念(c1,c2,...,ck),kge;1,并且每个概念ck包含一个或多个实体(e1) ,e2,...,ekn),knge;1,被视为候选上下文实体。为了同时学习实体和概念的嵌入,我们采用了一种方法,在预测其上下文实体时将标记的概念合并到目标实体中,这类似于TWE-1模型[23],它将主题信息与单词结合起来预测语境词。

例如,如果et是目标实体,则其标记的概念(c1,c2,...,ck)将与et组合以预测上下文实体。对于每个目标 - 上下文实体对(et,ec),基本Skipgram公式使用softmax函数定义ec作为et或ci的上下文的概率:

其中et,ec和ci是目标实体的矢量表示,上下文实体和目标实体的概念。 E表示实体集,exp表示指数函数。

我们的概念图嵌入对象是最大化平均对数概率:

其中D表示目标上下文实体对的集合,C( et)表示实体等的概念集。我们采用随机梯度下降法来优化对象。初始学习率为0.025,根据以下函数随着训练样本的增加而减小:

其中alpha;是学习rate,count_actual是训练样本的数量,iter是迭代次数,而total_size是训练样本的总数。

为了处理大型数据集,我们在培训中使用12个线程在10分钟内训练模型。为避免过度拟合,我们对优化目标采用“负抽样”方法。

3.2.知识图谱嵌入

为了表征知识库三元组和概念信息之间的强相关性,我们尝试将特定三元组嵌入到概念子空间中。首先,我们用法向量c作为概念子空间构造超平面:

其中C:R 2d→R d是概念组成函数和eh,et是分别通过概念图嵌入获取的头实体和尾实体语义向量。由于使用skip-gram模型学习语义嵌入可以使连接某个关系的实体对的向量几乎平行,例如,vec(#39;#39;King#39;#39;)-vec(#39;#39;Queen#39;#39;)asymp;vec(#39; #39;man#39;#39;)- vec(#39;#39;Women#39;#39;),我们建议概念组合应采用减法形式。

TransE模型将得分函数定义为||h r - t||22,这意味着三元组嵌入取决于损失向量l = h r - t。因此,我们可以计算出法向量方向上的损失分量是(c T lc)。然后,投影到超平面上的另一个正交分量是(l-c T lc),如图4所示。结果,假设e是长度固定的,我们模型背后的基本思想是最大化概念超平面内的组件,即||l - c Tlc||22。

我们将总分数函数定义如下:

其中lambda;是一个合适的超参数因子来平衡这两个部分。此外,得分函数有利于训练集中三元组的能量值低于损坏的三元组。此外,我们的得分函数中的投影部分是负的,因此,更多的投影意味着更少的损失。

3.3.模型解释

首先,我们的模型可以发现概念的相关性。我们的目标是将损失h#39; - t投影到超平面上,其中h#39;= h r是翻译的头部实体。然后我们利用定理来说明如果一条线位于超平面上,那么该线的所有点也位于超平面上。因此,具有相关概念的实体总是位于一致的超平面上,并且它们之间的损耗矢量(h#39; - t)也在超平面周围。基于这种几何形状,损坏的三元组远离超平面,这导致大量损失。相反,即使在知识嵌入方面丢失正确的三元组也很大,在投影到超平面上之后它可能更小(或更好)。这些考虑意味着概念信息提高了概念的相关性,从而改进了知识嵌入。例如,很难在知识嵌入中推断事实的可能性(克里斯托弗·普卢默,/人民 /人 / 国籍,加拿大) 。在链接预测中,TransE在14,951中排名11,831,这将被归类为一个不可能的事实。然而,在概念图中,#39;#39;克里斯托弗·普卢默#39;#39;具有#39;#39;演员#39;和#39;#39;明星#39;#39;概念,而“加拿大”

全文共16256字,剩余内容已隐藏,支付完成后下载完整资料

资料编号:[2936]

以上是毕业论文外文翻译,课题毕业论文、任务书、文献综述、开题报告、程序设计、图纸设计等资料可联系客服协助查找。