英语原文共 6 页,剩余内容已隐藏,支付完成后下载完整资料

基于深度强化学习的任务型对话模型的端到端优化

Bing Liu1lowast;, Gokhan Tuuml;r2, Dilek Hakkani-Tuuml;r2, Pararth Shah2, Larry Heck2

1Carnegie Mellon University, Pittsburgh, PA 15213

2Google Research, Mountain View, CA 94043 liubing@cmu.edu, {gokhant,dilekh,pararth,larryheck}@google.com

摘要

在本文中,我们提出了一个基于神经网络的以为任务导向的对话系统,它可以通过深度强化学习(RL)进行端到端优化。该系统能够跟踪对话状态,与知识库对接,并将查询结果合并到代理的响应中,从而成功完成任务导向的对话。对话政策学习采用混合监督和深度RL方法进行。我们首先通过以监督式学习方法直接从任务导向的语料库学习,并且在与用户交互期间通过深度RL进一步优化它。在两个不同的对话任务领域的实验中,我们的模型在跟踪对话状态和产生合理的系统响应方面表现出健壮的性能。我们显示与监督训练模型相比,基于深度RL的优化使得任务成功率增加并减少了对话长度。我们进一步展示了以对话模拟和人类评估的实验结果进行组件优化的端到端训练面向任务的对话模型的益处。

1 概述

面向任务的对话,不同于闲谈类型的对话,要求系统通过访问知识库中的信息并通过多次对话轮回来制定响应。 传统的面向任务的对话系统有一个复杂的流水线[1,2],包括独立开发和模块化连接组件的自然语言理解(NLU)[3,4],对话状态跟踪(DST)[5,6]和 对话政策[7,8]。 这种流水线设计的一个限制是,上游模块中产生的错误可能会传播到下游组件,从而很难识别和跟踪错误的来源。 此外,流水线中的每个组件都被理想地重新训练当前面的组件被更新,从而使我们在运行时有类似于训练示例的输入。 这种多米诺骨牌效应在实践中导致了几个问题。

为了缓解传统管道对话系统的这些局限性,在设计基于神经网络的端到端的学习解决方案方面做出了努力。 这样的端到端系统旨在直接优化最终系统目标(例如响应产生,任务成功率)而不是执行组件式优化。许多最近提出的端到端模型都是通过从人人或人机对话语料库中学习,以监督的方式进行训练[9,10,11,12]。 文献中也研究了通过与人类用户或用户模拟器交互学习的基于深度强化学习(RL)的系统[13,14,15,16]。 与监督式训练模型相比,使用深度RL进行训练的系统显示出更高的任务成功率和对不同对话场景的模型健壮性。

在这项工作中,我们提出了一个基于神经网络的任务导向对话系统,可以通过深度RL进行端到端优化。 该系统由自然语言编码,对话状态跟踪和对话策略学习的神经网络组件构建而成。 每个系统组件都会连续接收底层组件的输出,从系统优化目标方面来看,它是完全可以区分的,因此整个系统可以进行端到端的训练。 在电影预订领域的实验中,我们表明,我们的系统使用深度RL进行训练与监督训练系统相比,对话任务成功率显着提高。 我们进一步阐述了相较于许多之前工作中仅仅在在线策略学习期间更新策略网络[7,8],执行端到端的优化的好处。

2 相关工作

传统的面向任务的对话系统通常需要大量的手工功能,因此很难将系统扩展到新的应用领域。 最近的面向任务的对话方法将任务视为一个部分可观察的马尔可夫决策过程(POMDP)[2],并通过与用户交互来使用RL进行在线策略优化[17]。 对话状态和行动空间必须仔细设计,以便使强化策略学习易于处理[2]。

随着端到端可训练神经网络模型在非任务型聊天对话建模中的成功[18,19],一些努力已经将端到端模型的良好性能推广到任务导向对话。 Bordes 和 Weston [10] 提出了使用端到端存储网络的机器阅读方法建模面向任务的对话。他们的模型删除了对话状态追踪模块,并直接从候选答案中选择出最终的系统响应。与这种方法相比,我们的模型明确地追踪用户在对话状态下的转向顺序目标,因为强大的对话状态跟踪已经显示[20,16]对于与知识库(KB)对接和提高任务成功率有很大的用处。Wen 等人 [9]提出了一种端到端的有模块化连接的系统组件的可训练神经网络模型。这个系统是以监督的方式进行训练的,因此由于培训对话样本中的品种有限,可能无法处理不同的对话情况。我们的系统通过SL和深度RL方法的组合训练,因为它表明RL训练可以有效地提高系统的鲁棒性和对话成功率[13,15]。 Dhingra 等人 [16] 提出了一个端到端的RL对话代理用于信息获取。他们的模型着重于通过在选择知识库条目时引入“软”检索过程来将差异性引入知识库查询操作。这种软知识库查找可能倾向于在现实世界的信息系统中很常见的知识库中的信息更新。在我们的模型中,我们使用符号查询并将知识库实体的选择留给外部服务(如推荐系统),因为实际系统中的实体排名可以用更丰富的功能集(例如用户文件,位置和时间上下文等等)。生成的查询的质量与我们的对话状态跟踪模块的性能直接相关,可以在提出的端到端强化学习模型中的用户交互期间对其进行优化。

3 提出的方法

3.1 系统构架

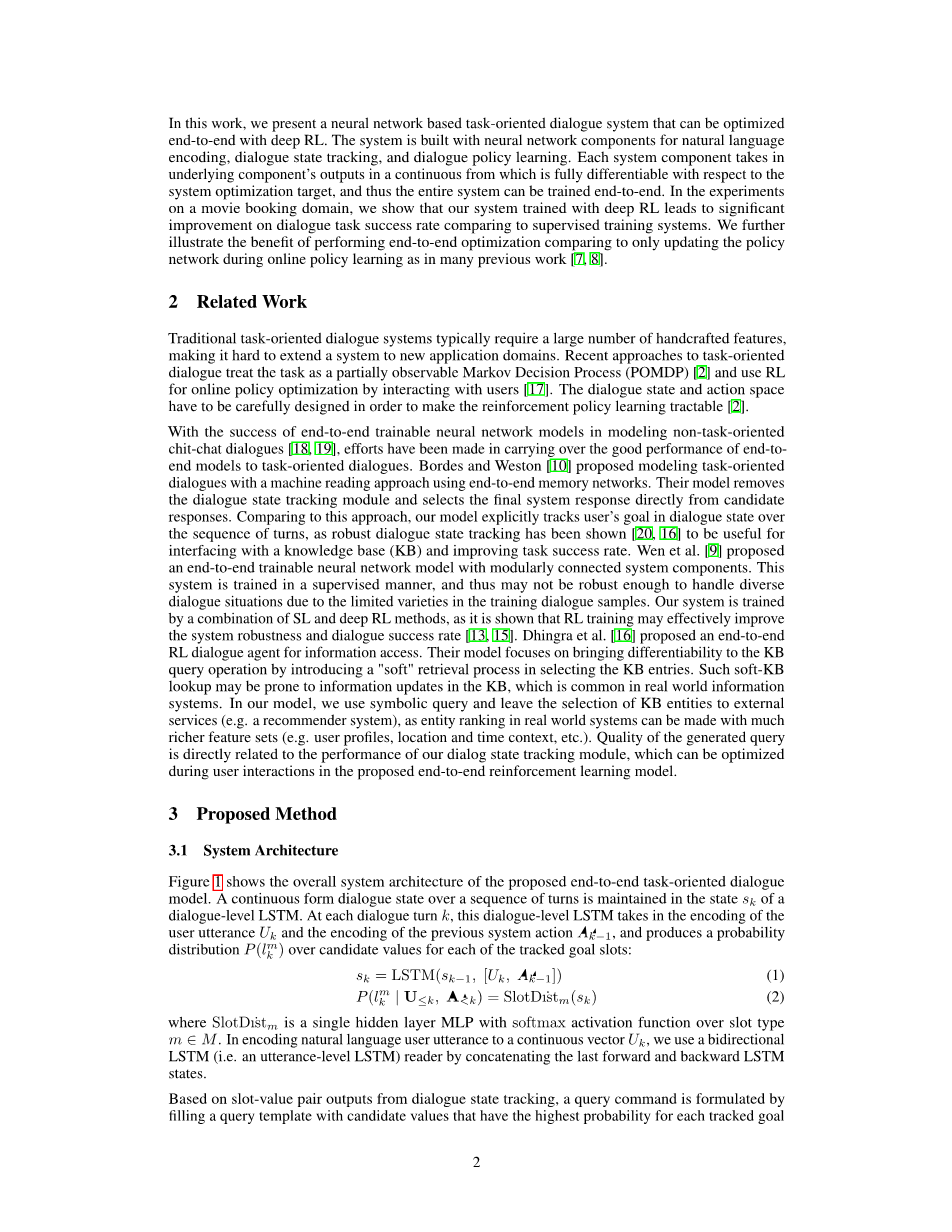

图1显示了所提出的端到端任务导向对话模型的总体系统结构。 在对话级LSTM的状态sk中保持一系列转动的连续形式对话状态。 在每个对话转k时,这个对话级LSTM接受用户话语Uk的编码和先前系统动作Akminus;1的编码,并且产生每个被跟踪目标时隙的候选值的概率分布:

sk = LSTM(skminus;1, [Uk, Akminus;1]) (1)

) = SlotDistm(sk) (2)

其中SlotDistm是具有softmax激活函数的单隐层MLP,其在时隙类型misin;M上。在将自然语言用户话语编码为连续矢量Uk时,我们使用双向LSTM(即,话语级LSTM)读取器,通过将最后一个前向 和落后的LSTM状态。

基于来自对话状态追踪的时隙 - 值对输出,查询命令通过填充具有对于每个追踪目标时隙具有最

图1:提出的端到端的面向任务的对话模型架构

高概率的候选值的查询模板来制定。或者,可以用最可能的候选值生成n最佳的查询列表。 查询被发送到KB以检索用户请求的信息。 最后,基于当前对话状态和从知识库中检索的信息响应用户的输入发出系统动作:

P(ak | Ule;k, Alt;k, Ele;k) = PolicyNet(sk,vk,Ek) (3)

其中vk表示每个目标时隙的候选值的级联对数概率。 Ek是来自知识库的检索结果的编码(例如,物品可用性和匹配物品的数量)。 PolicyNet是一个在所有系统操作中具有softmax激活功能的MLP。 通过组合状态跟踪输出和查询结果,将发出的系统动作转换为自然语言格式的系统响应。 我们在这项工作中使用基于模板的自然语言生成器(NLG)。

3.2 模型训练

我们首先使用面向任务的对话语料库以监督的方式训练系统。 基于过去的用户发言,系统操作和知识库结果的系统输入,模型跟踪用户的目标槽值并预测下一个系统动作。 我们优化模型以最小化对话状态跟踪和系统动作预测的交叉熵损失的线性插值:

其中lambda;s是每个系统输出成本的线性插值权重。 lkm *和a * k是目标位置和系统动作第k转的地面实况标签。

在监督培训阶段之后,我们通过让代理与用户交互并收集用户反馈来进一步优化RL系统。 我们应用REINFORCE算法[21]来优化网络参数。 我们在RL培训期间使用softmax政策来鼓励代理人探索对话行动空间。 反馈仅在对话结束时收集。 为成功任务分配积极的奖励,为失败任务分配零奖励。 对每个对话轮次应用一小步惩罚,以鼓励代理以更少的步骤完成任务。 我们采用政策梯度法进行对话政策学习。 利用似然比梯度估计器,目标函数Jk(theta;)的梯度可以推导为:

上面的最后一个表达式给了我们一个无偏差的梯度估计器。 我们根据每次对话开始时的当前学习策略对代理动作进行采样并计算渐变。

4 实验

4.1 数据集

我们使用DSTC2 [22]数据集在餐厅搜索领域和内部收集的在电影预定领域的对话语料库评估了所提出的方法。 电影预约语料库由基于规则的对话代理和用户模拟器生成。 在RL培训期间,使用相同的用户模拟器与我们的端到端学习代理进行交互。 我们在模型测试中使用一组扩展的NLG模板来评估端到端模型在处理不同自然语言输入时的泛化能力。

4.2 训练设置

我们将对话级别和话语级别LSTM的状态大小分别设置为200 和150。 策略网络的隐藏层大小设置为100。我们使用随机初始化的300字大小的嵌入。Adam初始学习率为1e-3的优化方法[23]用于小批量训练。在训练期间应用0.5的丢失率以防止模型过度拟合。

在对话仿真中,如果状态追踪器估计的目标时隙值与用户的真实目标值完全匹配,并且系统能够提供最终被用户接受的实体,则我们将任务导向对话视为成功。 对话轮次的最大允许次数设置为15.在成功对话结束时向代理人提供 15.0的积极奖励,并在失败情况下给出零奖励。我们在每回合中使用-1.0的步长惩罚来鼓励更短的对话来完成任务。

4.3 结果与分析

表1和表2显示了在DSTC2和电影预订对话数据集上的监督训练模型的表现。 该模型在对话状态跟踪精度上进行评估。 在DSTC2数据集中,与使用RNN [24]和NBT [6]最近公布的结果相比,我们的端到端模型实现了接近最先进的状态跟踪性能。 在电影预订数据集上,我们的模型在单个时隙跟踪和联合时隙跟踪精度方面也取得了提升。

表1:预估DSTC2语料库的追踪结果(以ASR假设为输入)

|

Model |

Area |

Food |

Price |

Joint |

|

RNN [24] |

92 |

86 |

86 |

69 |

|

NBT [6] |

90 |

84 |

94 |

72 |

|

Our end-to-end model |

90 |

84 |

92 |

72 |

Table 2: Belief tracking results on movie booking dataset

|

Model |

Num_ticket |

Movie |

Theater |

Date |

Time |

Joint |

|

Our end-to-end model |

98.22 |

91.86 |

97.33 |

99.31 |

97.71 |

84.57 |

图2显示了对话任务成功率和平均对话轮大小的RL模型。 评估是基于我们提出的端对端对话代理和基于规则的用户模拟器之间的对话模拟。 这与表1和表2中基于固定对话语料的评估不同。基于策略梯度的RL训练是在监督训练模型的基础上进行的。 我们将模型与两个RL训练设置(端到端训练和仅策略训练)相比较,以基线监督学习(SL)模型。

如图2(a)所示,SL模型在用户交互过程中表现不佳,表明SL模型对隐藏对话状态的泛化能力有限。 代理在用户交互过程中所犯的任何错误都可能导致对话与训练对话轨迹和状态之间的偏差。 SL代理不知道如何从未知状态中恢复,从而导致最终任务失败。 RL模型培训在端到端学习和仅限政策的学习环境下,随着用户交互数量的不断增加,不断提高任务成功率。 与交互式学习期间更新策略网络相比,我们发现在实现更高的对话任务成

全文共9794字,剩余内容已隐藏,支付完成后下载完整资料

资料编号:[11119],资料为PDF文档或Word文档,PDF文档可免费转换为Word

以上是毕业论文外文翻译,课题毕业论文、任务书、文献综述、开题报告、程序设计、图纸设计等资料可联系客服协助查找。