英语原文共 11 页,剩余内容已隐藏,支付完成后下载完整资料

一种基于词汇的汉语神经网络

陶贵、邹宜成,气张,彭敏龙,傅金兰,魏忠禹,黄选景

复旦大学上海智能信息处理重点实验室复旦大学计算机科学学院中国上海漳河路825号

tgui16,yczou18,qz,mlpeng16,fujl16,zywei,xjhuang}@fudan.edu.cn

摘要

递归神经网络(RNN)在汉语命名实体识别(NER)中的应用已经取得了很大的成功。然而,链式结构的特点和全局语义的缺乏决定了基于RNN的模型容易受到语义的影响。在本工作中,我们试图通过引入一个带全局Seman-tics的基于词典的神经网络来缓解这个问题,在这种网络中,使用词汇知识来连接字符来捕获本地组合,而全局中继节点取消了全局句子语义和长范围依赖。基于字符、潜在词和整句词组之间基于多重图的交互作用,可以有效地解决单词歧义问题.在四个NER数据集上的实验表明,该模型实现了SIG-nifi对其它

数据库模型的改进。

导言

命名实体识别(NAR)的任务是确定命名实体的实体边界和分类,这是自然语言处理(fi)中的一项艰巨任务。

NER在许多下游NLP任务中发挥着重要作用,包括信息检索(Chen等人,2015b)、关系提取(Bunescu和Mooney,2005)、问答系统(Diefenbach等人,2018)和其他应用。与英语相比,汉语命名实体因其边界不确定、成分复杂和巢内的NE definitions(段和郑,2011)而更容易识别。

减轻单词边界的一种直观方法first执行分词的问题

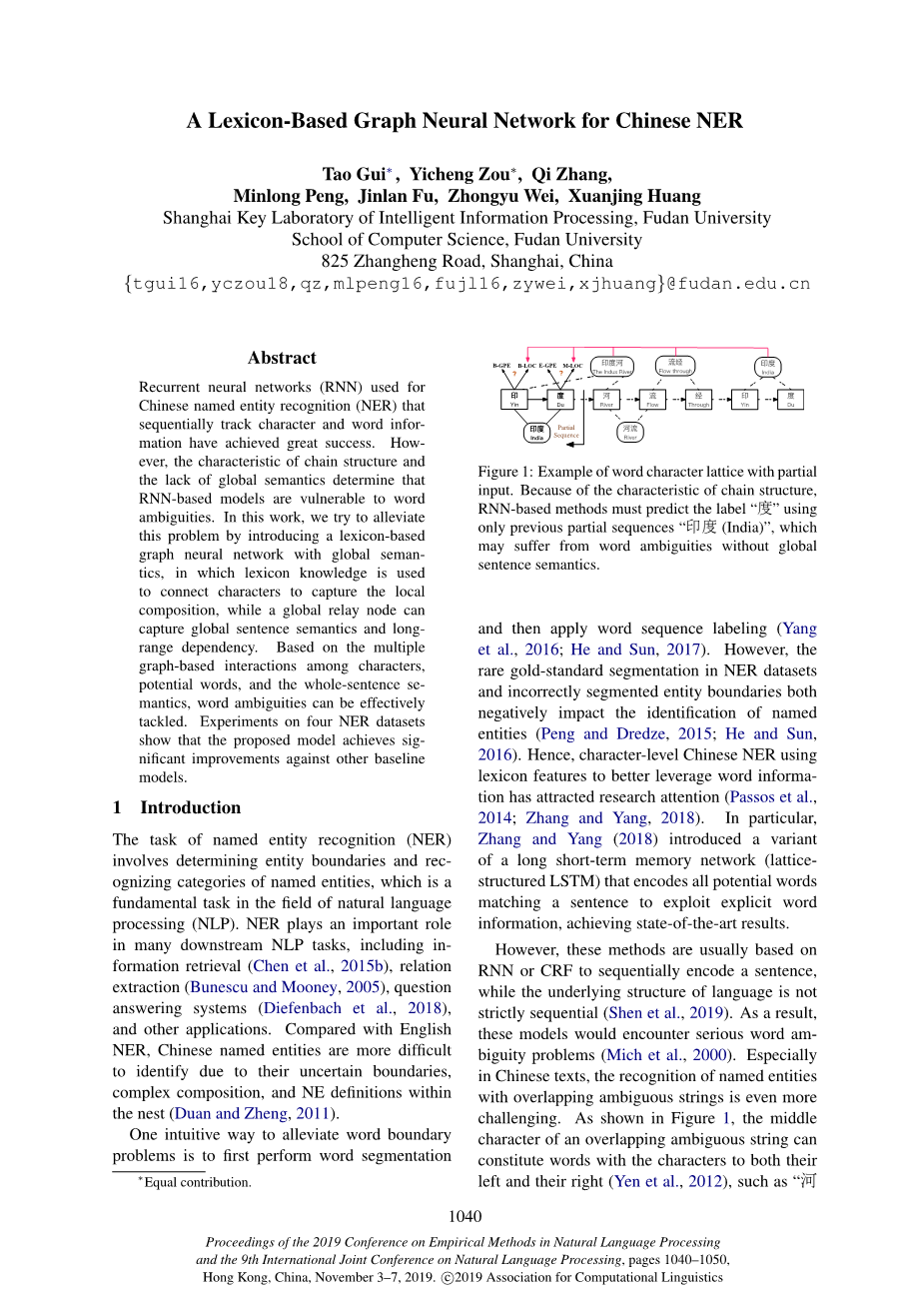

图1:带有部分输入的单词字符格的示例。由于链式结构的特点,基于rnn的方法必须仅使用先前的部分序列“度(印度)”来预测标签“印度(印度)”。如果没有全局句式语义,可能会出现词义歧义。然后应用单词序列标记(Yang等人,2016;He和Sun,2017)。然而,NER数据集中的金标准分割和实体边界的不正确分割都对命名实体的identifi阳离子产生了负面影响(彭和德雷兹,2015;He和Sun,2016)。因此,汉字级的汉语学习者使用词汇特征来更好地利用单词信息已经引起了研究的注意(Passos等人,2014;Zhang和Yang,2018)。特别是,Zhang和Yang(2018)引入了一种长期短期记忆网络(格子结构lstm),它编码所有匹配句子的潜在单词,以利用显式单词信息,取得最新的结果。然而,这些方法通常是基于rnn或crf对一个句子进行顺序编码,而语言的底层结构则不是严格顺序的(shen等人,2019)。因此,这些模型将遇到严重的Word-biguity问题(Mich等人,2000年)。特别是在中文文本中,对具有重叠歧义字符串的命名实体的识别甚至更具有挑战性。如图1所示,重叠的歧义字符串的中间字符可以构成两个字符的单词。左和右(Yen等人,2012年),如“河”

流(河)和流经(Flow)具有共同的特征“流”。然而,RNN-基于模型的字符处理顺序严格,类似于阅读中文,字符优先被分配到左边的单词(Perfetti和Tan,1999)。大多数情况下,基于rnn的模型必须给出标签。仅使用先前的部分序列“度(印度)”的“印度(印度)”,这是有问题的剩下的角色。因此,Ma等人。(2014)建议使用句子语境和高层次信息解决重叠歧义问题。

在本文中,我们介绍了一个基于词典的方法。

图神经网络(GraphNeuralNetwork,简称lgn),实现了节点类fi阳离子任务。该模型打破了RNNS的串行化过程结构,通过仔细的连接,使字符和词之间具有更好的交互效果。词汇的知识结合了相关的字符来捕捉本地成分。同时,设计了一个全局中继节点来捕获远程依赖和高级别特性.LGN遵循一种邻域聚合方案,通过递归聚合其传入边缘和全局中继节点来计算节点的表示。由于聚合的多次迭代,该模型可以使用全局上下文信息反复比较歧义词,从而更好地进行预测。实验结果表明,该方法能在四个NER数据集上达到最先进的性能。

本文的主要贡献如下:

1)提出了利用词典构造图神经网络,实现中文NER作为图节点Classi-fi阳离子任务;2)该模型通过递归聚合机制,可以捕获上下文信息和局部组合,解决汉语歧义问题;3)多个实验结果表明了该方法在不同方面的有效性。

2相关工作

2.1有词汇的汉语词汇。

已有的一些汉语NER研究有基于字的和基于字符的meth-ODS(Li等人,2014),并表明由于当前汉语单词的性能有限。

分割,基于字符的名字Taggers可以超过他们的基于文字的同行(何和王,2008年;刘等人,2010年)。词汇特征已被广泛用于更好地利用中文Ner的词汇信息(Huang等人,2015年;罗等人,2015年;Gui等人,2019年)。特别是张和杨(2018)提出了格点LSTMto模型特征和潜在词。然而,他们的格子lstm使用独立训练的左向右和右向左的lstm来表示特征,这也是有限的(Devlin等人,2018)。在本文中,我们提出了一种新的基于字符的方法,该方法将命名实体作为nodecassifi阳离子任务来处理。所提出的方法可以利用全球信息(包括左和右上下文)(董等人,2019年)来处理这些问题。

2.2文本上的图神经网络

图神经网络已经成功地应用于几个文本类fi阳离子任务。

ˇckovi丙等人,2017年;姚等人,2018年;张等人,2008年b)。彭等人(2018年)提出了一种基于GCN的文本分类fi检索的深度学习模型。张等人(2008 C)提出使用依赖解析树构造关系抽取图。最近,多头注意机制(vaswani等人,2017)在融合过程中被图形神经网络广泛使用(Zhang等人,2018a;Lee等人,2018),它可以通过为相邻节点分配不同的权重来聚合图形信息。或者相关的边缘。给定一组向量Hisin;RNtimes;d,查询向量circ;Qisin;R1times;d,还有一套可训练参数W,这种机制可以拟订如下:

gt;

Attention(q,V

headi = Attention(

MultiAtt(qcirc;,H) = [head1;...;headk]WO. (1)

然而,很少有人研究如何在原始中文文本中利用汉字与构图之间的关系。以往对汉语词法加工的研究较少,提出了一种分解的词汇结构(Zhang和彭,1992;周和马斯伦-威尔逊,1994)。受此启发

图2:图结构的插图。

在理论基础上,我们提出用图论网络来构造构成字与词之间的关系。

3基于词汇的图神经网络

在本文中,我们提出了利用词库信息构造图神经网络,并实现了汉语NOR作为节点类的fi阳离子任务,该

模型通过以下几个方面获得了更好的字符、词和句子之间的交互作用。

聚合→更新→聚合→。。。,一种实用的fi图信息传递体系结构(Gilmer等人,2017年)。

3.1图的构造和聚合

我们利用词汇知识连接字符,捕捉局部构图和潜在词的边界。此外,我们还提出了一个全局中继节点来获远程依赖和高级别特性.节点和边缘聚合模块的实现类似于变压器中的多头注意机制(Vaswani等人,2017)。

图的构造整个句子是否定的-转换成有向图,如图2所示,其中每个节点表示一个字符,而单词中的first和最后一个字符之间的关联可以看作是边。国家表示I-th节点的特性-在文本序列中标记。每个词的状态表示对应的潜在词的特征。利用全局中继节点作为虚拟集线器,从所有节点和边缘收集信息,然后利用全局信息帮助节点去除模糊度。

形式上,让s=c1,c2,.,cN表示森-Tence,其中c我表示第一个字符.这个

表示第一个字符:图3LGN中的聚合,红色表示正在更新的元素,褐色表示聚合中涉及的其他元素。然后在更新模块中使用聚合结果。词汇中的潜在词与一个字符匹配-字符子序列可以表示为W b,e=c b、c b 1,...,c e-1,c e,其中first的索引最后的字母分别是b和e。在这里工作,我们建议使用有向图。G=(V,E)来模拟一个句子,其中每个句子字符c我Iisin;V是图节点,E是集合边缘。一旦字符子序列匹配潜在词wB,eB,e,我们构造了一个边eB,eB,eisin;E,从开头指向字符c。BTO结尾字符cE

为了捕获全局信息,我们添加了一个全局的中继节点连接每个字符节点和字边。对于具有n个字符节点和m个边的图,存在n m全局连接。每个节点和边缘链接到共享中继节点。通过全局连接,两个不相邻的节点都是两跳邻居,并通过两步更新接收本地信息。

此外,我们还考虑了构造图一1.它是同一组节点上的另一个有向图,它的所有边与对应节点的方向相对应。G中的边,我们将转置图表示为G。gt;。类似于双向LSTM,我们构造了G和G。gt;gt;作为双向图和级联G和G的节点状态gt;gt;作为fi的nal输出。给定节点特性的本地聚合

而传入的边缘特征是Etci = {forall;ket k,i}我们使用多头关注集合ek,i 而传入的边缘特征是E。相应的前身节点ck 节点ci ,那里的直觉是进来的边缘而前面的节点可以有效地表示潜在的单词边界信息,如3(A)所示。从形式上讲,节点聚合功能可以表述如下:

e → c : circ;cti = MultiAtt(cti, {forall;k[ctk; et k,i]})

其中t指的是第t步的聚合。[.;·]表示级联操作。

对于边缘聚集,应考虑作用于边缘的所有力或势能(Battaglia等人,2018年)。要利用单词或图形信息,用于构造的词典应该考虑所有字符组合,如图3(B)所示。因此,与传统的利用端点特征集边的经典图神经网络不同,我们使用了完整的匹配特征子序列Ct b,e = {ctb , . . . , cte} 用于边缘聚合

职能如下:

c → e : circ;et b,e = MultiAtt(et b,e, Ct b,e).

我们first将C输入到lstm网络中以生成

上下文化表示作为初始节点C0(Zhang等人,2018c),我们使用了作为初始边状态E的字嵌入E0

C0的基本结构语言不是严格顺序的(沈等人,2019)。为了捕获远程依赖和高级别特性,如图3(C)所示,我们使用了一个全局中继节点来聚合每个字符节点和边缘,如下所示:

gtc = MultiAtt(gt, Ct1,n)

gte = MultiAtt(gt, {forall;et isin; E})

c, e → g : circ;gt = [gtc; gte]

. 经过多次信息交流(第3.2节),circ;Gcirc;GT聚合节点向量和边缘向量总结全球信息,circ;Ecirc;ETB,e捕捉组合特征信息,形成局部构图。因此,在充分了解本地和非本地组合的基础上,提出的模型将有助于技术节点区分歧义词(Ma等人,2014年)。

3.2基于经常性的更新模块节点更新句子的有效使用

解决潜在词之间含糊不清的问题仍然是一个关键问题(Ma等人,2014年),对于一般图表来说,应用基于递归的模块来更新节点的隐藏表示是常见的做法(疤selli等人,2009年;Liet al.,2015年)。因此,我们融合了全局特征。

circ;Ginto字符节点更新模块,如下所示:

acirc;ti = sigma;(Wiaxi;ti Viachi;ti bai ), a = {i,f,l} uti = <e

剩余内容已隐藏,支付完成后下载完整资料</e

资料编号:[405880],资料为PDF文档或Word文档,PDF文档可免费转换为Word

以上是毕业论文外文翻译,课题毕业论文、任务书、文献综述、开题报告、程序设计、图纸设计等资料可联系客服协助查找。