英语原文共 12 页,剩余内容已隐藏,支付完成后下载完整资料

多粒度中文分词

龚晨,李正华,张民,蒋新洲

苏州大学,苏州,中国

摘要

一般传统的中文的单词分词采用单粒度形式,其中一个句子对应于单个单词序列。然而,Sproat等人(1996)表明,汉语单词边界上的解读者一致性比率仅为76%,表明单粒度WS(SWS)对双方的注释和统计建模施加了不必要的挑战。而且,不同粒度的WS可以是互补的并且对于高级应用是有益的。这项工作提出并解决了多粒度WS(MWS)。首先,我们通过利用三个SWS数据集的注释异质性来构建用于模型训练和调整的大型伪MWS数据集。然后我们用真正的MWS注释手动注释1500个测试语句。最后,我们提出三种基准方法,将MWS作为组成分析和序列标签。基于上述条件得实验和分析产生了许多有趣的发现。

- 介绍

作为中文处理的第一个处理步骤,由于大规模基准数据集的诠释,分词(WS)在过去几十年得到了广泛的研究并取得了重大进展,其中最广泛使用的是微软公布的Microsoft Research Corpus(MSR),北京大学人民日报语料库(PPD)和 宾州中国树库(CTB)。

|

MSR |

全国各地 |

医学|界 |

专家 |

人民大会堂 |

|

PPD |

全国|各地 |

医学界 |

专家 |

人民|大会堂 |

|

CTB |

全|国|各|地 |

医学界 |

专家 |

人民|大会堂 |

表1:对三者的分析的一个比较例子

表1给出了在不同指南中分段的例句。同时,WS方法逐渐从基于词典词典的最大匹配发展到从基于语言建模分数和其他统计的分词图到基于字符的序列标记,以减少递增解析。最近,神经网络模型也通过有效地学习角色和上下文的表示来取得成功

到目前为止,所有标记的数据集都采用单粒度形式化,而以前的研究主要集中在单粒度WS(SWS)上,其中一个单词序列中存在一个句子。虽然不同的WS准则具有相同的高级语言边界标准 - 一个字符串紧密结合并且使用稳定形成一个词,但人们在知识和生活环境等方面会大大降低个体差异。一位不愿透露姓名的评论者指出,布拉格学派的Vladiacute;mirSkalička声称,与法语和英语等“隔离”语言不同,中国人属于“多合成”类型,其中复合词通常是从本地语素中产生的。语素和化合物之间的模糊区别也促成了对词语概念的认知分歧。 Sproat等人的研究表明,中国母语人士的共识比例在没有经过共同指导方面培训的情况下仅为76%。为了填补这一空白,WS准则需要进一步将词汇分为多种类型,并为每种类型提供说明示例。尽管如此,即使是训练有素的注释者完全掌握准则并在未发现的案例中保持一致,这也是非常具有挑战性的。例如,Xiu(2013)(表1-3)显示,在SIGHAN Bakeoff 2005中使用的PPD训练数据中,大约3%的字符不一致地被分割。在这项工作中,我们还观察到所有MSR / PPD / CTB中存在许多不一致情况。总之,SWS对数据注释提出了很大的挑战,并且作为副作用,强制统计模型学习注释准则的微妙性,而不是真正的WS含糊不清。

从另一个角度来看,不同粒度的WS结果在信息检索(IR)和机器翻译(MT)等支持应用中可能是互补的。 一方面,粗粒度的单词使统计模型能够执行更精确的匹配和分析。 另一方面,精细的单词有助于减少数据稀疏并支持更深入的语言理解。

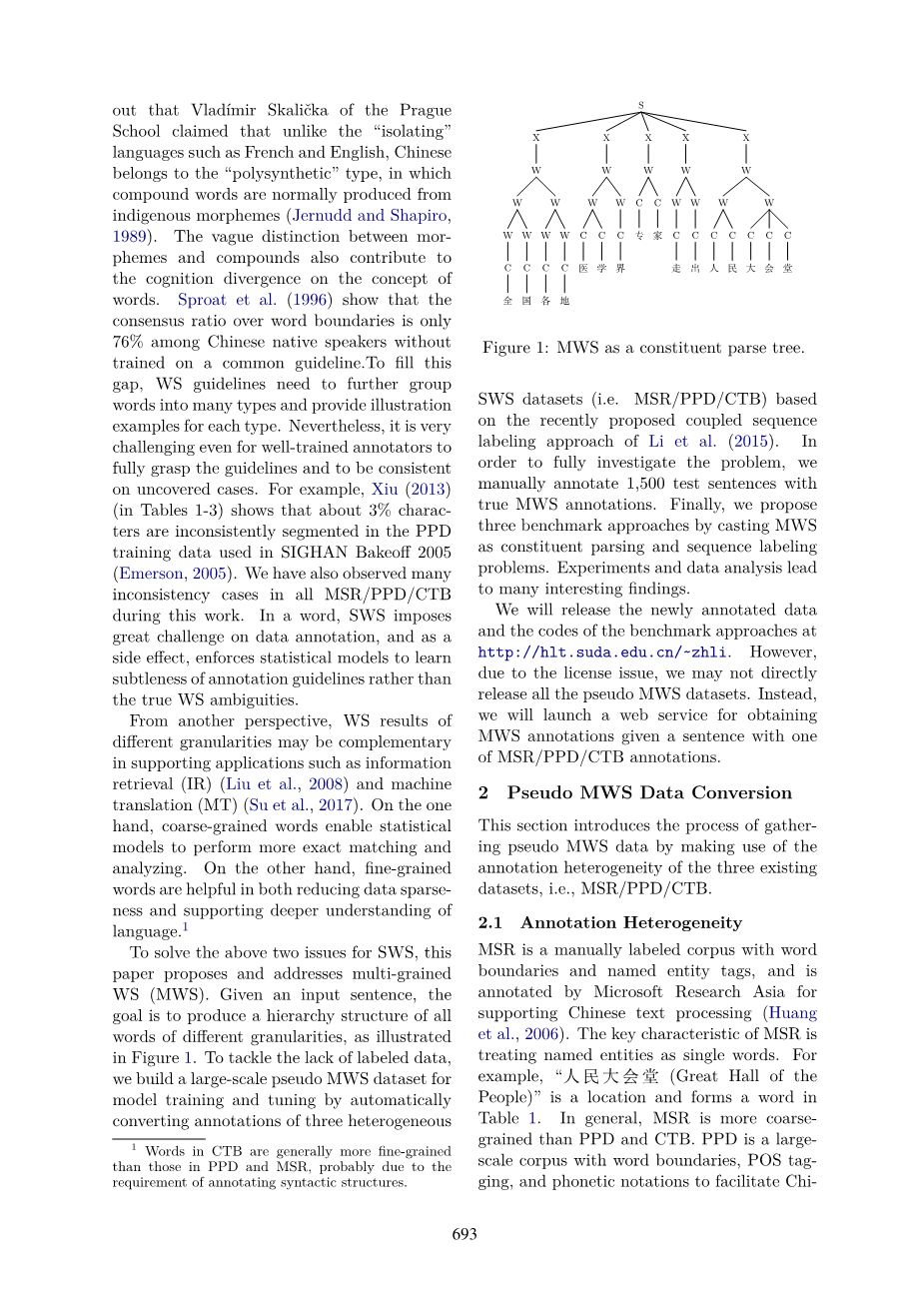

为了解决SWS的上述两个问题,本文提出并解决了多粒度WS(MWS)。 给定输入句子,目标是产生不同粒度的所有单词的层次结构,如图1所示。

图1:MWS作为组成分析树

为解决缺乏标记数据的问题,我们基于李等人最近提出的的耦合序列标记方法,自动转换三种异构SWS数据集(即MSR / PPD / CTB)的注释,从而构建了一个大型伪MWS数据集,用于模型训练和调整(2015年)。 为了充分调查问题,我们用真正的MWS注释手动注释1,500个测试语句。 最后,我们提出三种基准方法,将MWS作为组成分析和序列标签问题。 最终根据实验和数据分析发现了许多有趣的结果。

我们将在http://hlt.suda.edu.cn/~zhli发布新注释的数据和基准方法的代码。 但是由于许可问题,我们可能不会直接发布所有伪MWS数据集。 所以我们将启动一个Web服务,以获取MSS / PPD / CTB注释之一的句子,并获取MWS注释。

- 伪MWS数据转换

本节介绍通过利用三个现有数据集(即MSR / PPD / CTB)的注释异质性收集伪MWS数据的过程。

-

- 诠释异构性

MSR是一个带有单词边界和命名实体标签的手动标记语料库,由微软亚洲研究院注明支持中文文本处理。 MSR的关键特征是将命名实体作为单个单词处理。 例如,“人民大会堂(人民大会堂)”就是一个位置,并在表1中形成一个词。一般来说,MSR比PPD和CTB更粗糙。 北京大学计算语言学研究所注释了PPD是一个具有词边界,POS标记和语音符号的大规模语料库,以促进中文信息处理。 CTB的建立是为了创建一个带有句法包围的中文汉语语料库。 我们发现CTB在词边界上比MSR和PPD更加细化,因为句法注释往往需要更深入地理解句子。 例如,表5报告了每个语料库中每个单词的平均字符数,并证实了我们的观察结果。

为了更好地理解注释的异质性,我们总结了附录A中研究过程中观察和收集的三个数据集之间的高频差异。然而,要获得三个数据集之间的注释对应关系的完整列表是困难的,因为存在太多低频和不规则的情况。 此外,我们还观察到附录B中显示的所有三个数据集中的相同单词或具有相似结构的单词的许多不一致注释。

-

- 耦合WS转换:MSR / PPD为例

本节介绍如何通过利用MSR和PPD的两个非重叠SWS数据以及李等人的耦合序列标记方法,为MSR侧黄金标准WS标签的句子自动生成高质量PPD侧WS标签人。图2显示了工作流程。

图2:MSR / PP之间的转换

给定一个句子x = [c1,...,ci,...,cn],耦合模型的目的是产生一个捆绑标签序列t = ,其中和分别对应两个异构准则的两个标签。 表2给出了在MSR / PPD上耦合WS的示例。 我们采用标准的四标签标记符号边界的一个粒度,其中B,I,E分别表示关键字在字的开始,内部和结束位置,S代表一个单字符的字。 最下面一行显示黄金标准捆绑标签序列。

表2:耦合WS(MSR / PPD为例)

耦合模型的一个关键优势是直接从两个非重叠的异构训练数据集中学习,其中每个数据集只包含单侧黄金标准标签。 为了解决这个部分(或不完全)标签问题,他们通过考虑缺失端的所有标签,将每个单边标签投影到一组捆绑标签上,如表2的第二行所示。这种模糊标签用于模型监督。

在传统的CRF下,耦合模型将绑定标签序列的分数定义为

其中是联合特征,而是单独的特征。 李等人证明了联合特征捕获异构注释之间的隐式映射,而补偿分离特征可以弥补关节特征的稀疏性。

在他们对POS标签的案例研究中,李等人表明,在单个训练数据上训练的基线非耦合模型上,CTB5-测试中,耦合模式将标记精度提高了95.0-94.1 = 0.9%。

更重要的是,他们表明,耦合模型可以自然地用于注释转换任务,其中第二面标签会自动注释,给出一个黄金标准标签。 如表2所示,给定的单侧标签用于获得模糊标签,耦合模型在约束搜索空间中找到最佳捆绑标签序列,而不是整个捆绑标签空间,因此大大降低了难度。 李等人在其报告说,耦合模型可以提高POS标注的转换精度,比非耦合模型提高93.9 - 90.6 = 3.3%。

图3:生成伪MWS数据

-

- 生成伪MWS数据

图3显示了使用三个独立训练的耦合模型生成伪MWS数据的工作流程。 请注意,一个耦合模型能够在一对注释标准之间执行转换,因此三种注释标准需要三个耦合模型。 另一种选择是我们可以通过扩展Li等人的方法直接训练MSR / PPD / CTB上的一个耦合模型。 从两个指导方针转化为三个,这将导致更大的捆绑标签空间。 为了简单起见,我们直接在他们的工作中使用他们发布的代码,并留待未来的探索。

转换后,我们获得了9个伪MWS数据集(即MSR / PPD / CTBtrain / dev / test),并按层次结构表示每个句子,如图1所示。请注意,特定于指南的信息将被丢弃,因为 我们不关心哪个词属于哪个指南。 在产生的伪MWS数据中,我们发现大约0.08%的单词与其他单词重叠,这意味着在两个不同的注释中将字符串“ABC”分段为“A / BC”和“AB / C”。 我们已经手动检查了这些字词,并发现几乎所有这些情况都是由转换错误引起的。 这证实了我们将MWS作为层级结构的处理是合理的。

- 手动注释

为了全面调查MWS问题,我们已经手动创建了1,500个句子的真正MWS数据用于最终评估。 从表5中的每个测试数据集中,我们随机采样500个转换为伪MWS注释的句子进行手动校正。 首先,这项工作的两位合作者每天花费两个小时手动纠正伪MWS注释两周。 在此期间,我们总结了三个指南中高频率对应模式的清单(见附录A),并且还编写了一个简单程序,用于自动检测不同训练数据集中给定词的不一致注释,以便注释者可以使用输出 的程序来决定不明确的情况,我们发现这对于注释非常有帮助。

然后,我们聘请10位研究生作为我们的注释人员,他们对WS注释的熟悉程度不同。 在正式注释之前,注释者需要在MWS的基本概念,三项准则中的高频通信以及程序输出的使用方面接受两小时的培训。 我们还鼓励注释者直接访问三个训练数据集,以在真实环境下研究具体案例。 此外,还要求注释者在最终提交之前重新检查他们的注释以提高质量。

为了测量内部注释器一致性,150个句子(10%)被抽样用于双重注释,并且被四个批次分组为四对注释器。经过注释后,同一批中的两位注释者通过讨论来比较其结果并提交一致意见。

表3:手动注释前后MWS测试数据的数据统计

注释过程持续4天,每个注释者平均花费大约8个小时完成160个句子。 表3比较了手工注释之前和之后的1,500个句子的数据统计。 第二列报告单词的数量,最后三列按照其粒度级别报告单词的分布情况。 为了说明如何获得分布,我们以图1为例,其中包含1个单粒词,9个双粒词和7个三粒词。

表3显示,所有单词中只有71.6%是单粒度的,这与Sproat等人的说法一致性比率(76%)大致一致。(1996)。 在多字词中, 是二粒度的。 很显然,手工注释增加了= 1.5%的词数,并且增加的词的数量增加了74.5-71.6 = 2.9%。 事实上,在注释过程中,我们也认为虚拟MWS数据中多粒度现象的代表性不足。 原因可能是双重的。 首先,转换模型倾向于抑制粒度差

全文共8501字,剩余内容已隐藏,支付完成后下载完整资料

资料编号:[13653],资料为PDF文档或Word文档,PDF文档可免费转换为Word

以上是毕业论文外文翻译,课题毕业论文、任务书、文献综述、开题报告、程序设计、图纸设计等资料可联系客服协助查找。