英语原文共 7 页,剩余内容已隐藏,支付完成后下载完整资料

基于复杂条件下强化学习的自行式模型局部路径规划方法

摘要:在实际波浪条件下利用大型自航模型进行水动力和物理运动模拟试验是研究船舶环境适应性的重要手段。在自航模型的导航测试中,必须认真考虑包括各种港口设施,导航设施和附近船舶在内的复杂环境,因为在这种密集的环境中,海浪和风对模型的影响尤其显着。 为了提高自行式模型的安全性,本文将基于强化学习的Q learning与混沌理论相结合的方式引入模型的碰撞避免中,以提高局部路径规划的可靠性。 仿真和海试结果表明,该算法是海浪风浪干扰下自适应避碰的较好解决方案,具有良好的适应性。

关键词:自动推进模型;本地路径规划; Q learning ;避障;强化学习

1介绍

现代船舶的综合航行性能和环境适应性日益受到重视。 但是,船模试验不能完全模拟真实海况的影响。 另一方面,具有重大风险和危险的破坏性的真实船舶测试非常昂贵。 因此,在实际海洋环境中进行的大型自航模型(以下简称SPM)的试验成为研究船舶环境适应性的重要途径(Sun,2009)。 SPM的局部路径规划着重于控制SPM的方向和速度,以实现模型的自主非碰撞导航,同时确保安全导航和平稳的海况测试。 规划算法获取整体环境信息,然后计算从当前位置到模型目标的无碰撞路径(Manley,2008. Xu et al。,2007)。

由于局部路径规划是SPM安全导航和各种复杂测试的基础,因此研究了许多方法和算法。 Morphin算法是典型的算法(Simmons等,1996,Larson等,2006),它基于环境的网格模型。该算法首先沿船的两侧拍摄一系列弧线以覆盖整个前栅格,然后通过投票选择最佳弧线,根据弧线的半径确定导航速度。 Larson等人采用了基于局部环境信息感知的避障算法,即近场图(ND)方法。 (2007年)。考虑到船的高速和ND算法的跳跃输出,模糊逻辑对速度输出进行平滑,从而改进ND方法(Wang and Zhang 2012)。在其他论文中,动态窗口方法或DWA被用于各种无人地面车辆作为避撞算法(Tang等人,2011; Seder等人,2007; Ogren等人,2005)。 Chou和Lian(2011)采用的方法是一种典型的分治策略DWA,通过真船试验得到验证,取得了良好的效果。然而,这些方法并不考虑真实的导航环境,因此它们只适用于湖泊或宁静的港口。他们很难满足波浪和风力干扰在海上航行的SPMs。

针对上述算法存在的不满意,本文将offline learning引入到基于近场图的碰撞避免算法中。 通过在动作选择策略中增加一个混沌运算符来调整Q LEARNING,从而提高了SPM抵抗岸边海浪和风的干扰的能力。

2 SPM本地计划系统的结构

由于受到复杂海洋环境中的风,海浪等因素的影响,SPM可能偏离规划路径,同时避免碰撞。 SPM行动的改变可能会对模型的安全性造成不利影响。

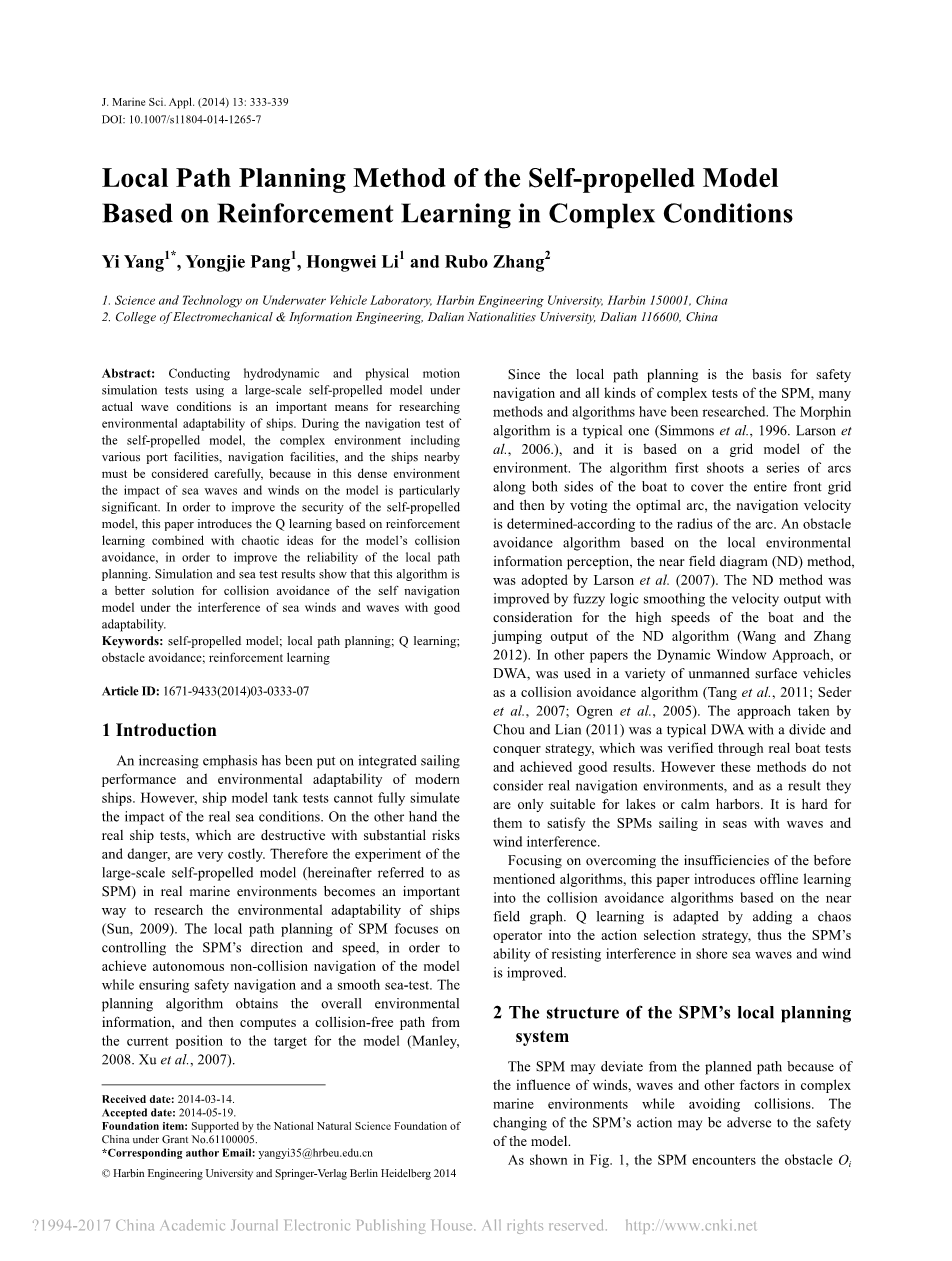

如图1所示,SPM在航行中遇到障碍物O. theta;guidance是来自本地路径规划器的顺序作为航向角度。 在正常情况下,SPM将执行该操作,从而成功避免Oi。 然而,由于海风和海浪的干扰,可以表示为theta;inf,SPM的航向角偏差,最终的航向角可能为theta;real,它由theta;inf和theta;guidance组成。 这可能导致SPM无法避免碰撞。 另外,风浪可能会干扰SPM的导航,影响SPM任务的有效性和效率。 因此,本文的基本思想是给出一个校正角omega;到theta;guidance,这使得新方向theta;正确。 然后,在theta;correct和theta;inf的双重效应下,SPM将前往theta;guidance。

图片1海风对自行式模型安全性的干扰作用

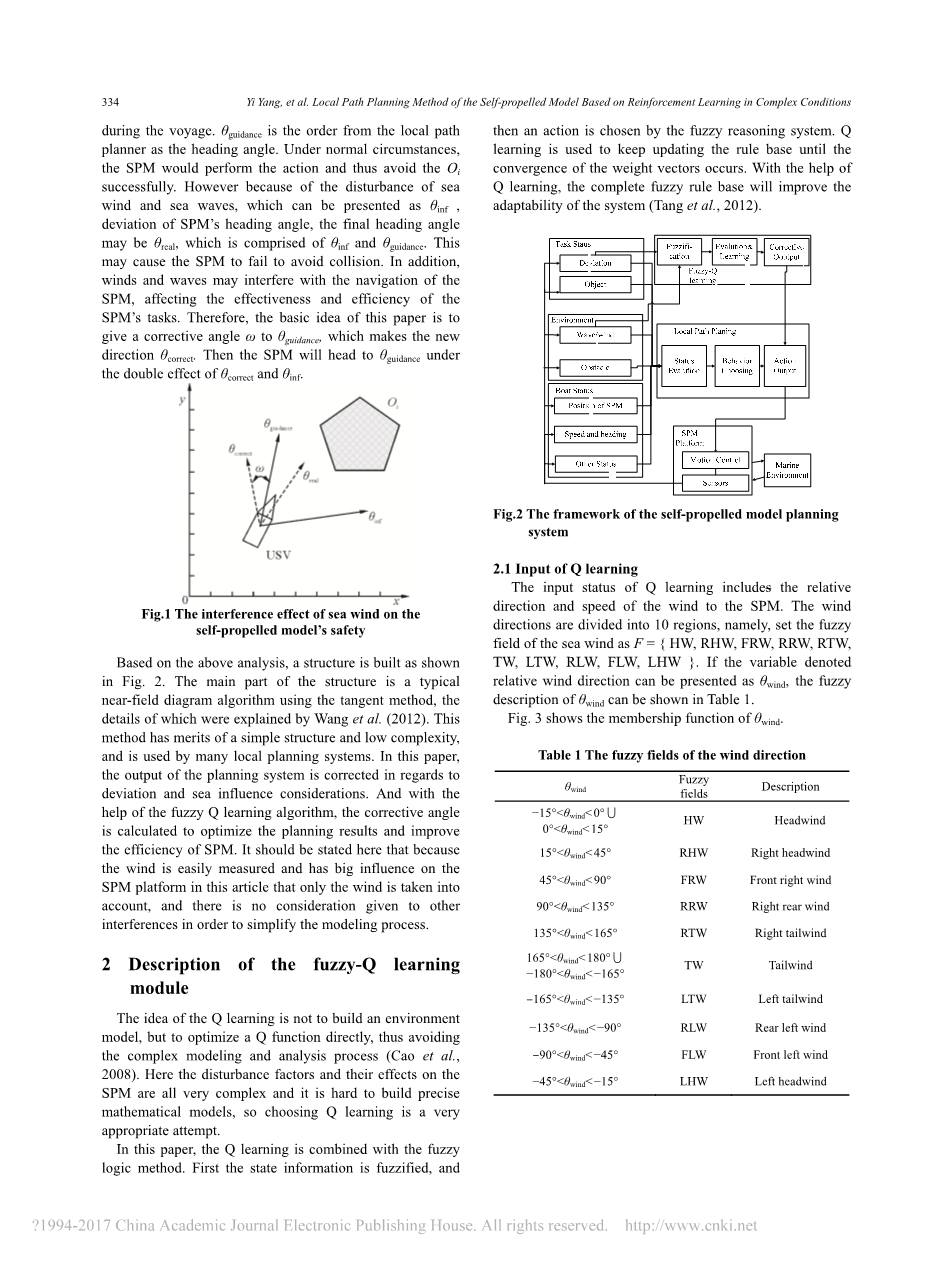

基于以上分析,建立了一个结构如图2所示。该结构的主要部分是一个典型的近场图算法,使用切线方法,其细节由Wang等人解释。(2012年)。 该方法具有结构简单,复杂度低等优点,被许多地方规划系统所采用。 在本文中,计划系统的输出在偏差和海洋影响考虑方面得到纠正。 在fuzzy Q learning算法的帮助下,计算校正角度以优化计划结果并提高SPM的效率。 这里要说明的是,由于本文中风速易于测量,对SPM平台影响很大,因此只考虑风,并且不考虑其他干扰,以简化建模过程。

2模糊fuzzy Q learning模块的描述

Q learning的思想不是建立环境模型,而是直接优化Q函数,从而避免复杂的建模和分析过程(Cao et al。,2008)。 这里干扰因素及其对SPM的影响都非常复杂,很难建立精确的数学模型,所以选择Q LEARNING是一个非常合适的尝试。

在本文中,Q LEARNING与模糊逻辑方法相结合。 首先,状态信息被模糊化,然后由模糊推理系统选择一个动作。 Q LEARNING用于不断更新规则库,直到权重向量的收敛发生。 在Q LEARNING的帮助下,完整的模糊规则库将提高系统的适应性(Tang et al。,2012)。

图片2自推式模型计划系统的框架

2.1 Q LEARNING的输入

Q LEARNING的输入状态包括风向SPM的相对方向和速度。 风向分为10个区域,即将海风的模糊场设为F = {HW,RHW,FRW,RRW,RTW,TW,LTW,RLW,FLW,LHW}。如果表示相对风向的变量可以表示为theta;wind,则theta;wind的模糊描述可以在表1中示出。

图片3 显示theta;wind的隶属度函数

图片3theta;风在局部坐标系下的隶属度函数

由于SPM的测试必须具有小于10 m / s的风速,因此风速分为4个模糊场,最大值为8 m / s。 让风速为vwind,其模糊场设为FV = {LA,LB,GB,MB},这意味着轻微的空气,微风,柔风和中风。 表2显示了vwind的模糊描述,以及波高。

图4显示了vwind的隶属函数。

应该注意的是,尽管海洋环境中的风稳定,SPM执行各种测试任务并且不断改变其航向和速度。 相对风向也会随之改变。 结果,模糊信息将大大简化算法。

2.2混沌理论Q LEARNING的行为和选择策略

如图1所示,Q LEARNING不是直接用来调整SPM的航向角,而是主要用来补偿输出角度,以减少干扰的影响。

因此,SPM的目标航向角是由ND算法获得的角度和Q LEARNING算法确定的补偿角度积分组成的。

SPM的输出为下一个时间周期的theta;correct角,而theta;guidance是从近场输出获得的角度,omega;是补偿输出Q LEARNING的角度,K是常数因子,作为经验常数。

补偿角度可以分为7个离散值,即-15°,-10°,-5°,0°,5°,10°和15°,构成Q LEARNING的动作空间。 动作选择模块必须通过随机输出动作来探索整个动作空间,然后通过更新选择策略来利用学习体验。 目前,有很多方法可以实现随机动作选择; 本文中使用的混沌算法是一个相对较好的算法。

混沌在数学上定义为由非线性确定性系统产生的半随机性行为(Sun,2009)。 混沌优化算法可以遍历其特定范围内的所有状态空间而无需重复,

同时不需要连续或可区分的问题模型。 对比实验表明,混沌最优比普通随机搜索方法具有更好的搜索效率(Sun et al。,2007)。 这里选择逻辑图,其等式显示在式(2)。

其中mu;是控制变量,f(mu;,xn)是非线性函数。 随着mu;的不同,系统将具有不同的特性。 在本文中,选择了下面的混沌映射,如方程(3)。

混沌算法的基本步骤如下:步骤1:令k = 0,然后用随机函数随机生成N个混沌变量xk(n = 1,2,...,N),其中n 表示混沌变量的数量,k表示混沌搜索的数量。

步骤2:通过根据方程式将xnk映射到值区间[a,b]来计算状态变量Snk。 (4),其中a和b是状态变量的范围

步骤3:k = k 1,并根据等式(3)更新x k。

步骤4:重复步骤2和步骤3,直到访问完所有状态。

在Q LEARNING开始时,可以选择许多动作并且需要遍历动作空间。 所以这里使用混沌算法来探索定义的整个动作状态。 由于有7个补偿角,因此公式(4)中的a可定义为0,b定义为7。 因此,在任何情况下,混沌算法的结果都是0到7之间的数字,可用于选择相应的动作。 随着混沌算法的多样化,每个动作都可以在学习的早期阶段进行选择,并且Q值会经常更新,从而最大限度地探索状态空间。

经过一段时间的学习后,学习获得当前学习结果,此处为操作的Q值指定一个范围。 如果Q值在该范围内,则意味着探索阶段结束并且ε-贪婪将取代混沌算法作为动作选择策略。 这不仅会以较大的概率利用勘探过程的学习经验,而且还会在一定程度上采取劣化解决方案。 开发阶段的设计可以避免局部最优,也可以以一定的概率检测最优整体解空间。 这里ε可以从实验中获得,并调整到恒定值。

2.3奖惩信号

奖励和惩罚信号可以由SPM的当前航向角度和计划角度之间的差异来决定。 如果差别不大,会有奖励信号; 否则如果差异太大,会有惩罚信号。 但是,偏差的变化也可以用作评价标准,而且更客观。 除了在复杂的海洋环境中,即使SPM遵守规划顺序,它仍然可能偏离规划轨道和目标路径点。 因此,目标点的误差可以作为判断动作效果的关键,因为它也反映了算法的补偿能力。

现在定义theta;t,theta;* t-1,Lt,L * t-1,其中theta;t表示时间t时SPM的航向角,theta;* t-1表示时间t-1时的计划航向角,Lt 意味着时间t处SPM的位置,而L * t-1意味着时间t-1处的位置。 这些变量用于方程(5)和(6)来评估行动选择的影响。

其中delta;theta;表示方位角的误差,delta;L表示SPM距计划点的偏差距离。 方程(5)和(6)的值可以用来确定奖励和惩罚信号。 例如,当delta;theta;为0时,意味着SPM的当前航向角度与规划角度相同,应该得到奖励。 当delta;theta;的绝对值在公差范围内(即1°lt;|delta;theta;| lt;10°)时,不应该是奖励或惩罚。 当delta;theta;超过公差范围(即|delta;theta;|gt; 10°)时,表示航向角度已经偏离规划角度,应该受到惩罚。 这里的公差范围可以通过实验获得。 delta;L可以用相同的方式处理。

2.4Q-table和更新

状态空间和行为空间已被定义,因此可以获得Q-TABLE。 但是由于已经定义了4个风速状态和10个风向状态,并且有7个动作状态,所以最终的Q-TABLE具有280个单元。 表4显示了选择操作0时的状态的初始Q值。

具有正的和大的初始Q值的动作通常将以更高的概率得到选择。 在混沌算法的帮助下,动作空间将被遍历。

其中alpha;t是学习率,rt是奖励/惩罚信号,gamma;是即时贴现因子。 在本文中,设alpha;t= 0.005,初始gamma;= 0.85,这是从经验中获得的。

为了简化Q-TABLE的更新,引入了类似状态的概念。 通常不会发生海风方向的突然和巨大变化,同样的风速也不会立即发生显着变化。 假定在一个计划周期时间内,风速只增加或减少一个单位是合理的。 此外,风向只能使一个单位的变化向左或向右。

定义1:如果风速现在处于状态i,风向状态为j,则风状态为Sij。 那么,Sij的相似状态如下:Si j 1,Si j-1,Si 1 j和Si-1 j,其中0le;ile;3,0le;jle;9。

例如,状态S11的类似状态是S01,S10,S21和S12。 S16的相似状态是S06,S15,S26和S17。 据分析,类似状态之间存在连续性。 因此可以假设,如果在作用于状态Sij之后获得一个回报信号rt,则相似状态Si j 1,Si j-1,Si 1 j和Si-1 j可以得到 相应的奖励类似,如方程(9)。

3 实验和分析

3.1 模拟平台

仿真平台的硬件包括三部分:监控开发平台,智能计划与控制平台,视觉仿真平台。监视器和开发平台建立在PC上,在PC上运行开发软件工具和监视系统。该监视器系统由Microsoft Visual C 6.0开发。系统将任务订单发送给SPM,同时从船上的计划和控制系统接收SPM和任务信息。监控和开发平台也安装了Wind River的Tornado,用于开发计划系统。计划和控制平台建立在PC / 104嵌入式系统上,其上运行基于Vxworks的计划和控制程序。规划和控制计划获得任务订单并向船提供控制指令,同时处理来自船载传感器的各种环境信息。视觉模拟平台负责模拟SPM和海洋环境,包括传感器,设备,障碍物和海风。建立在Multigen Vega上的仿真系统用于最终生成SPM及其水上任务的仿真场景。仿真系统的结构如图5所示。

3.2 模拟结果和分析

我们的计划是在模拟环境中测试算法,并尽可能地运行学习过程。 因此,当涉及到真正的海上测试时,所学的参数可立即产生效果,在真正的海风和其他干扰下没有碰撞危险。 另一方面,无法构建让SPM产生影响甚至进行数千次学习的障碍,这在学习过程中是不可避免的。 所以我们最好在模拟和实船测试中学习。

lt;

全文共6646字,剩余内容已隐藏,支付完成后下载完整资料

资料编号:[16100],资料为PDF文档或Word文档,PDF文档可免费转换为Word

以上是毕业论文外文翻译,课题毕业论文、任务书、文献综述、开题报告、程序设计、图纸设计等资料可联系客服协助查找。