英语原文共 9 页,剩余内容已隐藏,支付完成后下载完整资料

面向自动驾驶场景的多视图三维目标检测网络

Xiaozhi Chen1, Huimin Ma1, Ji Wan2, Bo Li2, Tian Xia2

1 Department of Electronic Engineering, Tsinghua University

2 Baidu Inc.

{chenxz12@mails., mhmpub@}tsinghua.edu.cn, {wanji, libo24, xiatian}@baidu.com

摘要

这篇文章旨在介绍一种面向自动驾驶场景的高精度3D目标检测方法。我们提出了多视图3D网络(MV3D),一种以激光雷达点云和RGB图像作为输入,然后预测物体有向3D边界框的传感融合框架。我们将稀疏的3D点云编码为稠密的多视图。该网络由两个子网络组成:一个子网用于生成候选3D边界框,另一个子网用于多视角信息的融合。推荐网络有效的从点云的鸟瞰图上生成3D候选边界框。我们设计了一种深度融合的方案,以结合多个视图中的区域特征,并实现不同路径中间层之间的融合。在KITTI的基准测试中的,实验表明我们方法在3D定位任务中的准确率比当前最新的方法高大概25%,在3D检测任务中高大概30%。另外,在基于激光雷达的2D目标检测任务中我们方法的准确率也比当前最新的办法高出10.3%.

1.介绍

3D目标检测在自动驾驶汽车的视觉感知系统中占有重要地位。现代自动驾驶汽车通常装有多种传感器,比如激光雷达和摄像头。激光扫描器具有能够获得准确深度信息的优点,而摄像头则保留有更加详细的语义信息。激光雷达点云和RGB图像的融合能够帮助实现更高性能和安全性的自动驾驶汽车。

本文的重点是同时利用激光雷达和图像数据进行3D目标检测。我们希望在道路场景下获得高精度的3D定位和物体识别。最新基于激光雷达的方法将3D窗口放置在3D体素网格中来对点云进行打分[26,7]或者将卷积网络应用到稠密的点云前视图上获得边界框预测[17]。基于图像的方法通常先生成3D提议边框然后使用Fast R-CNN[10]进行区域的识别。基于点云的方法通常能够获得的更加准确的3D位置,而基于图像的方法则在2D边界框的评估中有更高的准确率。[11,8]通过激光雷达和图像的早期融合和晚期融合进行2D检测。但是对于更加具有挑战性的3D目标检测任务,一个设计良好的模型需要能够充分的利用各个模态的优势。

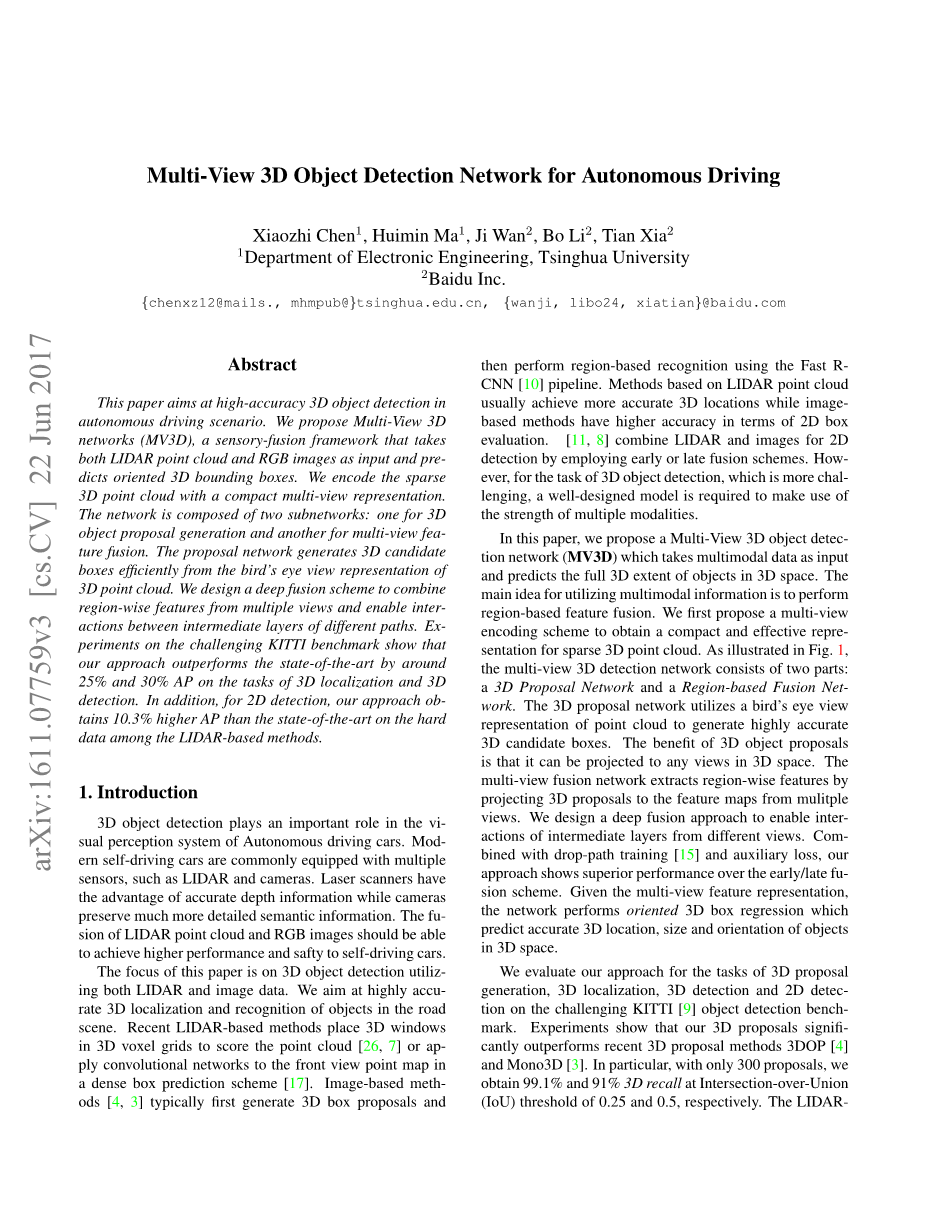

在本文中,我们提出了一种多视图3D目标检测网络(MV3D),该网络以多种模态数据作为输入然后在3D空间中预测目标完整地三个维度的位置。该网络的主要思想是利用多模态信息进行区域特征的融合。我们首先提出一种多视图的编码方法,以获得稀疏点云紧凑有效的表示。如图1所示,该多视图3D目标检测网络由两部分组成:分别是3D提议网络和区域融合网络。该3D提议网络利用点云的鸟瞰图去生成高精度的3D候选边界框。这种3D目标提议的好处是能够投影到3D空间的任何视图中。多视图融合网络通过将3D提议边界框投影到多个视角的特征图中来提取区域特征。我们设计了一种深度融合的办法,以实现来自不同视图的中间层的融合。结合下降路径训练[15]和辅助损失,我们的方法表现出优于早期和晚期融合方法的性能。提供多视图地特征表示,网络将定向回归3D边界框以在3D空间中准确预测目标的3D位置,尺寸和方向。

我们在具有挑战性地KITTI目标检测测试基准[9]中地3D边界框提议生成,3D检测和2D检测任务中对我们的方案进行了评估。实验表明我们在3D边界框提议生成中明显优于最近的3D提议方法如3DOP[4]和Mono3D[3]。特别是只使用300个提议地情况下,我们就在IOU阈值为0.25和0.5时分别获得了99.1%和91%的召回率。我们方案基于激光雷达的变体在3D定位任务中提升了约25%的精度,在3D目标检测任务中提高了约30%的精度。在KITTI的困难难度目标检测中我们的方案仍然超过了其他方法10.3%的精度。当与图像结合时,将相对于基于激光雷达的结果获得进一步的改进。

图1:多视图三维目标检测网络(MV3D):该网络以激光雷达点云的鸟瞰图和正视图以及图像作为输入。它首先从鸟瞰图生成3D边框提议,并将它们投影到三个视图中。深度融合网络用于合并通过ROI池化获得的每个视图的区域特征。将融合后的特征用于目标的联合分类和有向的3D边界框回归。

2.相关工作

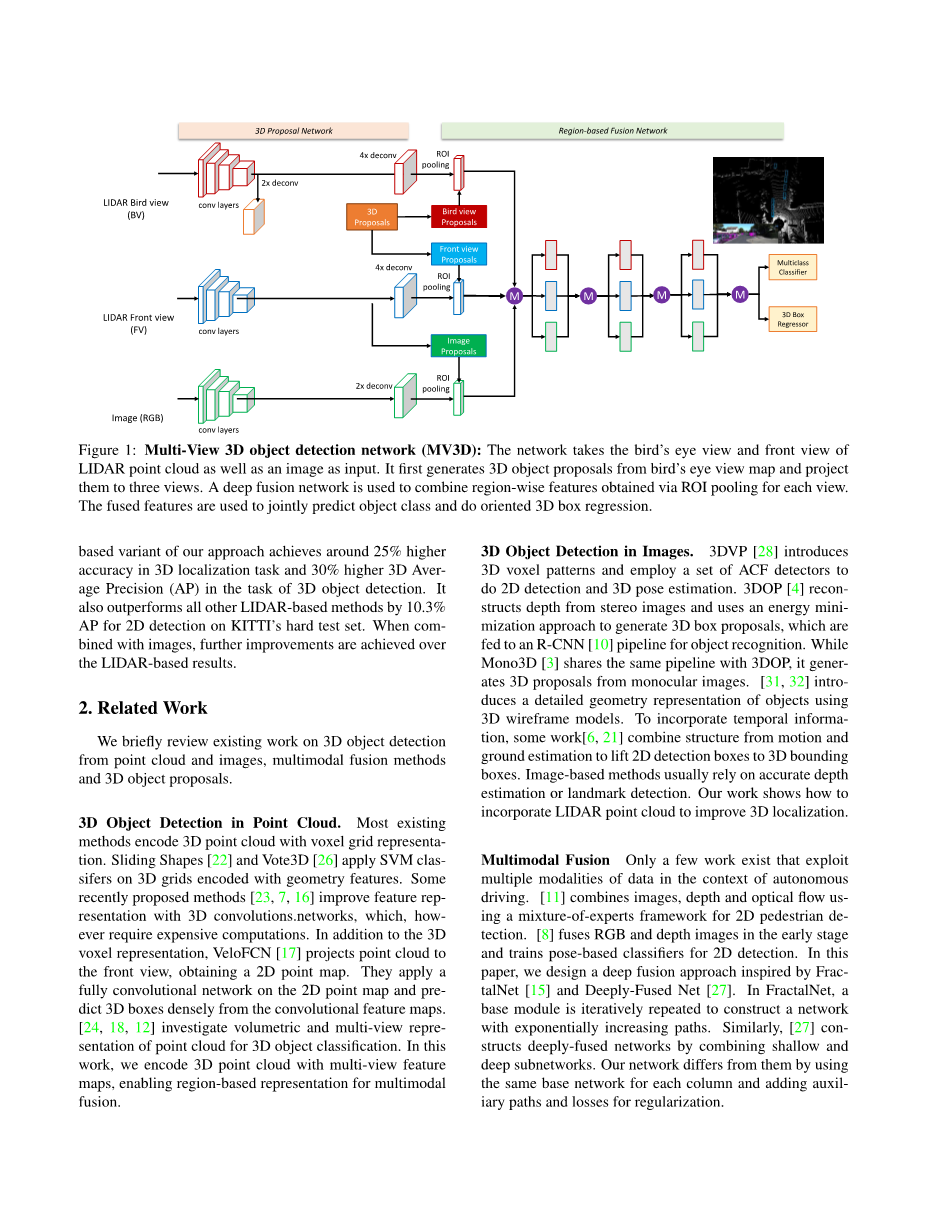

我们简要回顾了一些基于点云和图像进行3D目标检测,多模态融合和3D目标提议的现有工作。

点云中的3D目标检测。当前大多数方法将3D点云编码为体素网格的表现形式。Sliding Shapes[22]和Vote3D[26]将SVM分类器应用到编码为3D网格中地几何特征。一些最近的提议方法[23,7,16]通过3D卷积来提升特征表达。另外对于3D体素表达,VeloFCN[17]将点云投影到前视图来获得2D图像。他们将全卷机网络应用到2D图像中来通过卷积特征图预测3D边界[24,18,12]研究了点云立体和多视图表示用于3D物体的分类。在该工作中,我们将3D点云编码为多视角特征图,实现了多模态融合的区域表示。

图像中的3D目标检测。3DVP[28]引入了3D体素模式并将一组ACF检测器应用于2D检测和3D位置估计。3DOP[4]从立体图像中重建深度,利用能量最小的方法生成3D边界框提议,然后送入到R-CNN中进行目标检测。虽然Mono3D[3]和3DOP基础框架相同,但是它是从单目图像中生成3D边界框提议。为了融合时间信息,一些工作[6,21]将运动和地面估计结合起来,将2D边界框提升为3D边界框。基于图像的方法通常依赖于精确的深度估计和标志点检测。我们的工作展示了如何结合点云信息去提升3D定位效果。

多模态融合。在自动驾驶环境下只有少数方法使用了多模态数据融合.[11]利用一个专家混合框架结合了图像,深度和光流进行2D行人检测。[8]在早期融合了RGB和深度图像然后训练了基于姿势的分类器用于2D检测。在本文中,我们受FractaNet[15]和Deep-Fused Net[27]的启发设计了一种深度融合的方案。在FractaNet中,迭代重复构造一个基础模块构成的网络路径数量成指数级的提升。同样的,[27]通过浅层子网络和深层子网络构造了深度融合网络。我们的网络与它们的区别在于每列使用相同的基础网络,并通过添加辅助路径和损失以进行正则化。

3D目标提议。与2D目标提议[25,33,2]类似,3D目标提议会生成一小组3D候选边界框以覆盖3D空间中的绝大多数目标。为此,3DOP[4]设计了一些特征路径来为立体点云中的大量3D候选边界框打分。Mono3D[3]先利用地面先验知识进行分割从单幅图像中生成一些3D提议边界框。3DOP和Mono3D都使用了手工设计的特征。Deep Sliding Shapes[23]使用了更加强大的深度学习特征。但是,它需要运行在3D体素网格上并且使用计算力昂贵的3D卷积。我们提出了一种更加有效的办法,通过将2D卷积应用在点云的鸟瞰图表示上生成准确的3D边界框提议。

3.MV3D网络

该MV3D网络将点云的多视图与图像作为输入。它首先从鸟瞰图上生成3D提议边框然后深度融合多视图的区域特征。融合的特征用于边框的分类和有向3D边框坐标的回归。

图2,MV3D网络的输入特征

3.1 3D点云表示

现有地方法通常将3D激光雷达点云编码为3D网格[26,7]或前视图[17]。尽管3D网格表示保留了点云的大部分原始信息,但在随后的特征提取中往往需要更加复杂的计算。我们提出了将3D点云投影到鸟瞰图和前视图上以获得一种更加紧凑表示方法。图2展示了该种点云表示方法。

鸟瞰图表示。鸟瞰图由高度,强度和密度编码而成。我们将投影的点云离散成分辨率为0.1m的2D网格。每个单元中高度特征是由单元格中最高的点计算而来地。为了编码更加详细的高度信息,点云被等分为M片。每片分别计算一个高度特征图,因此我们获得了M个高度图。强度特征是每个单元中具有最大高度的点的反射强度值。点云的密度特征则表明了每个单元格中点云的个数。为了对特征进行归一化,密度特征被计算为),N是单元格内点云的个数。需要注意的是强度和密度特征是针对整个点云计算的,而高度是针对M个切片分别计算的,因此鸟瞰图被编码为(M 2)个通道特征。

前视图表示。前视图表示为鸟瞰图表示提供了补充信息。由于点云数据十分稀疏,因此将其投影到图像平面会形成稀疏的2D点图。作为代替,我们将它投影到圆柱表面以形成密集的前视视图[17].给定3D点,其在前视图中的坐标可以通过公式(1)计算

其中和是激光雷达的水平和纵向分辨率.我们通过高度,距离和密度三个通道的特征进行编码获得前视图,如图2所示。

3.2 3D提议网络

受已经成为最先进的2D目标检测网络[19]的关键部件区域推荐网络(RPN)的启发,我们首先设计了一个3D目标提议网络。我们将鸟瞰图作为输入。在3D目标检测中,鸟瞰图相对于前视和图像平面有多种好处。首先,物体在投影到鸟瞰图时会保持物理尺寸,因此尺寸变化很小,但在前视图和图像平面上并非如此。其次,鸟瞰图中的物体占据了不同空间,从而避免了遮挡问题。第三,在道路场景下,由于对象通常位于地平面上且垂直位置的变化很小,因此鸟瞰图位置对于获取准确的3D边界框至关重要。因此,使用特殊的鸟瞰图作为输入会使3D位置预测更加可行。

提供一个鸟瞰图。该网络会从一组3D先验边框中生成3D提议边框。每个边界框均由参数化,这些参数是激光雷达坐标系中3D边界框的中心和大小(以m为单位)。对于每个3D先验框,可以通过离散化来获得相应的鸟瞰图锚。我们通过在训练集中聚类真实物体的大小来设计了N个3D先验框。在汽车检测中,先验框中取,然后 被设置为1.56m。通过将鸟瞰图锚点旋转90度,我们可以获得N=4个先验框。是在鸟瞰特征图中变化的位置,并且 可以通过相机和物体高度计算。我们不在提议框生成阶段进行边框方向的回归,而是将它留给接下来的预测阶段。3D边框的方向被限制为,这与大多数道路场景下的实际方向很接近。这种简化的提议方案使提议边框的回归训练变得更加容易。

图3:不同融合方案的架构:我们用级联操作实例化早期/晚期融合中的连接节点,用元素平均操作实例化深度融合。

离散化的分辨率为0.1m,鸟瞰图中的目标边框仅占5-40个像素。检测这么小的目标对于深度网络来说仍然是一件困难的事情。一种可行的解决方法是输入使用更高的分辨率,但是这样也会需要更高的计算力。我们选择类似[1]一样在特征图上使用上采样。在提议网络的最后一个卷积层后面我们使用了2倍的双线性上采样。在我们的实现中,前端卷积仅使用了3次池化操作,也就是8倍下采样。因此,结合2倍的逆卷积,送入到提议网络的特征图相对于鸟瞰图降低了4倍的采样率。

我们类似于RPN[19]通过对进行回归获得3D边界框的回归。是通过对锚尺寸标准化的中心偏移量,通过 计算得到。我们使用多任务损失去同时分类物体和背景以及对3D边框进行回归。特别的,我们将分类损失函数用于目标损失,Smooth L1[10]用于3D边框回归损失。背景边框在计算边框损失时忽略。在训练期间,我们计算预测边框与地面鸟瞰图真实边框之间的重叠度。如果边框的重叠度大于0.7则认为该边框为正,如果边框的重叠度小于0.5则认为该锚点为负。重叠度在这之间的边框被忽略。

由于激光雷达点云是稀疏的,也就导致出现了很多空边框,我们在训练和测试期间去掉了所有空边框以减少运算量。这可以通过在点云占用图上计算图像积分获得。

对于最后一个卷积特征图上每个位置上的非空边框,网络均生成了一个3D边框。为减少冗余,我们对鸟瞰图上的边框使用了非极大值抑制(NMS)。不同于[23],我们没有使用3D边框的非极大值抑制,因为不同物体在地平面上应该占据不同的空间。我们将非极大值抑制的IOU阈值设为0.7。在训练期间我们会保留前2000个边框,但在测试中我们只会使用前300个边框。

图4:基于区域的融合网络的训练策略:在训练过程中,加入倒数第三条路径和损失,使网络正规化。辅助层与主网络中的相应层共享权重。

3.3 基于区域的融合网络

我们设计了一个基于区域的融合网络,以有效地组合来自多个视图的特征,并共同对提议边框进行分类和对边框进行定向回归。

多视角感兴趣区域池化。由于来自不同视图和模态的特征通常具有不同地分辨率,我们对每个视图进行ROI池化[10]以获得相同长度的特征向量。提供生成的3D边框提议,我们将他们投影到3D空间的每个视图中。在我们的例子下,我们将它投影到三个视图中,即鸟瞰图(BV),正视图(FV)和像平面(RGB)。提供3D边框提议 ,我们通过公式(2)计算获得ROIs

其中 表示激光雷达坐标系到鸟瞰图,正视图和像平面各自的转换函数。给定每个视图的前端网络的输入特征图x,我们通过公式(3)获得固定长度的特征

图5:3D边界框召回率:从左到右:召回率vs 使用300个提议边界框时不同的IoU阈值,召回率 vs 在IoU阈值分别为0.25和0.5时使用不同数量提议边界框。根据KITTI验证集的中等难度数据评估召回率。

深度融合。为了结

剩余内容已隐藏,支付完成后下载完整资料

资料编号:[236433],资料为PDF文档或Word文档,PDF文档可免费转换为Word