英语原文共 24 页,剩余内容已隐藏,支付完成后下载完整资料

一篇关于支持向量机的教程

在这个教程里面,我们将给出一个关于用于进行回归预测的支持向量机的基本原理的概述,此外,我们也罗列出了当下流行的,用支持向量机来做回归预测的算法和处理大数据的先进的方法。最后,我们也提到了一些对标准支持向量机算法的改进和扩展,并且以支持向量机的角度讨论了正则化方面的问题。

关键词:机器学习 支持向量机 回归预测

1.简介

这篇文章的目的有两个。一方面,它可以作为刚刚进入用支持向量机预测这个高速发展的研究领域的自学参考资料,另一方面,这篇文章也想对支持向量机这一领域的最新发展做一个概述。

我们决定以如下的形式组织这篇文章。我们以给出关于支持向量机技术的概述作为开篇,这些内容在第一,二,三节中,第四节用一些数据和图表给出了一个简单的结论。第五节展示了应用支持向量机的最新算法。这可能是实践者最感兴趣的部分。在这之后的章节囊括了更先进的内容,比如对基础支持向量机算法的扩展,支持向量机和正则化之间的联系,和对模型选择方法的简要概述。最后,以一个关于支持向量机方法的问题和方向的讨论结束。在这篇文章里的大部分结果已经在别处发表,但是有一些综合问题介绍和一些细节是新的。

1.1历史背景

支持向量机最初是一种一般化线性算法,它在60年代出现在俄罗斯(Vapnik and Lerner 1963, Vapnik and Chervonenkis 1964)。支持向量机以vc维为坚实的理论基础,在过去的三十几年中不断的发展。在最近几年中,贝尔实验室的瓦普尼克和他的同事们不断地使支持向量机得到发展(Boser,Guyon andVapnik 1992, Guyon, Boser andVapnik 1993, Cortes and Vapnik, 1995, Schuml;olkopf, Burges and Vapnik 1995, 1996, Vapnik, Golowich and Smola 1997)。最初它用于文字识别,在很短的一段时间之后的1996-1998年,支持向量机分类器已经可以和最好的可用的文字识别,物体识别系统竞争(Schuml;olkopf, Burges and Vapnik 1996, 1998a, Blanz et al. 1996, Schuml;olkopf 1997).。1998年,伯吉斯已经发表了一篇关于支持向量机分类器的全面的指导。此外,支持向量机在回归问题和时间序列预测上也很快获得巨大成就(Muml;uller et al. 1997, Drucker et al. 1997, Stitson et al. 1999, Mattera and Haykin 1999)。在1999年神经信息处理系统年会上,支持向量的方法被简单的提及到(Schuml;olkopf, Burges, and Smola 1999a)。支持向量已经进化为一个活跃的研究领域。此外,支持向量正在成为机器学习的标准工具箱(Haykin 1998, Cherkassky and Mulier 1998, Hearst et al. 1998)。

1.2基本思想

假设我们有一组训练数据{(x1, y1), . . . , (x_, y_)} sub;X times;R, ,这些可能是以天数和经济学指标判断的货币汇率。在ε-SV回归模型中,我们的目标是寻找一个函数,由训练集数据得到的函数值相对于真实的数据y的最大误差不超过ε,换句话说,当误差小于ε时是允许的,但是不能有任何大于ε的偏差。我们从介绍线性函数开始,

f (x) = (w, x) b with w isin; X, b isin; R (1)

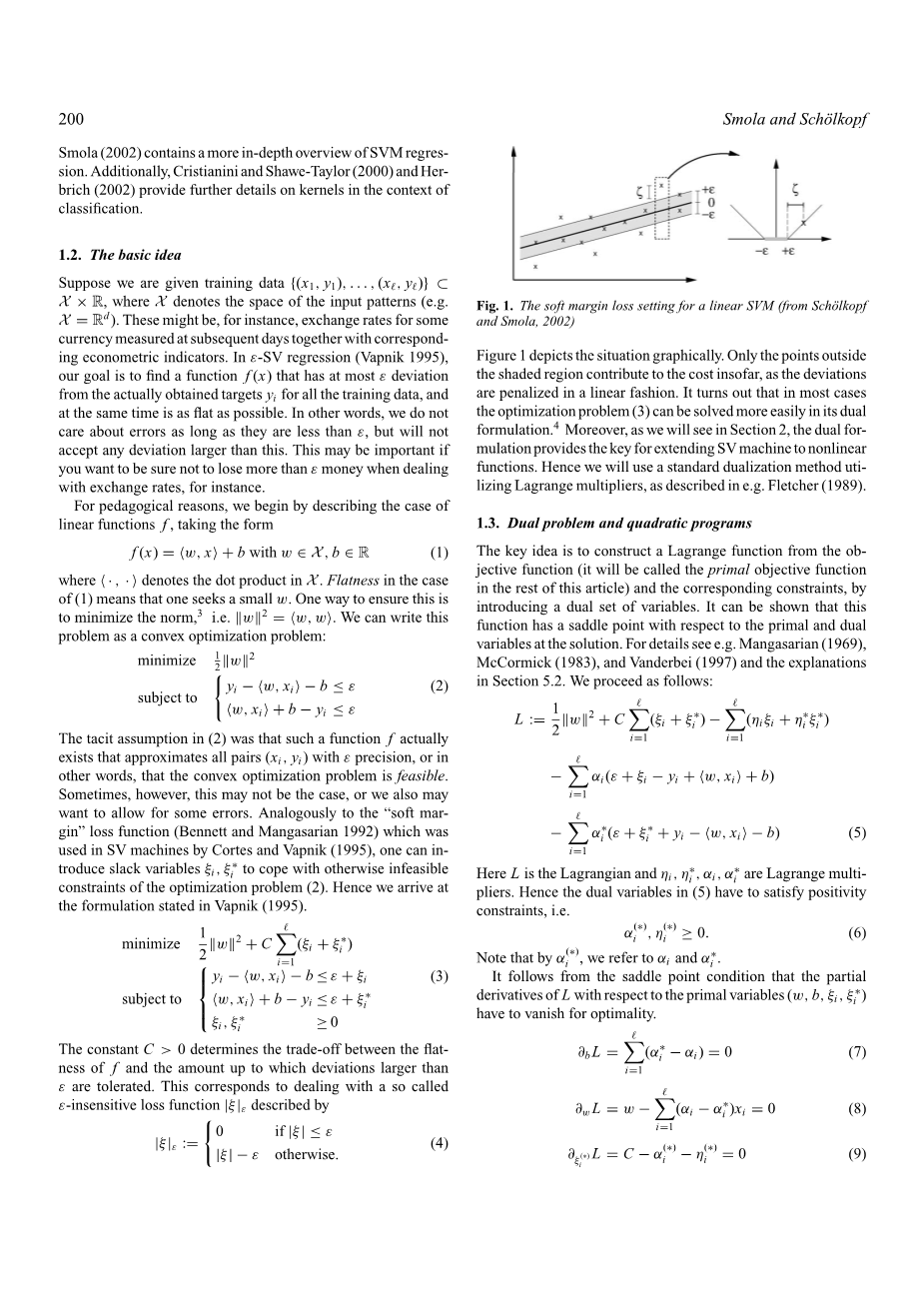

其中括号里的逗号表示点积,在式1中,我们想要找到一个最小的w,一种方法是保证w的范数最小,我们可以把这个问题,转化成一个凸规划问题:

可以想象,的却存在这样的函数使每一个因变量在ε的范围之内,换句话说,这个凸规划问题是可实现的。但是有些时候不是这种情况,我们也会允许一些误差,类似于科尔特斯和瓦普尼克提出的用于支持向量机i的软间隔损失函数,这种函数引入了松弛变量xi;i, xi;i主要来处理其它一些不可实行或者难以计算的规划问题。

常数C表示可以容忍的最大误差减去ε的值,这似于处理不敏感损失函数|xi;|ε,|xi;|ε这样表示:

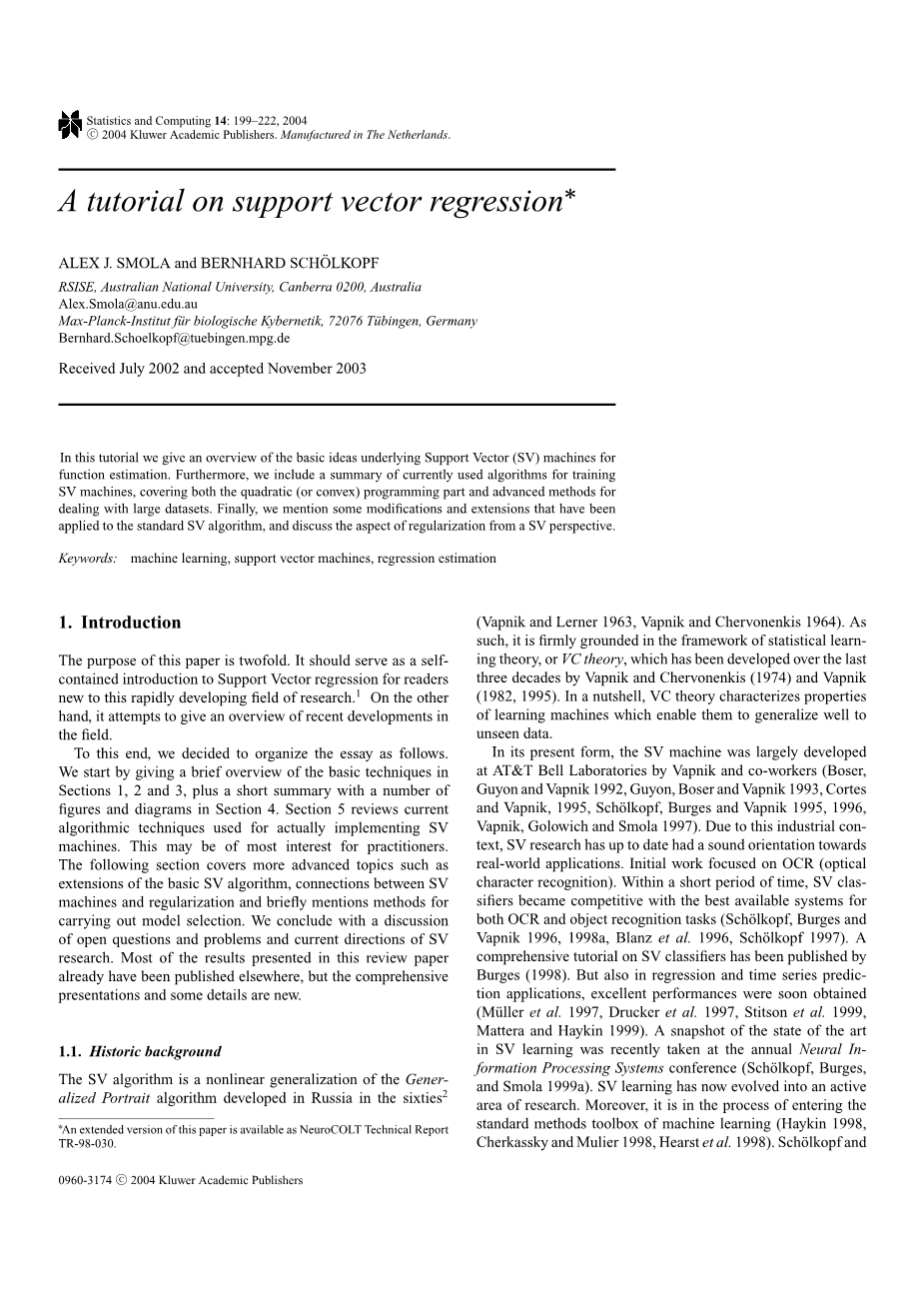

图一形象地描绘了这一函数,当误差小于ε时误差被忽略不计,当误差大于ε时函数值等于误差值减去ε,换言之,这种误差函数中间有一个宽度为两倍ε的不敏感带。这表明大多数情况下凸规划问题可以转化为更简单的对偶问题。此外,在第二节当中,我们还将看到,求解对偶问题为支持向量机的由线性向非线性化的扩展提供了方法。

1.3对偶问题和二次规划问题

其核心思想是;通过引入一系列对偶变量,对目标函数构造拉格朗日函数和相应的约束条件。这表明,在这种情况下,存在关于原始变量和对偶变量的鞍点。公式如下:

式中,L代表拉格朗日算符,eta;i, eta;lowast;i , alpha;i, alpha;lowast;i是拉格朗日乘数。对偶变量也必须满足约束条件,即:

对它们求偏导数,并令偏导数等于0

带入(7),(8),(9)得到对偶最优化公式。

通过(10)我们已经将对偶变量消除掉了公式(8)可以写成

这就是所谓的支持向量,w完全可以被描述为训练模型x的线性组合。从某种意义上讲,这个函数表达式的复杂程度,不受输入样本x的维数的影响,而只由支持向量的数量来决定。此外,需要注意的是,这个完整的算法也可以被由数据之间的点积所描述。甚至,当我们估计f(x)时,不需要精确的计算出w。这些发现将会在向非线性形式推广中派上用场。

1.4计算b

到现在为止,我们忽略的计算b的过程,它可以利用KKT条件来求出(Karush 1939, Kuhn and Tucker 1951).,公式如下:

根据这个公式,我们可以得出一些有用的结论,首先,只有对应于a=c的样本(x,y)会留在ε管道之外,其次,aa*=0,这说明任何样本(x,y)在两个方向上的松弛变量不能同时非零。通过这些,可以得出结论:

与a*联立可得:

2 核函数

2.1用于非线性化的预处理

下一步是要将支持向量机算法推广到非线性化,这可以通过一个映射,将样本空间映射到一个高维的特征空间,使原来的非线性问题,在高维特征空间变成线性可解的问题,从而可以在高维特征空间中应用线性svm方法。将数据映射到特征空间以便更有效地处理原空间的任务,这一技术在模式识别领域又称为特征选择,特征选择的好坏往往对整个系统起到决定性的作用,但如何获取针对特定问题的特征,仍然是一个难点,一般地,由特征选择得到的特征空间的维数小于输入空间的维数,这就是通常所说的降维,因为传统的方法在处理高维问题时,容易导致维数灾难,即随着特征空间维数的升高,计算复杂性成指数增长。如果问题可以仅仅由特征空间中的内积表示,则高维空间中的特征向量的内积可以通过核函数用低维空间中的输入向量直接得到。避免了一般方法中的维数灾难。

例1:考虑如下映射phi;:R2→R3,phi;(x1,x2)=(x12,radic;2x1x22,x22), 在这种情况下,下标是指xisin;R2的分量。训练线性分离器会产生二次函数。虽然在特定示例中这种方法似乎是合情合理的,但是在计算上,这似乎是不可行的,它将大约需要花费3.7*1016次计算。

2.2通过核函数隐式映射

显然,上面那种方法是不可行的,我们必须找到计算上更简单的方法。

对于例1,我们有:

在上一节中,我们已经知道,支持向量机算法仅与x的内积有关系,因此只要知道k(x,xlsquo;)而不是phi;,这使得我们可以再次使用支持向量最优化的方法:

同样地,公式(11)也可以写成如下形式:

和线性情况的区别在于,w不再是明确给出的,此外,还要注意在非线性情况下,优化问题所找的最平坦的函数是在特征空间内,而不是在输入空间内。

2.3一些基本定义

特征空间:假定x属于输入空间X,通过映射phi;将输入空间X映射到一个新的空间F上,F称为特征空间。

核矩阵:给定一个函数k:X2→K(其中K=C或K=R,R,C分别表示复数集和实数集)和模式x1hellip;hellip;xmisin;X,则mtimes;m矩阵Kij=k(xi,xj)称为关于x1hellip;hellip;xm的核矩阵。

正定核;令X为一非空集合,K是定义在Xtimes;X上的函数,如果K满足对所有的misin;N和x1hellip;hellip;xmisin;X都产生一个正定的核矩阵,则称其为正定核,简称核。

2.4再生核理论及Mercer定理

支持向量机的学习算法是将输入向量经过某个核函数,映射到某个高维空间中,在线性分开原输入向量的同时,考虑到使间隔达到最大,上述这些高维空间都可以认为是一RKHS。RKHS中的向量是一个泛函,而此函数通常是一个非线性函数同时RKHS又是一个线性空间,所以如果将输入向量,映射到RKHS,就能够利用线性空间中的方法解决非线性的问题。

2.5常见核函数

核函数的确定并不困难,满足Mercer定理的函数都可以作为核函数。常用的核函数可分为两类,即内积核函数和平移不变核函数,如:

1)高斯核函数K(x,xi) =exp(-||x-xi||2/2sigma;2;

2)多项式核函数K(x,xi)=(x·xi 1)^d, d=1,2,hellip;,N;

3)感知器核函数K(x,xi) =tanh(beta;xi b);

4)样条核函数K(x,xi) = B2n 1(x-xi)。

2.6 核函数的条件

现在出现的问题是哪些k(x,x)函数对应在某些特征空间F中的点积。以下定理表征这些函数(在X上定义)。

定理2:如果Kisin;Linfin;(x2)是一个对称实值函数,使得由它构造出来的X上的平方可积函数的积分算子TK:L2(X)→L2(X),

(TKf)(X):=int;K(x,y)f(y)dmu;(y) (20)

是正定的,即任取f属于L2(X),都有int;K(x,y)f(x)f(y)dmu;(x)mu;(y)ge;0。令psi;jisin;L2(X)为Tk的标准特征函数,对应的特征值为lambda;j>0,并以递减的顺序排列,那么:

(1)(lambda;j)jisin;l1。

(2)psi;jisin;Linfin;(x2),sup丨丨psi;j丨丨<infin;。

(3)K(x,y)=sum;j=1Nflambda;jpsi;j(x)psi;j(y)在X2上几乎处处成立,NFisin;N或NF=infin;,且NF=infin;时,上式右边的级数以在X2上几乎处处成立的方式绝对且一致收敛于点(x,y)。

2.6核函数的构造

核函数是作为一种非线性映射的隐式表达方法而提出的,这种隐式表达方法给分析映射的性质带来了不少困难,但是反过来,在知道非线性映射的情况下,构造与之对应的核函数,则是一件非常容易的事情,存在的最大问题时,核函数性能的好坏,直接取决于特征变换的好坏,但是,对于很多实际问题,找到合适的特征变换往往很困难。还有一种方法就是通过Mercer核函数的性质来构造核函数,即利用核函数集合在某些运算下封闭的特性,组合现有的一些核函数而构造出新的核函数。

3.罚函数

到目前为止,用于回归的支持向量机算法可能看起来很奇怪,并且与其它现有的方法或者函数几乎没有关系(e.g. Huber 1981, Stone 1985, Huml;ardle 1990, Hastie and Tibshirani 1990, Wahba 1990)。但是,一旦投入更多的标准数学运算,我们会发现支持向量机方法与先前其它方法的联系,为了简单起见,我们再次只考虑线性情况,至于对非线性情况的扩展已经在上一章通过核函数的方法描述了。

3.1风险函数

让我们回到第一,二节的情况中去,在那里我们有一些训练数据,我们现在假设,通过一些概率分布我们已经绘制出了这个训练集(独立和相同分布)。我们的目标将会是找到一个使期望风险最小的函数。

R[ f ] =int;c(x, y, f (x))dP(x, y) (21)

(c(x,y,f(x))表示一个罚函数,它基于训练集决定我们怎样“惩罚”估计的误差。知道了这些,我们不知道分布规律,我们只能用训练样本来评估方程f使R(f)最小,一个可能的近似值用来取代经验估计的整合,这就是所谓的经验风险泛函。

Remp[ f ] := sum;tt=1 c(xi , yi , f (xi ). (22

剩余内容已隐藏,支付完成后下载完整资料

资料编号:[141847],资料为PDF文档或Word文档,PDF文档可免费转换为Word