基于深度学习的转移癌检测外文翻译资料

2022-08-09 11:24:04

英语原文共 6 页,剩余内容已隐藏,支付完成后下载完整资料

基于深度学习的转移癌检测

作者:Dayong Wang;Aditya Khosla;Rishab Gargeya;Humayun Irshad; Andrew H Beck

所属机构:Beth Israel Deaconess Medical Center;Harvard Medical School; CSAIL;Massachusetts Institute of Technology

摘要

国际生物医学影像研讨会(ISBI)提出了一项巨大挑战,以评估在前哨淋巴结活检的整个幻灯片图像中自动检测转移性乳腺癌的计算机系统。 在整个挑战中,我们的团队在两项比赛中均获胜,在全幻灯片级图像分类任务下获得接收曲线下的面积(AUC)为0.925,在肿瘤定位任务下的得分为0.7051。 病理学家独立检查了相同的图像,获得了0.966的全幻灯片级图像分类得分(AUC)和0.733的肿瘤定位评分。 将我们的深度学习系统的预测与人类病理学家的诊断相结合,病理学家的AUC值提高到了0.995,这意味着人为错误率将降低了约85%。 这些结果证明了使用深度学习以显著改善病理诊断的准确性的力量。

1 绪论

病理学的医学职能是提供明确的疾病诊断,以指导患者治疗和管理决策[4],标准化,准确和可重复的病理诊断对于推进精密医学至关重要,自19世纪中叶以来,显微镜一直是病理学家用来诊断的主要工具[1]。显微图像定性视觉分析的局限性包括缺乏标准化,诊断错误以及要求病理学家在每一个普通的工作日中从数百个幻灯片图像中手动评估数百万个细胞的巨大负担[15,17,7]。因此,在过去的几十年中,人们对开发有助于在病理学中分析显微图像的计算方法的兴趣日益浓厚[9,8]。

从2015年10月到2016年4月,国际生物医学影像研讨会(ISBI)举行了里昂大挑战2016(Camelyon16)来确定性能最佳的计算图像分析系统,以自动检测前哨淋巴结活检的全幻灯片级图像(WSI)中的转移性乳腺癌。 乳房前哨淋巴结的评估是美国癌症联合委员会TNM乳腺癌分期系统的重要组成部分,在该系统中,前哨淋巴结转移癌呈阳性的患者将比前哨淋巴结转移癌呈阴性的患者接受更高的病理TNM分期[6]。这将经常导致更积极的临床管理,包括腋窝淋巴结清扫[13,14]。

对前哨淋巴结进行人工病理学检查既费时又费力,特别是在淋巴结对癌症阴性或仅含有少量转移癌的情况下,许多中心已经实现通过免疫组化对全细胞角蛋白进行前哨淋巴结的检测[5],它们是在乳腺癌细胞上表达的蛋白质,通常不存在于淋巴结中,以提高癌症转移检测的敏感性。然而,前哨淋巴结全细胞角蛋白免疫组织化学测试的局限性包括:成本增加,玻片制备时间增加以及病理学检查所需玻片数量增加。此外,即使使用免疫组织化学染色的载玻片,小癌转移的鉴定也可能是乏味且不准确的。

目前,计算机辅助图像分析系统已经被开发出来以帮助从全细胞角蛋白染色的前哨淋巴结免疫切片中检测小转移灶[22];但是,这些系统并未在临床上使用。 因此,开发有效且成本低廉的前哨淋巴结评估方法仍然是研究的活跃领域[11],因为一个高性能的以低成本提高准确性并减少认知负担的系统是极有价值的。

在这里,我们提出了一种基于深度学习的方法,用于从乳房前哨淋巴结的全幻灯片级图像中识别癌症转移。我们的方法使用数百万个训练补丁来训练深层卷积神经网络,以做出补丁级别的预测,以区分肿瘤补丁与正常补丁。然后,我们汇总补丁图像级别的预测以创建肿瘤概率热点图,并在这些热点图上执行后处理,以针对基于全幻灯片级图像的分类任务和肿瘤定位任务进行预测。我们的系统在2016年Camelyon大挑战赛中双双夺冠,其性能接近人类水平的准确性。最后,将我们的深度学习系统的预测与病理学家的解释相结合,可以大大降低病理学家的错误率。

2 数据集及评估指标

在本节中,我们描述了比赛组织者提供的Camelyon16数据集以及用于对参赛者进行排名的评估指标。

2.1 Camelyon16数据集

Camelyon16数据集包括总共400张全幻灯片级图像(WSI),分为270张用于训练和130张用于测试。这两个部分都包含来自两个机构(拉德堡德大学和乌得勒支大学)的样本,表1中提供了特定的详细信息。

表1:Camelyon16数据集中的幻灯片数量

|

机构 |

训练集中的肿瘤样本 |

训练集中的正常样本 |

测试集 |

|

拉德堡德大学 |

90 |

70 |

80 |

|

乌得勒支大学 |

70 |

40 |

50 |

|

合计 |

160 |

110 |

130 |

训练集中WSI的对应真实标签数据包括病理学家对前哨淋巴结的WSI上的转移癌区域的描绘。这些数据以两种格式提供:包含癌转移位置的折点轮廓的软标注的XML文件和用于指示癌症转移的位置的WSI二进制掩码。

2.2 评估指标

根据以下两个指标评估了参赛作品:

幻灯片级别的评估:对于此指标,要评估团队在区分包含转移癌的载玻片和正常载玻片方面的表现。竞赛参与者为每个测试幻灯片提交了一个概率,表明预测其患癌的可能性。竞赛组织者使用接收器工作特性以下的区域(AUC得分)来衡量参与者的表现。

病灶级别的评估:对于此指标,参与者针对WSI中的每个预测的癌症病变区域提交概率值和相应的(x,y)位置。 竞赛组织者以6个假阳性率(每个WSI分别为1/4、1/2、1、2、4和8个假阳性)检测WSI中所有真实癌症病变的平均敏感性进而衡量参与者的表现。

3 方法

在本节中,我们描述了我们的转移性癌症的检测方法。

3.1 图像预处理

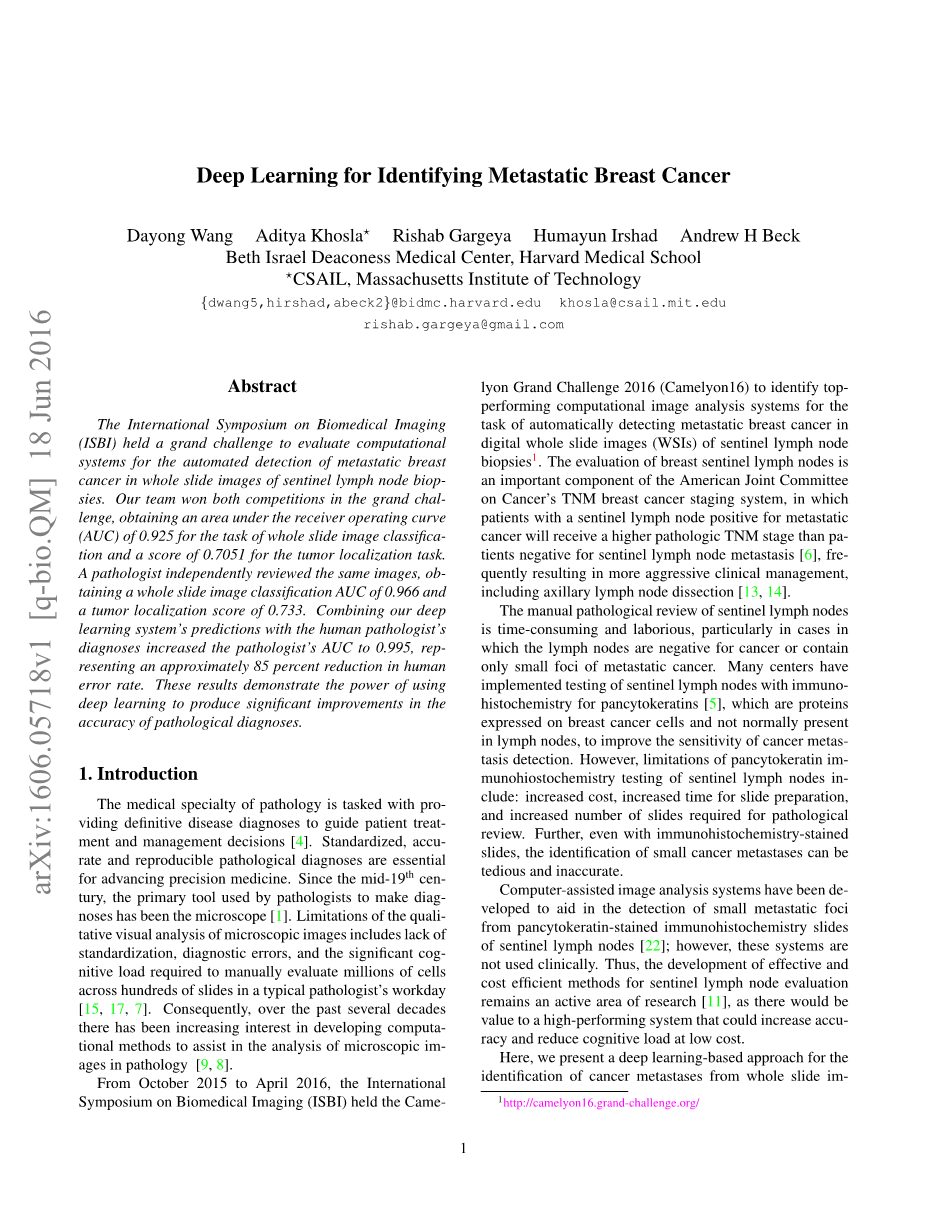

图1:图像预处理过程中组织区域检测的可视化(在第3.1节中介绍),检测到的组织区域以绿色曲线突出显示

为了减少计算时间并使我们的分析集中于最可能包含癌症转移的玻片区域,我们首先在WSI内识别组织部分,并排除背景空白。为此,我们采用基于阈值的分割方法来自动检测背景区域。 特别地,我们首先将原始图像从RGB颜色空间转换到HSV颜色空间,然后使用Otsu算法计算每个通道下的最优阈值[16],通过合并来自H和S通道的掩码进而生成最终的掩码图像。其检测结果显示在图1中,其中使用绿色曲线突出显示了组织区域。根据检测结果,每个WSI的背景区域平均百分比约为82%。

3.2 转移癌检测框架

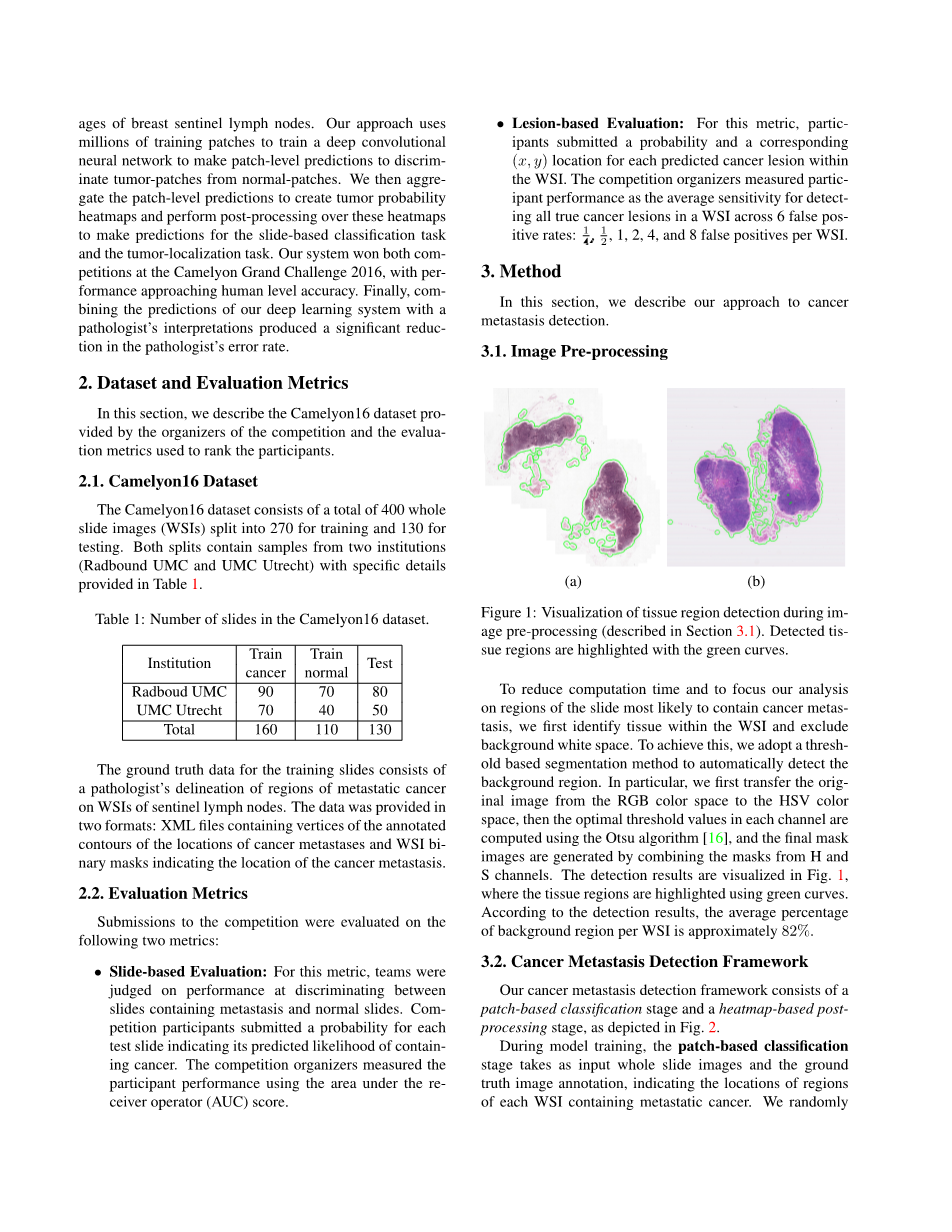

我们的转移癌检测框架包括基于补丁的分类阶段和基于热点图的后处理阶段,如图2所示。

图2:检测转移性癌症的框架

在模型训练期间,基于补丁的分类阶段将WSI和指示每个包含转移性癌症的WSI区域的位置的真实标记数据作为输入。我们从训练的WSI集中随机抽取数百万个小的阳性/阴性补丁图像。如果小补丁位于肿瘤区域,则为肿瘤/阳性补丁,标记为1,否则为正常/阴性补丁,标记为0。在选择了阳性/阴性训练样本之后,我们训练了监督分类模型以区分这两种补丁,并将所有预测结果嵌入热点图图像。在基于热图的后期处理阶段,我们使用肿瘤概率热点图为每个WSI计算基于全幻灯片级的评估和基于病灶的评估得分。

3.3 补丁分类阶段

在训练期间,此阶段使用来自WSI阳性/阴性区域的256x256像素色块作为输入,并训练一个分类模型以区分阳性块和阴性块。 我们为此分类任务评估了四种著名的深度学习网络架构的性能:GoogLeNet [20],AlexNet [12],VGG16 [19]和面向人脸的深度网络[21],如表2所示。这两个更深层的网络(GoogLeNet和VGG16)实现了基于补丁的最佳分类性能。在我们的框架中,我们采用GoogLeNet作为我们的深度网络结构,因为它通常比VGG16更快,更稳定。 GoogLeNet的网络结构共包括27层,超过600万个参数。

表2:各种深度模型的评估

|

补丁图像分类准确率 |

|

|

GoogLeNet[20] |

98.4% |

|

AlexNet[12] |

92.1% |

|

VGG16[19] |

97.9% |

|

FaceNet[21] |

96.8% |

在我们的实验中,我们评估了放大倍数范围,包括40倍,20倍和10倍,并且在40倍放大倍数下获得了最佳性能。 在针对Camelyon比赛的实验结果中,我们仅使用40倍放大倍数。在整个训练数据集上使用GoogLeNet生成了肿瘤概率热点图之后,我们注意到,很大一部分错误是由于癌症的组织学模拟的假阳性分类所致。为了提高在这些区域上的模型性能,我们从这些困难的阴性区域提取额外的训练示例,并使用富含这些困难的阴性补丁的训练集对模型进行再训练。

我们在图3中给出了我们所获得的其中一个结果。给定一个完整的幻灯片图像(图3(a))和基于改进学习的补丁分类模型,我们生成了相应的肿瘤区域热点图(图3(b)),该图突出了肿瘤区域。

图3:肿瘤区域检测可视化

3.4 肿瘤热点图的后处理以计算基于幻灯片级和基于病灶级的概率

在基于补丁的分类阶段完成后,我们为每个WSI生成一个肿瘤概率热点图。 在这些热点图上,每个像素包含一个介于0和1之间的值,指示该像素包含肿瘤的概率。现在,我们执行后处理,以计算每个热点图的基于幻灯片级和基于病灶级的得分。

3.4.1 幻灯片级的分类

对于基于幻灯片的分类任务,后处理将每个WSI的热点图作为输入,并针对整个WSI将转移癌的产生概率作为输出。给定一个热点图,我们从每个热点图中提取28个几何和形态特征,包括整个组织区域中肿瘤区域的百分比,肿瘤区域与最小周围凸区域之间的面积比,平均预测值以及肿瘤区域的最长轴。我们在所有训练样本的肿瘤概率热点图上计算这些特征,并建立一个随机森林分类器,以将WSI与转移性阴性WSI区别开来。在测试案例中,我们基于WSI的分类方法获得的AUC为0.925,使其成为Camelyon挑战赛中基于WSI的分类任务的最佳性能系统。

3.4.2 病灶级的检测

对于基于病灶的检测后处理,我们旨在识别每个WSI中几乎没有假阳性的所有癌症病变区域。为此,我们首先使用上述初始训练数据集训练一个深度模型(D-I)。然后,我们使用训练集训练第二个深度模型(D-II),该训练集富含邻近肿瘤的阴性区域。此模型(D-II)产生的误差要少于D-I,但灵敏度降低。在我们的框架中,我们首先使用D-1并设定0.90为阈值,从而创建了二进制热点图。然后,我们在肿瘤二元掩码图像内确定连通域,并使用中心点作为每个连通域的肿瘤位置。为了估计这些(x,y)位置的每个肿瘤的概率,我们取D-I和D-II针对每个连通域所生成的肿瘤概率预测的平均值。 Camelyon16的评分指标定义为6个预定义的假阳性率的平均灵敏度:每张幻灯片图像1 / 4、1 / 2、1、2、4和8个FP。我们的系统获得了0.7051的最高分,这是比赛中最高的分数,比第二名的分数(0.5761)高出22%。

4 实验结果

4.1 来自camelyon16的评估结果

在本节中,我们简要介绍Camelyon16组织者生成的评估结果,该评估结果也可以在网站上获得。Camelyon16中有两种评估:基于幻灯片级的评估和基于病灶级的评估。我们赢得了这两项具有挑战性的任务。基于幻灯片级的评估:评估了算法的优劣,以区分包含转移癌的WSI和正常WSI。进行了WSI级别的接收器工作特性(ROC)分析,并在ROC曲线(AUC)下比较了算法的性能。我们提交的结果是根据第3.4.1节中的算法生成的。如图4所示,AUC为0.9250。请注意,当误报率(FPR)低时,我们的算法的性能要比第二好的方法好得多。

图4:基于幻灯片级的分类的接收器工作特性(ROC)曲线

基于病灶级的评估:对于病灶的评估,使用了自由响应接收器工作特性(FROC)曲线。FROC曲线定义为灵敏度与每个图像假阳性平均数的关系图。我们提交的结果是根据第3.4.2节中的算法生成的。如图5所示,我们可以得出两个观察结果:首先,病理学家没有做出任何假阳性预测;其次,当假阳性的平均数量大于2时,这表明每张WSI平均会有两个假阳性警报,我们的表现(就敏感性而言)甚至超过了病理学家。

图5:基于病变的检测的自由响应接收器工作特性(FROC)曲线

4.2 将深度学习系统与人类病理学家相结合

为了评估针对人类病理学家的顶级深度学习系统,Camelyon16的组织者让病理学家检查了比赛中使用的测试图像。对于基于幻灯片级的分类任务,人类病理学家达到了0.9664的AUC,反映了3.4%的错误率。当我们将深度学习系统的预测与人类病理学家的预测相结合时,AUC升至0.9948,这表明错误率下降至0.52

剩余内容已隐藏,支付完成后下载完整资料

资料编号:[239419],资料为PDF文档或Word文档,PDF文档可免费转换为Word

课题毕业论文、开题报告、任务书、外文翻译、程序设计、图纸设计等资料可联系客服协助查找。